Pandas GroupBy 和 Count Distinct 操作详解

参考:pandas groupby count distinct

Pandas是Python中用于数据分析和处理的强大库,其中GroupBy和Count Distinct是两个常用且重要的操作。本文将深入探讨这两个操作的使用方法、应用场景以及相关技巧,帮助您更好地掌握Pandas中的数据处理技能。

1. Pandas GroupBy 简介

GroupBy操作是数据分析中的一个核心概念,它允许我们将数据按照某个或某些列进行分组,然后对每个组应用特定的操作。在Pandas中,GroupBy操作非常灵活且功能强大,可以与多种聚合函数结合使用。

1.1 基本用法

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 按name列进行分组并计算sales列的总和

result = df.groupby('name')['sales'].sum()

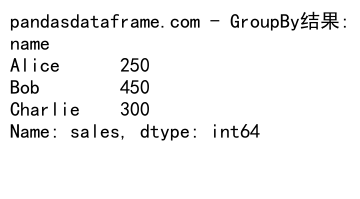

print("pandasdataframe.com - GroupBy结果:")

print(result)

Output:

在这个例子中,我们首先创建了一个包含名字、城市和销售额的DataFrame。然后,我们使用groupby('name')按名字进行分组,并计算每个人的总销售额。

1.2 多列分组

Pandas还支持按多个列进行分组:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'category': ['A', 'B', 'A', 'B', 'A'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 按name和city列进行分组并计算sales列的平均值

result = df.groupby(['name', 'city'])['sales'].mean()

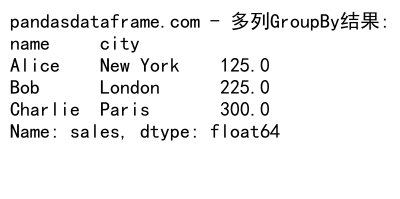

print("pandasdataframe.com - 多列GroupBy结果:")

print(result)

Output:

这个例子展示了如何按名字和城市进行分组,并计算每个组的平均销售额。

2. Count Distinct 操作

Count Distinct是一种统计操作,用于计算某一列中不重复值的数量。在数据分析中,这个操作常用于了解数据的多样性或唯一性。

2.1 基本用法

Pandas没有直接的count_distinct函数,但我们可以通过组合其他函数来实现这个功能:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'],

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z']

}

df = pd.DataFrame(data)

# 计算product列的不重复值数量

distinct_count = df['product'].nunique()

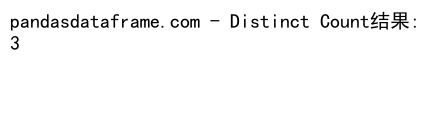

print("pandasdataframe.com - Distinct Count结果:")

print(distinct_count)

Output:

在这个例子中,我们使用nunique()函数来计算’product’列中不重复值的数量。

2.2 结合GroupBy使用

Count Distinct操作经常与GroupBy结合使用,以计算每个组内的不重复值数量:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'],

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z'],

'customer': ['C1', 'C2', 'C3', 'C1', 'C2', 'C4', 'C3']

}

df = pd.DataFrame(data)

# 按category分组,计算每个类别中不重复的product数量

result = df.groupby('category')['product'].nunique()

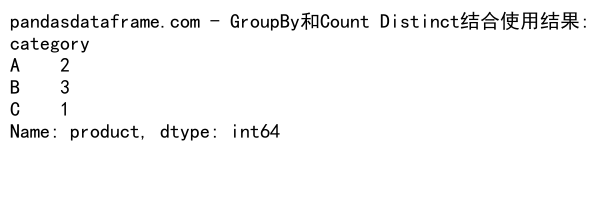

print("pandasdataframe.com - GroupBy和Count Distinct结合使用结果:")

print(result)

Output:

这个例子展示了如何按类别分组,并计算每个类别中不重复产品的数量。

3. 高级GroupBy技巧

3.1 多个聚合函数

Pandas允许在一个GroupBy操作中应用多个聚合函数:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250],

'units': [10, 20, 30, 15, 25]

}

df = pd.DataFrame(data)

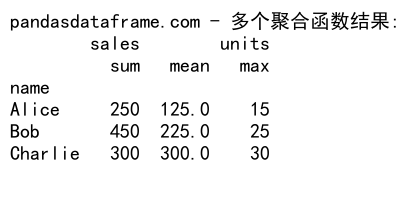

# 按name分组,同时计算sales的总和和平均值,以及units的最大值

result = df.groupby('name').agg({

'sales': ['sum', 'mean'],

'units': 'max'

})

print("pandasdataframe.com - 多个聚合函数结果:")

print(result)

Output:

这个例子展示了如何在一个GroupBy操作中同时计算多个统计量。

3.2 自定义聚合函数

除了内置的聚合函数,我们还可以使用自定义函数进行聚合:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

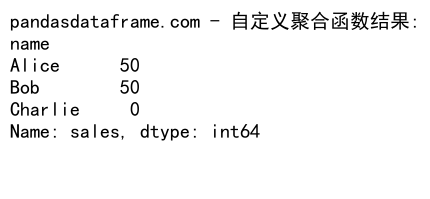

# 自定义函数:计算销售额的范围(最大值减最小值)

def sales_range(x):

return x.max() - x.min()

# 按name分组,应用自定义函数

result = df.groupby('name')['sales'].agg(sales_range)

print("pandasdataframe.com - 自定义聚合函数结果:")

print(result)

Output:

这个例子展示了如何创建和使用自定义聚合函数。

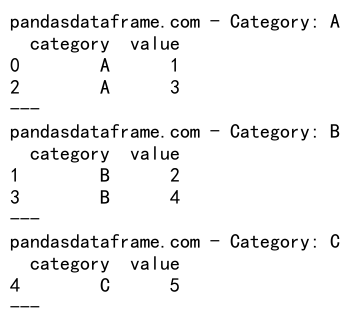

3.3 GroupBy对象的迭代

GroupBy对象可以被迭代,这允许我们对每个组进行更复杂的操作:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C'],

'value': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

# 迭代GroupBy对象

for name, group in df.groupby('category'):

print(f"pandasdataframe.com - Category: {name}")

print(group)

print("---")

Output:

这个例子展示了如何迭代GroupBy对象,这对于需要对每个组进行特定处理的场景非常有用。

4. Count Distinct的高级应用

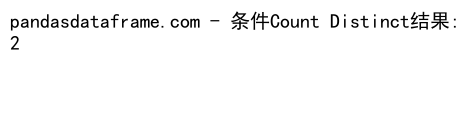

4.1 条件Count Distinct

有时我们需要在特定条件下计算不重复值的数量:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'],

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z'],

'sales': [100, 200, 300, 150, 250, 180, 220]

}

df = pd.DataFrame(data)

# 计算sales大于200的不重复product数量

result = df[df['sales'] > 200]['product'].nunique()

print("pandasdataframe.com - 条件Count Distinct结果:")

print(result)

Output:

这个例子展示了如何计算满足特定条件(销售额大于200)的不重复产品数量。

4.2 Rolling Count Distinct

在时间序列数据中,我们可能需要计算滚动窗口内的不重复值数量:

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=10),

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z', 'Y', 'X', 'Z']

}

df = pd.DataFrame(data)

df.set_index('date', inplace=True)

# 计算3天滚动窗口内的不重复产品数量

result = df['product'].rolling('3D').agg(lambda x: x.nunique())

print("pandasdataframe.com - Rolling Count Distinct结果:")

print(result)

这个例子展示了如何计算3天滚动窗口内的不重复产品数量。

5. GroupBy和Count Distinct的结合应用

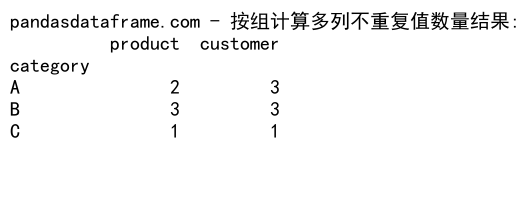

5.1 按组计算多个列的不重复值数量

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'],

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z'],

'customer': ['C1', 'C2', 'C3', 'C1', 'C2', 'C4', 'C3']

}

df = pd.DataFrame(data)

# 按category分组,计算product和customer的不重复值数量

result = df.groupby('category').agg({

'product': 'nunique',

'customer': 'nunique'

})

print("pandasdataframe.com - 按组计算多列不重复值数量结果:")

print(result)

Output:

这个例子展示了如何按类别分组,并同时计算每个类别中不重复的产品和客户数量。

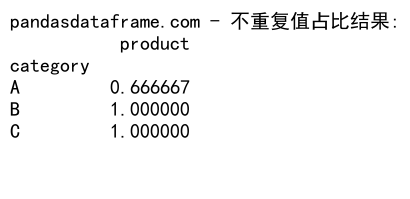

5.2 计算不重复值占比

有时我们需要计算不重复值占总数的比例:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'],

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z']

}

df = pd.DataFrame(data)

# 计算每个类别中不重复产品的占比

result = df.groupby('category').agg({

'product': lambda x: x.nunique() / len(x)

})

print("pandasdataframe.com - 不重复值占比结果:")

print(result)

Output:

这个例子计算了每个类别中不重复产品数量占该类别总产品数量的比例。

6. 性能优化技巧

在处理大型数据集时,GroupBy和Count Distinct操作可能会变得很慢。以下是一些优化技巧:

6.1 使用categoricals

对于包含重复值较多的列,将其转换为categorical类型可以提高性能:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C'] * 1000,

'value': range(5000)

}

df = pd.DataFrame(data)

# 将category列转换为categorical类型

df['category'] = df['category'].astype('category')

# 进行GroupBy操作

result = df.groupby('category')['value'].mean()

print("pandasdataframe.com - 使用categoricals后的结果:")

print(result)

这个例子展示了如何将列转换为categorical类型,这在处理大型数据集时可以显著提高性能。

6.2 使用numba加速

对于自定义聚合函数,可以使用numba来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

np.random.seed(0)

df = pd.DataFrame({

'group': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

})

@jit(nopython=True)

def custom_agg(values):

return np.mean(values) * np.std(values)

# 使用numba加速的自定义聚合函数

result = df.groupby('group')['value'].agg(custom_agg)

print("pandasdataframe.com - 使用numba加速后的结果:")

print(result)

这个例子展示了如何使用numba来加速自定义聚合函数的计算。

7. 实际应用场景

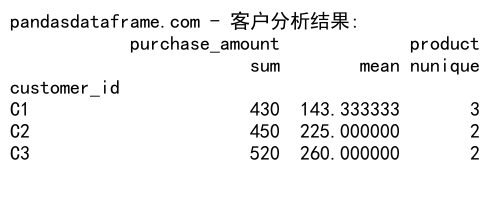

7.1 客户分析

在客户分析中,我们经常需要计算每个客户的不同指标:

import pandas as pd

# 创建示例数据

data = {

'customer_id': ['C1', 'C2', 'C1', 'C3', 'C2', 'C1', 'C3'],

'product': ['A', 'B', 'C', 'A', 'A', 'B', 'C'],

'purchase_amount': [100, 200, 150, 300, 250, 180, 220]

}

df = pd.DataFrame(data)

# 计算每个客户的总购买金额、平均购买金额和不同产品数量

result = df.groupby('customer_id').agg({

'purchase_amount': ['sum', 'mean'],

'product': 'nunique'

})

print("pandasdataframe.com - 客户分析结果:")

print(result)

Output:

这个例子展示了如何分析每个客户的购买行为,包括总购买金额、平均购买金额和购买的不同产品数量。

7.2 时间序列分析在时间序列分析中,我们经常需要按时间间隔进行分组和统计:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'sales': np.random.randint(100, 1000, size=len(dates)),

'product': np.random.choice(['A', 'B', 'C'], size=len(dates))

}

df = pd.DataFrame(data)

# 按月分组,计算每月的总销售额和不同产品数量

df['month'] = df['date'].dt.to_period('M')

result = df.groupby('month').agg({

'sales': 'sum',

'product': 'nunique'

})

print("pandasdataframe.com - 时间序列分析结果:")

print(result)

这个例子展示了如何按月份对销售数据进行分组,并计算每月的总销售额和销售的不同产品数量。

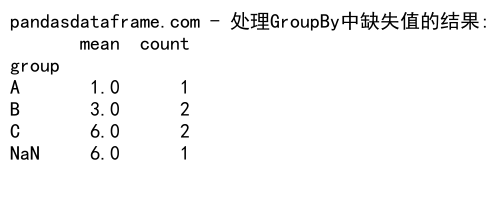

8. 处理缺失值

在进行GroupBy和Count Distinct操作时,处理缺失值是一个常见的挑战:

8.1 GroupBy中的缺失值处理

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'C', np.nan, 'C'],

'value': [1, 2, np.nan, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 处理缺失值

result = df.groupby('group', dropna=False)['value'].agg(['mean', 'count'])

print("pandasdataframe.com - 处理GroupBy中缺失值的结果:")

print(result)

Output:

这个例子展示了如何在GroupBy操作中处理缺失值,包括组名中的缺失值和组内数据的缺失值。

8.2 Count Distinct中的缺失值处理

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'],

'product': ['X', 'Y', np.nan, 'X', 'Y', 'X', np.nan]

}

df = pd.DataFrame(data)

# 计算不重复产品数量,包括和不包括缺失值

result_with_na = df.groupby('category')['product'].nunique(dropna=False)

result_without_na = df.groupby('category')['product'].nunique()

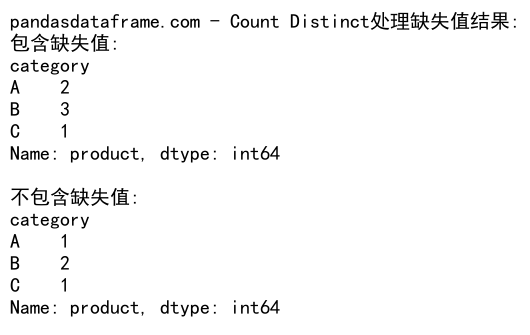

print("pandasdataframe.com - Count Distinct处理缺失值结果:")

print("包含缺失值:")

print(result_with_na)

print("\n不包含缺失值:")

print(result_without_na)

Output:

这个例子展示了在计算不重复值数量时如何处理缺失值,分别展示了包含和不包含缺失值的结果。

9. 高级GroupBy技巧

9.1 使用transform进行组内操作

transform方法允许我们对每个组应用一个函数,并将结果广播回原始DataFrame的形状:

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

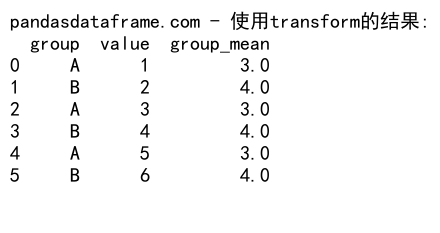

# 使用transform计算每个组的平均值,并添加为新列

df['group_mean'] = df.groupby('group')['value'].transform('mean')

print("pandasdataframe.com - 使用transform的结果:")

print(df)

Output:

这个例子展示了如何使用transform方法计算每个组的平均值,并将结果添加为新列。

9.2 使用apply进行复杂的组操作

apply方法允许我们对每个组应用更复杂的自定义函数:

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'A', 'B'],

'value1': [1, 2, 3, 4, 5, 6],

'value2': [10, 20, 30, 40, 50, 60]

}

df = pd.DataFrame(data)

# 定义自定义函数

def custom_func(group):

return pd.Series({

'value1_sum': group['value1'].sum(),

'value2_mean': group['value2'].mean(),

'combined': (group['value1'] * group['value2']).mean()

})

# 使用apply应用自定义函数

result = df.groupby('group').apply(custom_func)

print("pandasdataframe.com - 使用apply的复杂操作结果:")

print(result)

这个例子展示了如何使用apply方法对每个组应用复杂的自定义函数,计算多个统计量。

10. 高级Count Distinct技巧

10.1 使用set进行高效的Count Distinct

对于大型数据集,使用Python的set可能比Pandas的nunique更高效:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'C', 'A', 'B'] * 1000000,

'product': ['X', 'Y', 'Z', 'X', 'Y', 'X', 'Z'] * 1000000

}

df = pd.DataFrame(data)

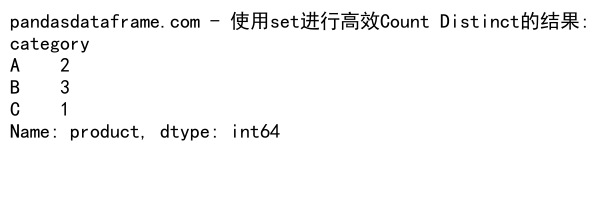

# 使用set进行高效的Count Distinct

result = df.groupby('category')['product'].agg(lambda x: len(set(x)))

print("pandasdataframe.com - 使用set进行高效Count Distinct的结果:")

print(result)

Output:

这个例子展示了如何使用Python的set来高效地计算大型数据集中的不重复值数量。

10.2 近似Count Distinct

对于超大型数据集,可以使用近似算法来估算不重复值的数量:

import pandas as pd

import numpy as np

from datasketch import HyperLogLog

# 创建示例数据

np.random.seed(0)

data = {

'category': np.random.choice(['A', 'B', 'C'], 10000000),

'product': np.random.randint(0, 1000000, 10000000)

}

df = pd.DataFrame(data)

# 使用HyperLogLog进行近似Count Distinct

def hll_count(x):

hll = HyperLogLog()

for item in x:

hll.update(str(item).encode('utf8'))

return len(hll)

result = df.groupby('category')['product'].agg(hll_count)

print("pandasdataframe.com - 使用HyperLogLog进行近似Count Distinct的结果:")

print(result)

这个例子展示了如何使用HyperLogLog算法来估算大型数据集中每个类别的不重复产品数量。

11. 结合其他Pandas功能

11.1 结合merge和GroupBy

有时我们需要在进行GroupBy操作之前合并多个DataFrame:

import pandas as pd

# 创建示例数据

sales_data = pd.DataFrame({

'product_id': [1, 2, 3, 1, 2],

'sales': [100, 200, 300, 150, 250]

})

product_info = pd.DataFrame({

'product_id': [1, 2, 3],

'category': ['A', 'B', 'A']

})

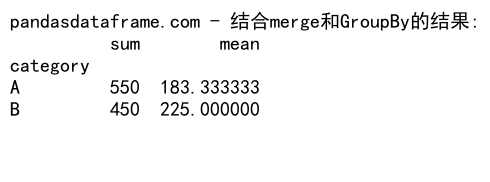

# 合并数据并进行GroupBy操作

merged_df = pd.merge(sales_data, product_info, on='product_id')

result = merged_df.groupby('category')['sales'].agg(['sum', 'mean'])

print("pandasdataframe.com - 结合merge和GroupBy的结果:")

print(result)

Output:

这个例子展示了如何先合并销售数据和产品信息,然后按产品类别进行分组统计。

11.2 结合pivot_table和Count Distinct

pivot_table函数可以与Count Distinct操作结合使用,创建更复杂的汇总表:

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=100),

'product': np.random.choice(['A', 'B', 'C'], 100),

'region': np.random.choice(['East', 'West', 'North', 'South'], 100),

'sales': np.random.randint(100, 1000, 100)

}

df = pd.DataFrame(data)

# 使用pivot_table和Count Distinct

result = pd.pivot_table(df, values='sales', index='product',

columns='region', aggfunc=['sum', pd.Series.nunique])

print("pandasdataframe.com - 结合pivot_table和Count Distinct的结果:")

print(result)

这个例子创建了一个透视表,显示每个产品在每个地区的总销售额和不重复销售额数量。

12. 处理大规模数据

当处理大规模数据时,内存管理和性能优化变得尤为重要。以下是一些处理大规模数据的技巧:

12.1 使用chunks处理大文件

对于无法一次性加载到内存的大文件,可以使用chunks进行分块处理:

import pandas as pd

# 假设我们有一个大型CSV文件 'large_file.csv'

chunk_size = 10000

result = pd.DataFrame()

for chunk in pd.read_csv('large_file.csv', chunksize=chunk_size):

# 对每个chunk进行处理

processed = chunk.groupby('category')['value'].sum()

result = result.add(processed, fill_value=0)

print("pandasdataframe.com - 使用chunks处理大文件的结果:")

print(result)

这个例子展示了如何使用chunks来处理大型CSV文件,逐块读取并处理数据。

12.2 使用dask进行并行计算

对于超大规模数据,可以考虑使用dask库进行并行计算:

import dask.dataframe as dd

# 假设我们有一个大型CSV文件 'large_file.csv'

ddf = dd.read_csv('large_file.csv')

# 进行GroupBy和Count Distinct操作

result = ddf.groupby('category')['product'].nunique().compute()

print("pandasdataframe.com - 使用dask进行并行计算的结果:")

print(result)

这个例子展示了如何使用dask来处理大型数据集,利用并行计算提高处理速度。

13. 数据可视化

GroupBy和Count Distinct的结果通常需要进行可视化以便更好地理解数据:

13.1 使用matplotlib进行简单可视化

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'category': ['A', 'B', 'C', 'D', 'E'],

'value': [10, 20, 15, 25, 30]

}

df = pd.DataFrame(data)

# 创建柱状图

plt.figure(figsize=(10, 6))

df.plot(kind='bar', x='category', y='value')

plt.title('Category Values')

plt.xlabel('Category')

plt.ylabel('Value')

plt.savefig('pandasdataframe_com_category_values.png')

plt.close()

print("pandasdataframe.com - 图表已保存为 'pandasdataframe_com_category_values.png'")

这个例子展示了如何使用matplotlib创建一个简单的柱状图来可视化GroupBy的结果。

13.2 使用seaborn进行高级可视化

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'category': ['A', 'B', 'C', 'D', 'E'] * 20,

'value': np.random.randint(10, 100, 100)

}

df = pd.DataFrame(data)

# 创建箱线图

plt.figure(figsize=(12, 6))

sns.boxplot(x='category', y='value', data=df)

plt.title('Value Distribution by Category')

plt.savefig('pandasdataframe_com_value_distribution.png')

plt.close()

print("pandasdataframe.com - 图表已保存为 'pandasdataframe_com_value_distribution.png'")

这个例子展示了如何使用seaborn创建一个箱线图来可视化每个类别的值分布。

14. 实际应用案例

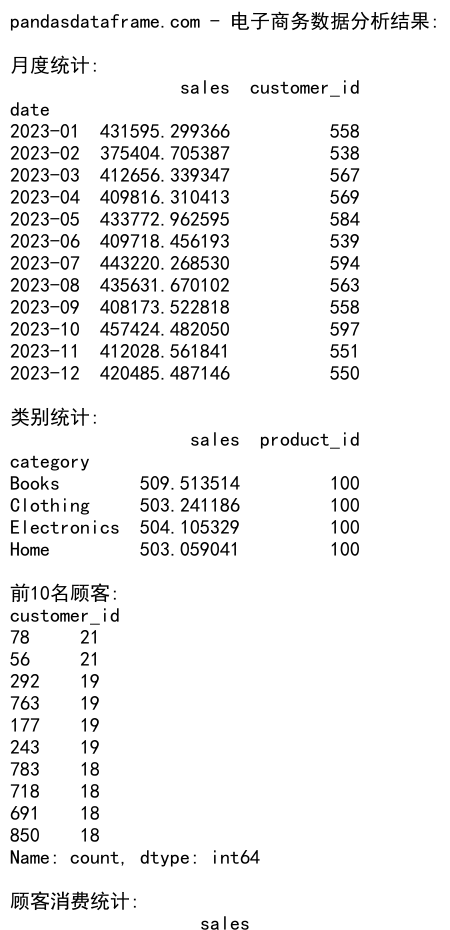

14.1 电子商务数据分析

假设我们有一个电子商务网站的订单数据:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': np.random.choice(dates, 10000),

'customer_id': np.random.randint(1, 1001, 10000),

'product_id': np.random.randint(1, 101, 10000),

'category': np.random.choice(['Electronics', 'Clothing', 'Books', 'Home'], 10000),

'sales': np.random.uniform(10, 1000, 10000)

}

df = pd.DataFrame(data)

# 1. 计算每月的总销售额和不同顾客数

monthly_stats = df.groupby(df['date'].dt.to_period('M')).agg({

'sales': 'sum',

'customer_id': 'nunique'

})

# 2. 计算每个类别的平均订单金额和不同产品数量

category_stats = df.groupby('category').agg({

'sales': 'mean',

'product_id': 'nunique'

})

# 3. 找出购买次数最多的前10名顾客

top_customers = df['customer_id'].value_counts().head(10)

# 4. 计算每个顾客的总消费金额和平均订单金额

customer_stats = df.groupby('customer_id').agg({

'sales': ['sum', 'mean']

})

print("pandasdataframe.com - 电子商务数据分析结果:")

print("\n月度统计:")

print(monthly_stats)

print("\n类别统计:")

print(category_stats)

print("\n前10名顾客:")

print(top_customers)

print("\n顾客消费统计:")

print(customer_stats.head())

Output:

这个例子展示了如何对电子商务数据进行多角度分析,包括时间趋势、类别分析、顾客行为等。

14.2 社交网络数据分析

假设我们有一个社交网络的用户互动数据:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

users = range(1, 1001)

data = {

'user_id': np.random.choice(users, 10000),

'friend_id': np.random.choice(users, 10000),

'interaction_type': np.random.choice(['like', 'comment', 'share'], 10000),

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D').repeat(27)[:10000]

}

df = pd.DataFrame(data)

# 1. 计算每个用户的好友数量

friend_count = df.groupby('user_id')['friend_id'].nunique()

# 2. 计算每种互动类型的频率

interaction_freq = df['interaction_type'].value_counts()

# 3. 找出互动最频繁的用户对

user_pairs = df.groupby(['user_id', 'friend_id']).size().sort_values(ascending=False).head(10)

# 4. 计算每月的总互动次数

monthly_interactions = df.groupby(df['date'].dt.to_period('M')).size()

print("pandasdataframe.com - 社交网络数据分析结果:")

print("\n用户好友数量:")

print(friend_count.head())

print("\n互动类型频率:")

print(interaction_freq)

print("\n互动最频繁的用户对:")

print(user_pairs)

print("\n月度互动次数:")

print(monthly_interactions)

这个例子展示了如何分析社交网络数据,包括用户关系、互动模式和时间趋势等。

15. 性能优化和最佳实践

在使用Pandas进行GroupBy和Count Distinct操作时,以下是一些性能优化和最佳实践的建议:

15.1 使用适当的数据类型

确保使用适当的数据类型可以显著提高性能:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'id': np.arange(1000000),

'category': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.rand(1000000)

}

df = pd.DataFrame(data)

# 优化数据类型

df['id'] = df['id'].astype('int32')

df['category'] = df['category'].astype('category')

# 进行GroupBy操作

result = df.groupby('category')['value'].mean()

print("pandasdataframe.com - 使用优化数据类型后的结果:")

print(result)

这个例子展示了如何通过使用适当的数据类型(如将字符串列转换为category类型)来优化性能。

15.2 使用索引进行快速查找

对于频繁查询的列,可以将其设置为索引以提高性能:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=100000, freq='H'),

'value': np.random.rand(100000)

}

df = pd.DataFrame(data)

# 将日期列设置为索引

df.set_index('date', inplace=True)

# 按月进行分组统计

result = df.groupby(df.index.to_period('M'))['value'].mean()

print("pandasdataframe.com - 使用索引进行快速查找的结果:")

print(result.head())

这个例子展示了如何将日期列设置为索引,然后进行高效的时间序列分组操作。

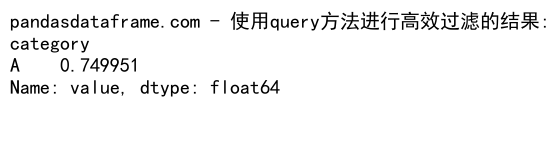

15.3 使用query方法进行高效过滤

对于大型DataFrame,使用query方法进行过滤可能比标准的布尔索引更高效:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'id': np.arange(1000000),

'category': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.rand(1000000)

}

df = pd.DataFrame(data)

# 使用query方法进行过滤

result = df.query('category == "A" and value > 0.5').groupby('category')['value'].mean()

print("pandasdataframe.com - 使用query方法进行高效过滤的结果:")

print(result)

Output:

这个例子展示了如何使用query方法进行高效的数据过滤和分组操作。

16. 结论

Pandas的GroupBy和Count Distinct操作是数据分析中非常强大和常用的工具。它们允许我们深入挖掘数据,发现隐藏的模式和趋势。通过本文的详细介绍和丰富的示例,我们探讨了这些操作的基本用法、高级技巧、性能优化以及实际应用场景。

关键要点总结:

1. GroupBy操作允许我们按一个或多个列对数据进行分组,并对每个组应用聚合函数。

2. Count Distinct用于计算不重复值的数量,常与GroupBy结合使用。

3. 处理大规模数据时,需要考虑内存管理和性能优化,如使用适当的数据类型、索引和查询方法。

4. 结合其他Pandas功能(如merge、pivot_table)可以进行更复杂的数据分析。

5. 可视化结果对于理解和展示数据分析结果至关重要。

通过掌握这些技能,数据分析师和科学家可以更有效地处理和分析各种类型的数据,从而做出更好的决策和洞察。随着数据量的不断增长和复杂性的提高,熟练运用这些工具将变得越来越重要。

最后,建议读者在实际项目中多加练习和应用这些技术,并持续关注Pandas的最新发展和更新,以不断提高数据处理和分析能力。

极客教程

极客教程