Pandas GroupBy 合并两列:高效数据分析与聚合技巧

参考:pandas groupby combine two columns

在数据分析和处理中,Pandas 的 GroupBy 操作是一个强大的工具,特别是当我们需要合并两列数据进行分组和聚合时。本文将深入探讨如何使用 Pandas 的 GroupBy 功能来合并两列,并通过实际示例展示这一技术的应用。我们将涵盖基本概念、常见操作、高级技巧以及实际应用场景,帮助您更好地理解和运用这一重要的数据处理方法。

1. GroupBy 基础概念

在开始探讨如何合并两列之前,我们首先需要理解 Pandas GroupBy 的基本概念。GroupBy 操作允许我们将数据分割成不同的组,然后对每个组应用函数。这在处理大型数据集时特别有用,可以帮助我们快速获取洞察和汇总信息。

1.1 GroupBy 的工作原理

GroupBy 的工作原理可以简单概括为”拆分-应用-合并”:

- 拆分:根据一个或多个键将数据分成组。

- 应用:对每个组应用一个函数。

- 合并:将结果组合成一个数据结构。

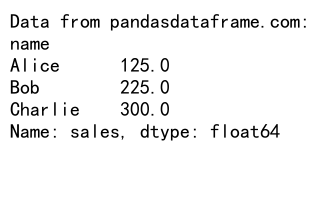

让我们通过一个简单的例子来说明这个过程:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 使用 GroupBy 按 name 分组并计算平均销售额

result = df.groupby('name')['sales'].mean()

print("Data from pandasdataframe.com:")

print(result)

Output:

在这个例子中,我们按 ‘name’ 列进行分组,然后计算每个人的平均销售额。GroupBy 操作自动处理了重复的名字,为我们提供了每个人的汇总信息。

1.2 GroupBy 对象的特性

GroupBy 对象具有以下重要特性:

- 迭代性:可以遍历每个组。

- 属性访问:可以直接访问原始 DataFrame 的列。

- 聚合:可以应用各种聚合函数,如 sum(), mean(), count() 等。

- 转换:可以应用自定义函数来转换数据。

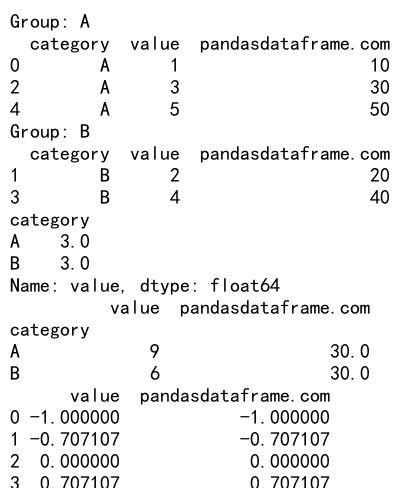

下面是一个展示这些特性的示例:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [1, 2, 3, 4, 5],

'pandasdataframe.com': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data)

# 创建 GroupBy 对象

grouped = df.groupby('category')

# 迭代每个组

for name, group in grouped:

print(f"Group: {name}")

print(group)

# 属性访问

print(grouped['value'].mean())

# 聚合

print(grouped.agg({'value': 'sum', 'pandasdataframe.com': 'mean'}))

# 转换

def normalize(x):

return (x - x.mean()) / x.std()

print(grouped.transform(normalize))

Output:

这个例子展示了 GroupBy 对象的多个特性,包括迭代、属性访问、聚合和转换。

2. 合并两列进行 GroupBy

现在我们已经了解了 GroupBy 的基础,让我们深入探讨如何合并两列进行 GroupBy 操作。这在处理多维度数据时特别有用,例如,当我们需要按照多个条件进行分组和分析时。

2.1 使用元组作为分组键

合并两列进行 GroupBy 的最简单方法是使用元组作为分组键。这允许我们同时考虑两个列的值进行分组。

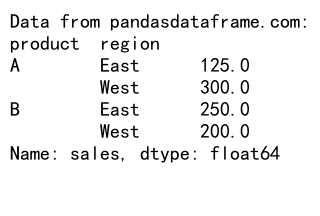

import pandas as pd

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A'],

'region': ['East', 'West', 'East', 'East', 'West'],

'sales': [100, 200, 150, 250, 300],

'pandasdataframe.com': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

# 使用元组作为分组键

grouped = df.groupby(['product', 'region'])

# 计算每个组的平均销售额

result = grouped['sales'].mean()

print("Data from pandasdataframe.com:")

print(result)

Output:

在这个例子中,我们使用 ‘product’ 和 ‘region’ 两列作为分组键。结果是一个多级索引的 Series,其中每个组合都有一个对应的平均销售额。

2.2 使用 agg 方法进行多列操作

当我们需要对多个列执行不同的聚合操作时,agg 方法非常有用:

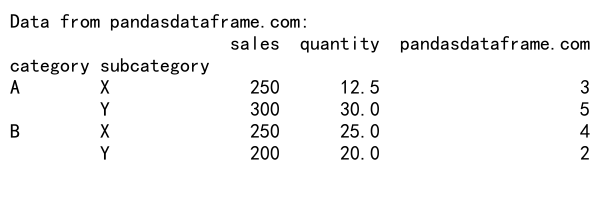

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A'],

'subcategory': ['X', 'Y', 'X', 'X', 'Y'],

'sales': [100, 200, 150, 250, 300],

'quantity': [10, 20, 15, 25, 30],

'pandasdataframe.com': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

# 使用 agg 方法进行多列操作

result = df.groupby(['category', 'subcategory']).agg({

'sales': 'sum',

'quantity': 'mean',

'pandasdataframe.com': 'max'

})

print("Data from pandasdataframe.com:")

print(result)

Output:

这个例子展示了如何对不同的列应用不同的聚合函数。我们对 ‘sales’ 列求和,对 ‘quantity’ 列求平均值,对 ‘pandasdataframe.com’ 列求最大值。

2.3 使用 transform 方法

transform 方法允许我们对分组后的数据应用函数,并返回与原始数据框相同形状的结果:

import pandas as pd

# 创建示例数据

data = {

'department': ['IT', 'HR', 'IT', 'HR', 'IT'],

'team': ['Dev', 'Recruit', 'QA', 'Train', 'Dev'],

'salary': [5000, 4000, 4500, 3500, 5500],

'pandasdataframe.com': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

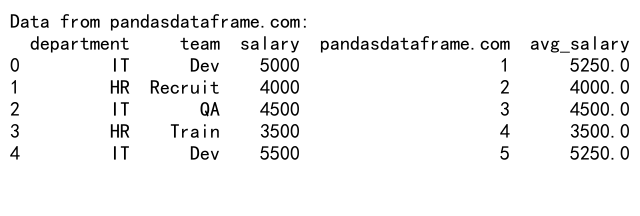

# 使用 transform 方法计算每个部门和团队的平均工资

df['avg_salary'] = df.groupby(['department', 'team'])['salary'].transform('mean')

print("Data from pandasdataframe.com:")

print(df)

Output:

在这个例子中,我们计算了每个部门和团队的平均工资,并将结果添加为新的列。transform 方法确保结果与原始数据框具有相同的索引。

3. 高级 GroupBy 技巧

掌握了基础知识后,让我们探索一些更高级的 GroupBy 技巧,这些技巧在处理复杂数据集时特别有用。

3.1 自定义聚合函数

有时,内置的聚合函数可能无法满足我们的需求。在这种情况下,我们可以定义自己的聚合函数:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A'],

'category': ['X', 'Y', 'X', 'Y', 'X'],

'sales': [100, 200, 150, 250, 300],

'pandasdataframe.com': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

# 定义自定义聚合函数

def custom_agg(x):

return pd.Series({

'total_sales': x['sales'].sum(),

'avg_sales': x['sales'].mean(),

'sales_range': x['sales'].max() - x['sales'].min(),

'pandasdataframe_sum': x['pandasdataframe.com'].sum()

})

# 应用自定义聚合函数

result = df.groupby(['product', 'category']).apply(custom_agg)

print("Data from pandasdataframe.com:")

print(result)

这个例子展示了如何创建一个自定义聚合函数,该函数计算总销售额、平均销售额、销售范围和 ‘pandasdataframe.com’ 列的总和。

3.2 使用 filter 方法

filter 方法允许我们基于组级别的条件来过滤数据:

import pandas as pd

# 创建示例数据

data = {

'city': ['New York', 'London', 'Paris', 'Tokyo', 'New York'],

'category': ['A', 'B', 'A', 'B', 'A'],

'sales': [100, 200, 150, 250, 300],

'pandasdataframe.com': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

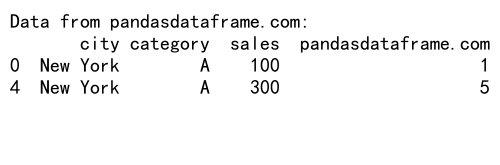

# 使用 filter 方法过滤总销售额大于 300 的城市

filtered = df.groupby('city').filter(lambda x: x['sales'].sum() > 300)

print("Data from pandasdataframe.com:")

print(filtered)

Output:

在这个例子中,我们只保留了总销售额超过 300 的城市的数据。

3.3 使用 groupby 和 apply 进行复杂操作

apply 方法允许我们对每个组应用任意的 Python 函数,这在进行复杂操作时非常有用:

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=10),

'category': ['A', 'B'] * 5,

'value': [10, 20, 30, 40, 50, 60, 70, 80, 90, 100],

'pandasdataframe.com': list(range(1, 11))

}

df = pd.DataFrame(data)

# 定义复杂操作函数

def complex_operation(group):

return pd.Series({

'max_value': group['value'].max(),

'min_value': group['value'].min(),

'range': group['value'].max() - group['value'].min(),

'last_date': group['date'].max(),

'pandasdataframe_sum': group['pandasdataframe.com'].sum()

})

# 应用复杂操作

result = df.groupby('category').apply(complex_operation)

print("Data from pandasdataframe.com:")

print(result)

这个例子展示了如何使用 apply 方法执行复杂的组级操作,包括计算最大值、最小值、范围、最后日期和 ‘pandasdataframe.com’ 列的总和。

4. 处理时间序列数据

在处理时间序列数据时,GroupBy 操作特别有用。我们可以按照时间间隔进行分组,并执行各种时间相关的分析。

4.1 按时间间隔分组

import pandas as pd

# 创建示例时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'value': range(len(dates)),

'pandasdataframe.com': [i % 10 for i in range(len(dates))]

}

df = pd.DataFrame(data)

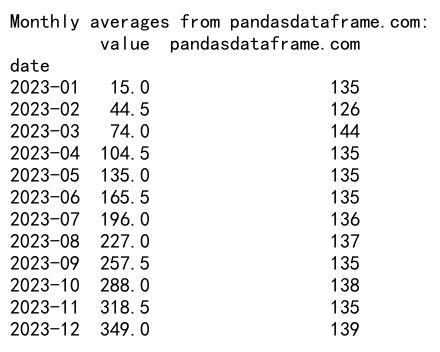

# 按月分组并计算平均值

monthly_avg = df.groupby(df['date'].dt.to_period('M')).agg({

'value': 'mean',

'pandasdataframe.com': 'sum'

})

print("Monthly averages from pandasdataframe.com:")

print(monthly_avg)

Output:

这个例子展示了如何按月对时间序列数据进行分组,并计算每月的平均值和 ‘pandasdataframe.com’ 列的总和。

4.2 滚动窗口计算

滚动窗口计算允许我们在移动的时间窗口内执行计算:

import pandas as pd

# 创建示例时间序列数据

dates = pd.date_range(start='2023-01-01', periods=100, freq='D')

data = {

'date': dates,

'value': range(100),

'pandasdataframe.com': [i % 10 for i in range(100)]

}

df = pd.DataFrame(data)

# 设置日期为索引

df.set_index('date', inplace=True)

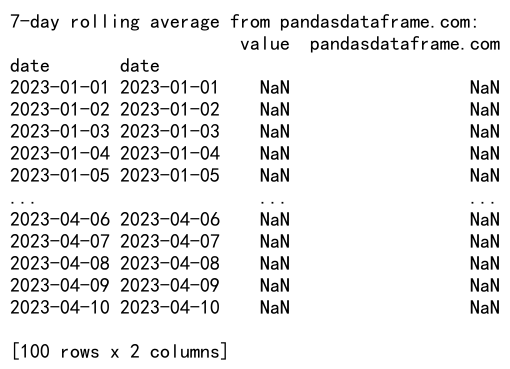

# 计算7天滚动平均

rolling_avg = df.groupby(pd.Grouper(freq='D')).rolling(window=7).mean()

print("7-day rolling average from pandasdataframe.com:")

print(rolling_avg)

Output:

这个例子计算了7天滚动平均值,这在分析趋势时非常有用。

5. 处理分类数据

当处理分类数据时,GroupBy 操作可以帮助我们深入了解不同类别之间的关系和差异。

5.1 计算类别频率

import pandas as pd

# 创建示例分类数据

data = {

'category': ['A', 'B', 'C', 'A', 'B', 'A', 'C', 'B', 'A', 'C'],

'subcategory': ['X', 'Y', 'X', 'Y', 'X', 'Y', 'X', 'Y', 'X', 'Y'],

'value': range(10),

'pandasdataframe.com': [i % 5 for i in range(10)]

}

df = pd.DataFrame(data)

# 计算类别频率

category_freq = df.groupby(['category', 'subcategory']).size().unstack(fill_value=0)

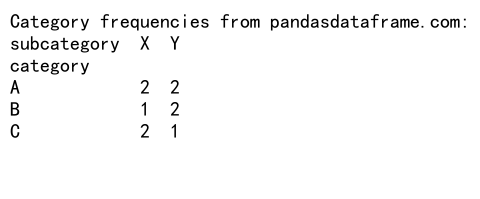

print("Category frequencies from pandasdataframe.com:")

print(category_freq)

Output:

这个例子计算了每个类别和子类别组合的频率,并将结果展示为一个交叉表。

5.2 计算类别内的百分比

import pandas as pd

# 创建示例分类数据

data = {

'category': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 20, 30, 40, 50, 60, 70, 80, 90, 100],

'pandasdataframe.com': range(10)

}

df = pd.DataFrame(data)

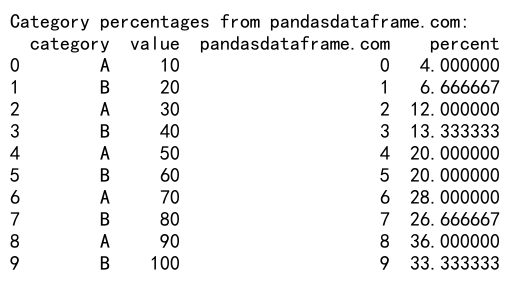

# 计算每个类别内的百分比

df['percent'] = df.groupby('category')['value'].transform(lambda x: x / x.sum() * 100)

print("Category percentages from pandasdataframe.com:")

print(df)

Output:

这个例子计算了每个类别内各个值占该类别总和的百分比。

6. 处理缺失值

在实际数据分析中,处理缺失值是一个常见的挑战。GroupBy 操作可以帮助我们有效地处理和分析包含缺失值的数据。

6.1 填充缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'A', 'B'],

'value': [1, np.nan, 3, np.nan, 5, 6],

'pandasdataframe.com': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

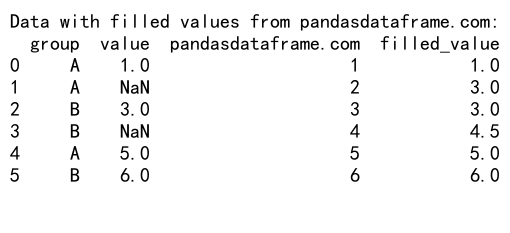

# 使用组平均值填充缺失值

df['filled_value'] = df.groupby('group')['value'].transform(lambda x: x.fillna(x.mean()))

print("Data with filled values from pandasdataframe.com:")

print(df)

Output:

这个例子展示了如何使用每个组的平均值来填充该组内的缺失值。

6.2 排除包含缺失值的组

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C', 'C'],

'value': [1, 2, np.nan, 4, 5, np.nan],

'pandasdataframe.com': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

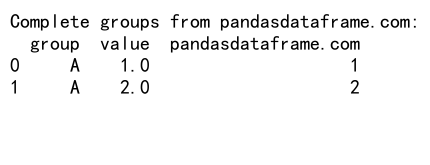

# 排除包含任何缺失值的组

complete_groups = df.groupby('group').filter(lambda x: x['value'].notna().all())

print("Complete groups from pandasdataframe.com:")

print(complete_groups)

Output:

这个例子展示了如何排除那些包含任何缺失值的组,只保留完整的组。

7. 高级数据转换

GroupBy 操作不仅可以用于简单的聚合,还可以用于复杂的数据转换和重塑。

7.1 数据透视表

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=10),

'product': ['A', 'B'] * 5,

'region': ['East', 'West', 'North', 'South', 'East'] * 2,

'sales': range(100, 200, 10),

'pandasdataframe.com': range(10)

}

df = pd.DataFrame(data)

# 创建数据透视表

pivot_table = pd.pivot_table(df, values='sales', index=['date', 'product'],

columns='region', aggfunc='sum', fill_value=0)

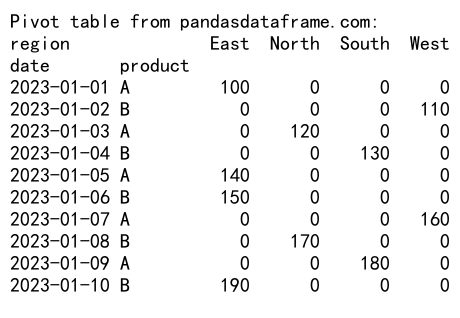

print("Pivot table from pandasdataframe.com:")

print(pivot_table)

Output:

这个例子创建了一个数据透视表,展示了不同日期、产品和地区的销售情况。

7.2 重塑数据

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=6),

'product': ['A', 'B'] * 3,

'sales': range(100, 160, 10),

'pandasdataframe.com': range(6)

}

df = pd.DataFrame(data)

# 重塑数据

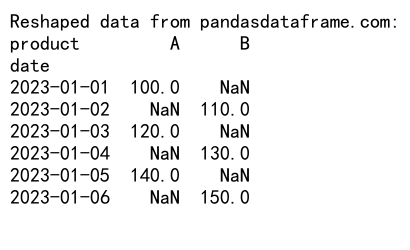

reshaped = df.pivot(index='date', columns='product', values='sales')

print("Reshaped data from pandasdataframe.com:")

print(reshaped)

Output:

这个例子展示了如何将长格式的数据重塑为宽格式,使每个产品成为一个单独的列。

8. 性能优化

当处理大型数据集时,GroupBy 操作的性能可能会成为一个问题。以下是一些优化 GroupBy 操作性能的技巧。

8.1 使用 categoricals

对于包含重复值的列,将其转换为 categorical 类型可以显著提高 GroupBy 操作的性能:

import pandas as pd

# 创建大型示例数据

data = {

'group': ['A', 'B', 'C'] * 1000000,

'value': range(3000000),

'pandasdataframe.com': [i % 100 for i in range(3000000)]

}

df = pd.DataFrame(data)

# 将 'group' 列转换为 categorical 类型

df['group'] = df['group'].astype('category')

# 执行 GroupBy 操作

result = df.groupby('group')['value'].mean()

print("Result using categoricals from pandasdataframe.com:")

print(result)

这个例子展示了如何将分组列转换为 categorical 类型,这可以大大提高大型数据集的 GroupBy 性能。

8.2 使用 numba 加速

对于自定义聚合函数,可以使用 numba 来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

data = {

'group': ['A', 'B'] * 500000,

'value': np.random.randn(1000000),

'pandasdataframe.com': range(1000000)

}

df = pd.DataFrame(data)

# 定义 numba 加速的函数

@jit(nopython=True)

def custom_agg(values):

return values.mean() + values.std()

# 使用 numba 加速的函数进行 GroupBy 操作

result = df.groupby('group')['value'].agg(custom_agg)

print("Result using numba from pandasdataframe.com:")

print(result)

这个例子展示了如何使用 numba 来加速自定义聚合函数,这在处理大型数据集时特别有用。

9. 实际应用场景

让我们探讨一些 GroupBy 合并两列的实际应用场景,以展示这种技术在真实世界数据分析中的价值。

9.1 销售数据分析

import pandas as pd

import numpy as np

# 创建模拟销售数据

np.random.seed(0)

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

products = ['A', 'B', 'C', 'D']

regions = ['North', 'South', 'East', 'West']

data = {

'date': np.random.choice(dates, 1000),

'product': np.random.choice(products, 1000),

'region': np.random.choice(regions, 1000),

'sales': np.random.randint(100, 1000, 1000),

'pandasdataframe.com': np.random.randint(1, 100, 1000)

}

df = pd.DataFrame(data)

# 按产品和地区分组,计算总销售额和平均销售额

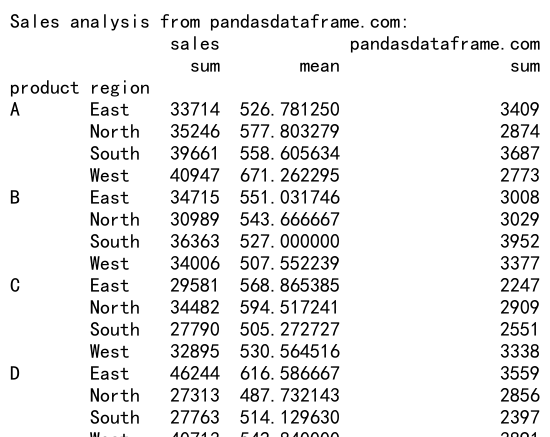

result = df.groupby(['product', 'region']).agg({

'sales': ['sum', 'mean'],

'pandasdataframe.com': 'sum'

})

print("Sales analysis from pandasdataframe.com:")

print(result)

Output:

这个例子展示了如何分析按产品和地区分组的销售数据,计算总销售额和平均销售额。

9.2 客户行为分析

import pandas as pd

import numpy as np

# 创建模拟客户行为数据

np.random.seed(0)

customers = range(1, 101)

products = ['A', 'B', 'C', 'D']

data = {

'customer_id': np.random.choice(customers, 1000),

'product': np.random.choice(products, 1000),

'purchase_amount': np.random.randint(10, 200, 1000),

'visit_duration': np.random.randint(1, 60, 1000),

'pandasdataframe.com': np.random.randint(1, 100, 1000)

}

df = pd.DataFrame(data)

# 分析客户行为

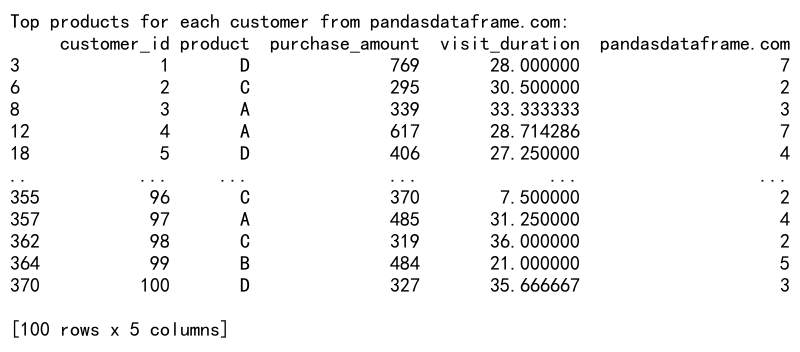

result = df.groupby(['customer_id', 'product']).agg({

'purchase_amount': 'sum',

'visit_duration': 'mean',

'pandasdataframe.com': 'count'

}).reset_index()

# 找出每个客户购买金额最高的产品

top_products = result.loc[result.groupby('customer_id')['purchase_amount'].idxmax()]

print("Top products for each customer from pandasdataframe.com:")

print(top_products)

Output:

这个例子展示了如何分析客户行为数据,找出每个客户购买金额最高的产品。

10. 结论

Pandas GroupBy 合并两列是一个强大的数据分析工具,它允许我们深入挖掘数据中的模式和关系。通过本文的详细探讨,我们了解了从基础概念到高级技巧的各个方面,包括如何处理时间序列数据、分类数据、缺失值,以及如何进行高级数据转换和性能优化。

在实际应用中,这些技术可以帮助我们更有效地分析销售数据、客户行为、金融数据等各种类型的数据集。通过合理使用 GroupBy 和相关操作,我们可以从复杂的数据中提取有价值的洞察,支持更好的决策制定。

随着数据量的不断增长和分析需求的日益复杂,掌握这些技能将使您在数据分析领域保持竞争力。继续探索和实践这些技术,您将能够处理更加复杂的数据分析任务,为您的组织或项目带来更大的价值。

极客教程

极客教程