Pandas GroupBy和Count Unique操作:数据分组与唯一值计数的完整指南

参考:pandas groupby count unique

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,我们经常需要对数据进行分组和计数操作。本文将深入探讨Pandas中的GroupBy和Count Unique操作,这两个功能在数据分析中扮演着至关重要的角色。我们将通过详细的解释和实际示例,帮助您掌握这些技术,从而更有效地处理和分析数据。

1. Pandas GroupBy简介

GroupBy操作是数据分析中的一个核心概念,它允许我们将数据集按照一个或多个列进行分组,然后对每个组应用特定的操作。这种方法非常适合于探索数据中的模式和趋势。

1.1 基本GroupBy操作

让我们从一个简单的GroupBy操作开始:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'Value': [10, 20, 30, 40, 50, 60]

})

# 按Category列进行分组并计算Value列的平均值

grouped = df.groupby('Category')['Value'].mean()

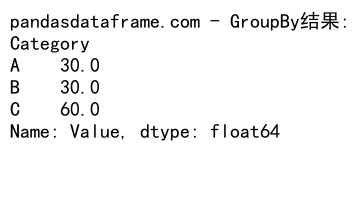

print("pandasdataframe.com - GroupBy结果:")

print(grouped)

Output:

在这个例子中,我们创建了一个包含’Category’和’Value’两列的数据框。然后,我们使用groupby()方法按’Category’列进行分组,并计算每个组’Value’列的平均值。这个操作会返回一个Series,其中索引是不同的类别,值是对应的平均值。

1.2 多列分组

Pandas还支持按多个列进行分组:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'SubCategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z'],

'Value': [10, 20, 30, 40, 50, 60]

})

# 按Category和SubCategory列进行分组并计算Value列的总和

grouped = df.groupby(['Category', 'SubCategory'])['Value'].sum()

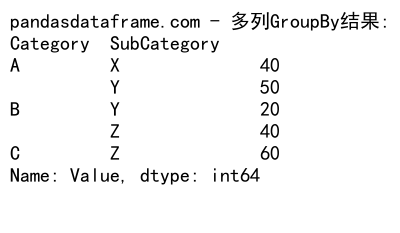

print("pandasdataframe.com - 多列GroupBy结果:")

print(grouped)

Output:

在这个例子中,我们按’Category’和’SubCategory’两列进行分组,然后计算每个组’Value’列的总和。结果是一个具有多级索引的Series。

2. GroupBy后的聚合操作

GroupBy操作通常与聚合函数一起使用,以对分组后的数据进行汇总计算。

2.1 常用聚合函数

Pandas提供了多种内置的聚合函数,如sum()、mean()、count()等:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'Value1': [10, 20, 30, 40, 50, 60],

'Value2': [5, 15, 25, 35, 45, 55]

})

# 按Category列分组并应用多个聚合函数

grouped = df.groupby('Category').agg({

'Value1': ['sum', 'mean'],

'Value2': ['min', 'max']

})

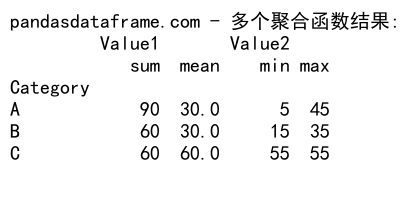

print("pandasdataframe.com - 多个聚合函数结果:")

print(grouped)

Output:

这个例子展示了如何对不同的列应用不同的聚合函数。我们对’Value1’列计算总和和平均值,对’Value2’列计算最小值和最大值。

2.2 自定义聚合函数

除了内置函数,我们还可以使用自定义函数进行聚合:

import pandas as pd

import numpy as np

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'Value': [10, 20, 30, 40, 50, 60]

})

# 自定义聚合函数

def custom_agg(x):

return np.percentile(x, 75) - np.percentile(x, 25)

# 应用自定义聚合函数

grouped = df.groupby('Category')['Value'].agg(custom_agg)

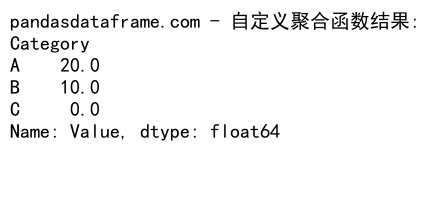

print("pandasdataframe.com - 自定义聚合函数结果:")

print(grouped)

Output:

在这个例子中,我们定义了一个计算四分位距的自定义函数,并将其应用于分组后的数据。

3. Count Unique操作

Count Unique操作用于计算一个列中唯一值的数量,这在数据分析中非常有用,特别是当我们需要了解数据的多样性时。

3.1 基本Count Unique操作

让我们看一个简单的Count Unique操作:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C', 'B', 'C'],

'Value': [1, 2, 1, 3, 2, 3, 2, 4]

})

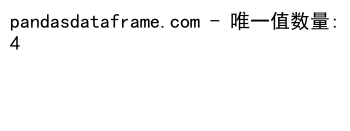

# 计算Value列中唯一值的数量

unique_count = df['Value'].nunique()

print("pandasdataframe.com - 唯一值数量:")

print(unique_count)

Output:

在这个例子中,我们使用nunique()方法来计算’Value’列中唯一值的数量。这个方法会返回一个整数,表示不同的唯一值的数量。

3.2 结合GroupBy的Count Unique操作

Count Unique操作经常与GroupBy一起使用,以计算每个组中唯一值的数量:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C', 'B', 'C'],

'SubCategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z', 'Y', 'X'],

'Value': [1, 2, 1, 3, 2, 3, 2, 4]

})

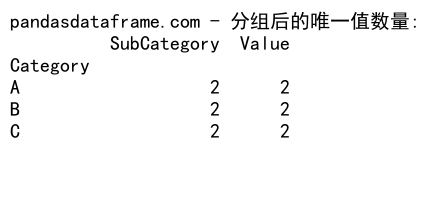

# 按Category分组并计算SubCategory和Value列的唯一值数量

grouped_unique = df.groupby('Category').agg({

'SubCategory': 'nunique',

'Value': 'nunique'

})

print("pandasdataframe.com - 分组后的唯一值数量:")

print(grouped_unique)

Output:

这个例子展示了如何按’Category’列分组,然后计算每个组中’SubCategory’和’Value’列的唯一值数量。

4. 高级GroupBy技巧

除了基本的GroupBy操作,Pandas还提供了一些高级技巧,可以帮助我们更灵活地处理数据。

4.1 GroupBy对象的迭代

GroupBy对象可以被迭代,这允许我们对每个组单独进行操作:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'Value': [10, 20, 30, 40, 50, 60]

})

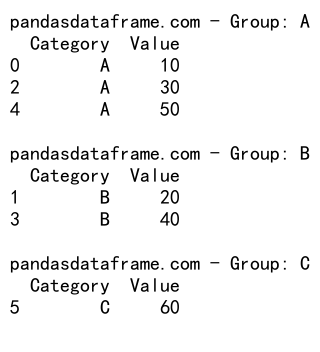

# 迭代GroupBy对象

for name, group in df.groupby('Category'):

print(f"pandasdataframe.com - Group: {name}")

print(group)

print()

Output:

这个例子展示了如何遍历GroupBy对象。对于每个组,我们可以访问组名和组内的数据。

4.2 GroupBy与转换函数

我们可以使用转换函数来对每个组应用自定义操作,并返回与原始数据框相同形状的结果:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'Value': [10, 20, 30, 40, 50, 60]

})

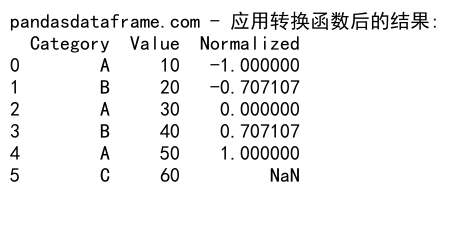

# 定义转换函数

def normalize(x):

return (x - x.mean()) / x.std()

# 应用转换函数

normalized = df.groupby('Category')['Value'].transform(normalize)

df['Normalized'] = normalized

print("pandasdataframe.com - 应用转换函数后的结果:")

print(df)

Output:

在这个例子中,我们定义了一个标准化函数,并使用transform()方法将其应用于每个组。结果是一个新的列,其中包含了标准化后的值。

5. Count Unique的高级应用

Count Unique操作不仅限于计算单个列的唯一值,还可以用于更复杂的场景。

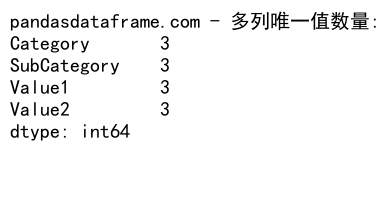

5.1 多列Count Unique

有时我们需要同时计算多个列的唯一值数量:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'SubCategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z'],

'Value1': [1, 2, 1, 3, 2, 3],

'Value2': [4, 5, 4, 6, 5, 6]

})

# 计算多个列的唯一值数量

unique_counts = df.nunique()

print("pandasdataframe.com - 多列唯一值数量:")

print(unique_counts)

Output:

这个例子展示了如何一次性计算数据框中所有列的唯一值数量。

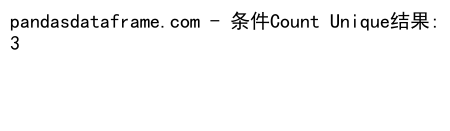

5.2 条件Count Unique

有时我们可能只想计算满足特定条件的行中的唯一值数量:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'],

'Value': [10, 20, 30, 40, 50, 60]

})

# 计算Value大于25的行中Category的唯一值数量

unique_count = df[df['Value'] > 25]['Category'].nunique()

print("pandasdataframe.com - 条件Count Unique结果:")

print(unique_count)

Output:

这个例子展示了如何计算’Value’大于25的行中’Category’列的唯一值数量。

6. GroupBy和Count Unique的组合应用

GroupBy和Count Unique操作经常一起使用,可以帮助我们深入了解数据的结构和分布。

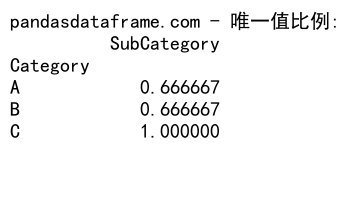

6.1 按组计算唯一值比例

我们可以计算每个组中唯一值的比例:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C', 'B', 'C'],

'SubCategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z', 'Y', 'X'],

'Value': [1, 2, 1, 3, 2, 3, 2, 4]

})

# 计算每个Category中SubCategory的唯一值比例

unique_ratio = df.groupby('Category').agg({

'SubCategory': lambda x: x.nunique() / len(x)

})

print("pandasdataframe.com - 唯一值比例:")

print(unique_ratio)

Output:

这个例子计算了每个’Category’中’SubCategory’的唯一值比例。这可以帮助我们了解每个类别的多样性。

6.2 累积唯一值计数

我们可以计算累积的唯一值数量:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Date': pd.date_range(start='2023-01-01', periods=6),

'Category': ['A', 'B', 'A', 'C', 'B', 'A'],

'Value': [1, 2, 3, 2, 1, 4]

})

# 计算累积唯一值数量

df['Cumulative_Unique'] = df.groupby('Category')['Value'].transform(

lambda x: x.expanding().nunique()

)

print("pandasdataframe.com - 累积唯一值计数:")

print(df)

这个例子展示了如何计算每个’Category’中’Value’的累积唯一值数量。这对于跟踪随时间变化的多样性非常有用。

7. 性能优化技巧

当处理大型数据集时,GroupBy和Count Unique操作可能会变得很慢。以下是一些优化性能的技巧:

7.1 使用categoricals

对于包含重复值的列,将其转换为categorical类型可以显著提高性能:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'] * 1000,

'Value': range(6000)

})

# 将Category列转换为categorical类型

df['Category'] = df['Category'].astype('category')

# 执行GroupBy操作

grouped = df.groupby('Category')['Value'].mean()

print("pandasdataframe.com - 使用categoricals后的结果:")

print(grouped)

这个例子展示了如何将’Category’列转换为categorical类型。对于包含大量重复值的列,这种方法可以显著提高GroupBy操作的速度。

7.2 使用numba对于自定义聚合函数,我们可以使用numba来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C'] * 1000,

'Value': np.random.randn(6000)

})

# 使用numba优化的自定义函数

@jit(nopython=True)

def custom_agg(x):

return np.percentile(x, 75) - np.percentile(x, 25)

# 应用优化后的函数

result = df.groupby('Category')['Value'].agg(custom_agg)

print("pandasdataframe.com - 使用numba优化后的结果:")

print(result)

在这个例子中,我们使用numba的@jit装饰器来优化自定义聚合函数。这对于计算密集型的操作特别有效。

8. 处理缺失值

在实际数据分析中,我们经常会遇到缺失值。GroupBy和Count Unique操作对缺失值的处理方式可能会影响结果。

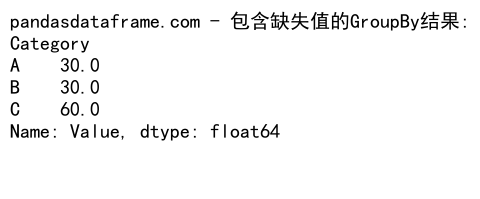

8.1 GroupBy中的缺失值处理

默认情况下,GroupBy会将缺失值视为一个单独的组:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', np.nan, 'B', 'A', 'C'],

'Value': [10, 20, 30, 40, 50, 60]

})

# 执行GroupBy操作

grouped = df.groupby('Category')['Value'].mean()

print("pandasdataframe.com - 包含缺失值的GroupBy结果:")

print(grouped)

Output:

在这个例子中,缺失值(NaN)被视为一个单独的组。如果我们不想包括缺失值,可以在GroupBy之前使用dropna()方法。

8.2 Count Unique中的缺失值处理

在计算唯一值数量时,缺失值通常被视为一个唯一值:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', np.nan, 'B', 'A', 'C'],

'Value': [1, 2, np.nan, 2, 1, 3]

})

# 计算唯一值数量

unique_count = df['Value'].nunique()

unique_count_dropna = df['Value'].nunique(dropna=True)

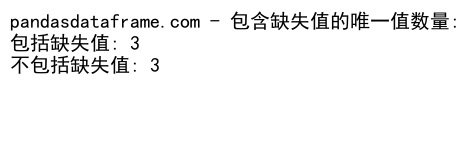

print("pandasdataframe.com - 包含缺失值的唯一值数量:")

print(f"包括缺失值: {unique_count}")

print(f"不包括缺失值: {unique_count_dropna}")

Output:

这个例子展示了如何在计算唯一值数量时包括或排除缺失值。

9. 高级数据分析技巧

结合GroupBy和Count Unique操作,我们可以执行一些高级的数据分析任务。

9.1 计算组内重复率

我们可以计算每个组内的重复率:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C', 'B', 'C'],

'Value': [1, 2, 1, 3, 2, 3, 2, 4]

})

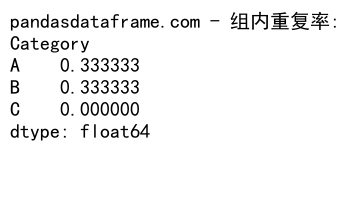

# 计算组内重复率

duplication_rate = 1 - df.groupby('Category')['Value'].nunique() / df.groupby('Category').size()

print("pandasdataframe.com - 组内重复率:")

print(duplication_rate)

Output:

这个例子计算了每个’Category’中’Value’的重复率。重复率越高,表示该类别中的值重复越多。

9.2 计算组间重叠度

我们可以计算不同组之间的值重叠程度:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'Category': ['A', 'B', 'A', 'B', 'A', 'C', 'B', 'C'],

'Value': [1, 2, 3, 4, 5, 6, 7, 8]

})

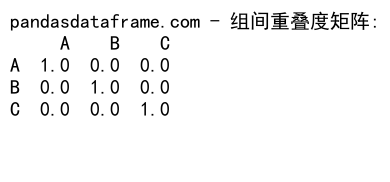

# 计算组间重叠度

def overlap_ratio(group1, group2):

set1 = set(group1)

set2 = set(group2)

return len(set1.intersection(set2)) / len(set1.union(set2))

categories = df['Category'].unique()

overlap_matrix = pd.DataFrame(index=categories, columns=categories)

for cat1 in categories:

for cat2 in categories:

group1 = df[df['Category'] == cat1]['Value']

group2 = df[df['Category'] == cat2]['Value']

overlap_matrix.loc[cat1, cat2] = overlap_ratio(group1, group2)

print("pandasdataframe.com - 组间重叠度矩阵:")

print(overlap_matrix)

Output:

这个例子计算了不同’Category’之间’Value’的重叠程度。重叠度越高,表示两个类别共享的值越多。

10. 实际应用场景

让我们看一些GroupBy和Count Unique操作在实际数据分析中的应用场景。

10.1 客户购买行为分析

假设我们有一个电子商务网站的订单数据:

import pandas as pd

import numpy as np

# 创建示例订单数据

np.random.seed(0)

orders = pd.DataFrame({

'CustomerID': np.random.randint(1, 101, 1000),

'OrderDate': pd.date_range(start='2023-01-01', periods=1000),

'ProductCategory': np.random.choice(['Electronics', 'Clothing', 'Books', 'Home'], 1000),

'OrderValue': np.random.randint(10, 1001, 1000)

})

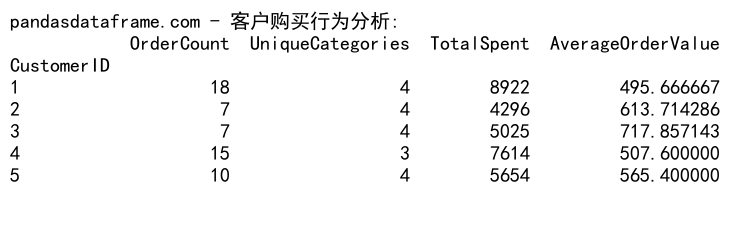

# 分析客户购买行为

customer_behavior = orders.groupby('CustomerID').agg({

'OrderDate': 'count',

'ProductCategory': 'nunique',

'OrderValue': ['sum', 'mean']

})

customer_behavior.columns = ['OrderCount', 'UniqueCategories', 'TotalSpent', 'AverageOrderValue']

print("pandasdataframe.com - 客户购买行为分析:")

print(customer_behavior.head())

Output:

这个例子展示了如何使用GroupBy和Count Unique操作来分析客户的购买行为,包括订单数量、购买的不同产品类别数、总消费金额和平均订单金额。

10.2 时间序列数据分析

对于时间序列数据,我们可以使用GroupBy和Count Unique来分析趋势:

import pandas as pd

import numpy as np

# 创建示例时间序列数据

np.random.seed(0)

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = pd.DataFrame({

'Date': dates,

'Value': np.random.randn(len(dates)),

'Category': np.random.choice(['A', 'B', 'C'], len(dates))

})

# 按月分组并分析

monthly_analysis = data.groupby([data['Date'].dt.to_period('M'), 'Category']).agg({

'Value': ['mean', 'std'],

'Category': 'count'

})

monthly_analysis.columns = ['MeanValue', 'StdValue', 'Count']

monthly_analysis = monthly_analysis.reset_index()

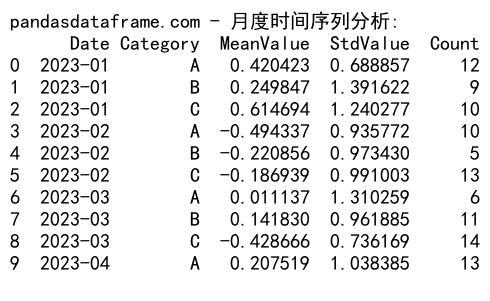

print("pandasdataframe.com - 月度时间序列分析:")

print(monthly_analysis.head(10))

Output:

这个例子展示了如何对时间序列数据进行月度分组分析,计算每个类别的平均值、标准差和计数。

结论

Pandas的GroupBy和Count Unique操作是数据分析中非常强大的工具。它们允许我们深入挖掘数据中的模式和趋势,从而得出有价值的见解。通过本文的详细介绍和实际示例,我们探讨了这些操作的基本用法、高级技巧以及在实际场景中的应用。

掌握这些技能将使您能够更有效地处理和分析各种类型的数据集。无论是进行客户行为分析、时间序列分析,还是其他类型的数据探索,GroupBy和Count Unique操作都将成为您数据分析工具箱中不可或缺的工具。

随着数据规模的不断增长和复杂性的提高,优化性能和处理缺失值变得越来越重要。通过使用本文中介绍的技巧,如使用categoricals和numba,您可以显著提高大型数据集的处理效率。

最后,记住数据分析是一个迭代的过程。不断实践和探索新的方法将帮助您更好地理解和利用数据,从而做出更明智的决策。希望本文能为您的数据分析之旅提供有价值的指导和启发。

极客教程

极客教程