Pandas GroupBy 和 Filter 操作:数据分组与筛选的高效技巧

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,GroupBy和Filter操作是两个非常重要的功能,它们可以帮助我们更有效地组织、汇总和筛选数据。本文将深入探讨Pandas中的GroupBy和Filter操作,介绍它们的基本概念、使用方法以及一些高级技巧。

1. GroupBy操作简介

GroupBy操作允许我们将数据按照一个或多个列进行分组,然后对每个组应用聚合函数或其他操作。这在数据分析中非常有用,可以帮助我们快速获取数据的统计信息或进行复杂的计算。

1.1 基本的GroupBy操作

让我们从一个简单的例子开始,看看如何使用GroupBy进行基本的数据分组和聚合。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

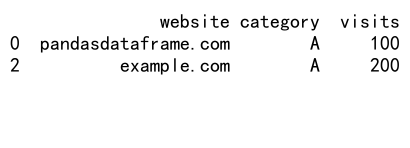

# 按category分组并计算visits的平均值

grouped = df.groupby('category')['visits'].mean()

print(grouped)

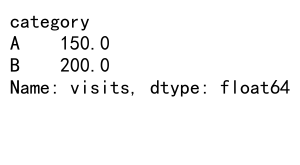

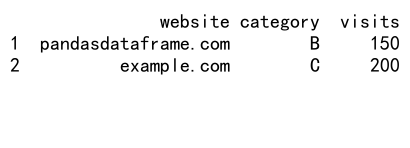

Output:

在这个例子中,我们创建了一个包含网站访问数据的DataFrame,然后使用groupby()方法按category列进行分组,并计算每个类别的平均访问量。

1.2 多列分组

GroupBy操作不仅限于单列分组,我们还可以按多个列进行分组。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'country': ['US', 'UK', 'US', 'UK'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 按category和country分组,并计算visits的总和

grouped = df.groupby(['category', 'country'])['visits'].sum()

print(grouped)

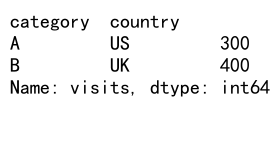

Output:

这个例子展示了如何按多个列(category和country)进行分组,并计算每个组合的访问总量。

1.3 应用自定义聚合函数

除了使用内置的聚合函数(如mean()、sum()等),我们还可以应用自定义的聚合函数。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 定义自定义聚合函数

def custom_agg(x):

return x.max() - x.min()

# 应用自定义聚合函数

grouped = df.groupby('category')['visits'].agg(custom_agg)

print(grouped)

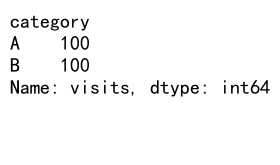

Output:

在这个例子中,我们定义了一个自定义函数custom_agg,它计算每个组内最大值和最小值的差。然后,我们使用agg()方法将这个函数应用到分组后的数据上。

2. Filter操作简介

Filter操作允许我们根据特定条件筛选数据,这在数据清洗和预处理阶段非常有用。Pandas提供了多种方式来进行数据筛选,包括布尔索引、loc和iloc方法等。

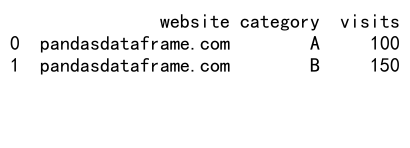

2.1 使用布尔索引进行筛选

布尔索引是Pandas中最常用的筛选方法之一。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

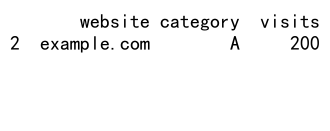

# 筛选visits大于150的行

filtered_df = df[df['visits'] > 150]

print(filtered_df)

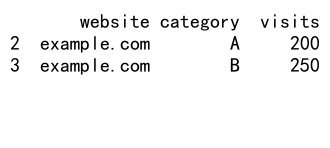

Output:

这个例子展示了如何使用布尔索引来筛选访问量大于150的行。

2.2 使用loc方法进行筛选

loc方法允许我们使用标签来选择数据。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

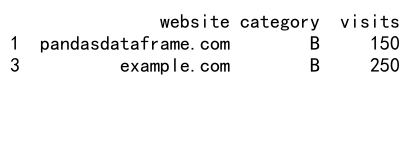

# 使用loc筛选category为'A'的行

filtered_df = df.loc[df['category'] == 'A']

print(filtered_df)

Output:

这个例子展示了如何使用loc方法来筛选类别为’A’的行。

2.3 使用query方法进行筛选

query方法提供了一种更直观的方式来筛选数据。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 使用query方法筛选数据

filtered_df = df.query('visits > 150 and category == "A"')

print(filtered_df)

Output:

这个例子展示了如何使用query方法来筛选访问量大于150且类别为’A’的行。

3. GroupBy和Filter的结合使用

GroupBy和Filter操作可以结合使用,以实现更复杂的数据处理任务。

3.1 对分组后的数据进行筛选

我们可以先对数据进行分组,然后对分组后的结果进行筛选。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 按category分组,然后筛选平均visits大于150的组

grouped = df.groupby('category').filter(lambda x: x['visits'].mean() > 150)

print(grouped)

Output:

这个例子展示了如何先按category分组,然后筛选出平均访问量大于150的组。

3.2 使用transform方法进行分组筛选

transform方法可以帮助我们在保持原始DataFrame结构的同时进行分组计算。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

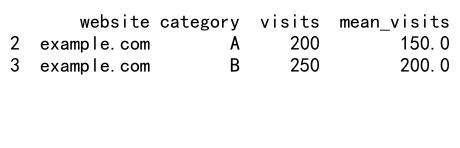

# 使用transform计算每个category的平均visits,并筛选大于平均值的行

df['mean_visits'] = df.groupby('category')['visits'].transform('mean')

filtered_df = df[df['visits'] > df['mean_visits']]

print(filtered_df)

Output:

这个例子展示了如何使用transform方法计算每个类别的平均访问量,然后筛选出高于平均值的行。

4. 高级GroupBy技巧

除了基本的GroupBy操作,Pandas还提供了一些高级技巧,可以帮助我们更灵活地处理分组数据。

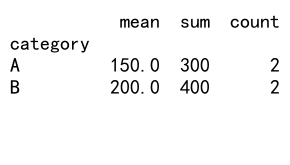

4.1 多函数聚合

我们可以在一个GroupBy操作中应用多个聚合函数。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 应用多个聚合函数

grouped = df.groupby('category')['visits'].agg(['mean', 'sum', 'count'])

print(grouped)

Output:

这个例子展示了如何在一个GroupBy操作中同时计算平均值、总和和计数。

4.2 分组后应用函数

我们可以使用apply方法在分组后的数据上应用自定义函数。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 定义自定义函数

def top_n(group, n=1):

return group.nlargest(n, 'visits')

# 应用自定义函数

grouped = df.groupby('category').apply(top_n)

print(grouped)

这个例子展示了如何使用apply方法在每个分组中选择访问量最高的行。

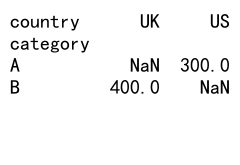

4.3 分组后的数据重塑

我们可以使用unstack方法来重塑分组后的数据。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'A', 'B'],

'country': ['US', 'UK', 'US', 'UK'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 分组后重塑数据

grouped = df.groupby(['category', 'country'])['visits'].sum().unstack()

print(grouped)

Output:

这个例子展示了如何使用unstack方法将多级索引转换为列,从而得到一个更易读的表格形式。

5. 高级Filter技巧

除了基本的筛选操作,Pandas还提供了一些高级的筛选技巧,可以帮助我们更精确地处理数据。

5.1 使用isin方法进行筛选

isin方法允许我们筛选包含特定值的行。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'C', 'D'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 使用isin方法筛选特定类别

categories_to_include = ['A', 'B']

filtered_df = df[df['category'].isin(categories_to_include)]

print(filtered_df)

Output:

这个例子展示了如何使用isin方法筛选出类别为’A’或’B’的行。

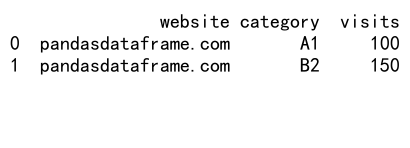

5.2 使用正则表达式进行筛选

我们可以使用str.contains方法结合正则表达式进行更复杂的字符串筛选。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A1', 'B2', 'C3', 'D4'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 使用正则表达式筛选类别

filtered_df = df[df['category'].str.contains(r'[AB]\d')]

print(filtered_df)

Output:

这个例子展示了如何使用正则表达式筛选出类别以’A’或’B’开头,后面跟着一个数字的行。

5.3 使用between方法进行范围筛选

between方法可以帮助我们快速筛选出在特定范围内的数据。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'example.com', 'example.com'],

'category': ['A', 'B', 'C', 'D'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 使用between方法筛选访问量在150到200之间的行

filtered_df = df[df['visits'].between(150, 200)]

print(filtered_df)

Output:

这个例子展示了如何使用between方法筛选出访问量在150到200之间的行。

6. GroupBy和Filter的性能优化

在处理大型数据集时,GroupBy和Filter操作的性能可能会成为一个问题。以下是一些优化技巧:

6.1 使用categorical数据类型对于经常用于分组的列,将其转换为categorical数据类型可以显著提高性能。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000 + ['example.com'] * 1000,

'category': ['A', 'B'] * 1000,

'visits': range(2000)

}

df = pd.DataFrame(data)

# 将category列转换为categorical类型

df['category'] = df['category'].astype('category')

# 进行分组操作

grouped = df.groupby('category')['visits'].mean()

print(grouped)

这个例子展示了如何将category列转换为categorical类型,这在大型数据集上可以显著提高GroupBy操作的性能。

6.2 使用numba加速自定义函数

对于复杂的自定义聚合函数,我们可以使用numba来加速计算。

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000 + ['example.com'] * 1000,

'category': ['A', 'B'] * 1000,

'visits': np.random.randint(1, 1000, 2000)

}

df = pd.DataFrame(data)

# 使用numba加速自定义函数

@jit(nopython=True)

def custom_agg(x):

return np.percentile(x, 75) - np.percentile(x, 25)

# 应用加速后的函数

grouped = df.groupby('category')['visits'].agg(custom_agg)

print(grouped)

这个例子展示了如何使用numba的@jit装饰器来加速自定义聚合函数。这在处理大型数据集时特别有用。

6.3 使用query方法进行高效筛选

对于复杂的筛选条件,使用query方法通常比链式布尔索引更高效。

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000 + ['example.com'] * 1000,

'category': ['A', 'B', 'C', 'D'] * 500,

'visits': range(2000)

}

df = pd.DataFrame(data)

# 使用query方法进行复杂筛选

filtered_df = df.query('category in ["A", "B"] and visits > 500 and website == "pandasdataframe.com"')

print(filtered_df)

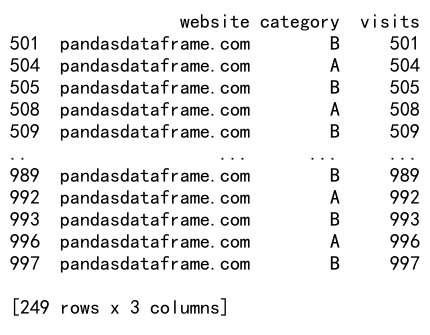

Output:

这个例子展示了如何使用query方法进行复杂的筛选操作,这在大型数据集上通常比使用多个布尔条件更高效。

7. GroupBy和Filter的实际应用场景

让我们来看看GroupBy和Filter在实际数据分析中的一些应用场景。

7.1 销售数据分析

假设我们有一个电子商务网站的销售数据,我们想分析不同产品类别的销售情况。

import pandas as pd

# 创建示例销售数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'product_category': ['Electronics', 'Clothing', 'Books', 'Home'] * 250,

'sale_amount': np.random.randint(10, 1000, 1000)

}

df = pd.DataFrame(data)

# 分析每个产品类别的销售情况

sales_analysis = df.groupby('product_category').agg({

'sale_amount': ['sum', 'mean', 'count']

})

# 找出销售总额最高的前3个类别

top_categories = sales_analysis['sale_amount']['sum'].nlargest(3)

print("Sales Analysis:")

print(sales_analysis)

print("\nTop 3 Categories:")

print(top_categories)

这个例子展示了如何使用GroupBy来分析每个产品类别的销售总额、平均销售额和销售次数,以及如何找出销售总额最高的前三个类别。

7.2 用户行为分析

假设我们有用户在网站上的行为数据,我们想分析不同用户组的行为模式。

import pandas as pd

# 创建示例用户行为数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'user_id': range(100) * 10,

'action': ['view', 'click', 'purchase'] * 333 + ['view'],

'timestamp': pd.date_range(start='2023-01-01', periods=1000, freq='H')

}

df = pd.DataFrame(data)

# 分析每个用户的行为

user_behavior = df.groupby('user_id')['action'].value_counts().unstack().fillna(0)

# 计算每个用户的购买转化率

user_behavior['conversion_rate'] = user_behavior['purchase'] / user_behavior['view']

# 找出转化率最高的前5个用户

top_users = user_behavior.nlargest(5, 'conversion_rate')

print("User Behavior Analysis:")

print(user_behavior.head())

print("\nTop 5 Users by Conversion Rate:")

print(top_users[['view', 'click', 'purchase', 'conversion_rate']])

这个例子展示了如何使用GroupBy来分析每个用户的行为模式,计算购买转化率,并找出转化率最高的用户。

7.3 时间序列数据分析

假设我们有网站的每小时访问量数据,我们想分析访问量的时间模式。

import pandas as pd

# 创建示例时间序列数据

data = {

'website': ['pandasdataframe.com'] * 720,

'timestamp': pd.date_range(start='2023-01-01', periods=720, freq='H'),

'visits': np.random.randint(100, 1000, 720)

}

df = pd.DataFrame(data)

# 设置timestamp为索引

df.set_index('timestamp', inplace=True)

# 按小时、星期几和月份分组分析访问量

hourly_pattern = df.groupby(df.index.hour)['visits'].mean()

weekly_pattern = df.groupby(df.index.dayofweek)['visits'].mean()

monthly_pattern = df.groupby(df.index.month)['visits'].mean()

print("Hourly Visit Pattern:")

print(hourly_pattern)

print("\nWeekly Visit Pattern:")

print(weekly_pattern)

print("\nMonthly Visit Pattern:")

print(monthly_pattern)

这个例子展示了如何使用GroupBy来分析网站访问量的时间模式,包括每小时、每周和每月的平均访问量。

8. 处理缺失值

在实际数据处理中,我们经常会遇到缺失值。Pandas提供了多种方法来处理缺失值,特别是在进行GroupBy和Filter操作时。

8.1 在GroupBy操作中处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'website': ['pandasdataframe.com'] * 10,

'category': ['A', 'B', 'A', 'B', 'C', np.nan, 'A', 'B', 'C', np.nan],

'visits': [100, 150, 200, 250, 300, 350, 400, 450, 500, 550]

}

df = pd.DataFrame(data)

# 使用dropna处理缺失值

grouped = df.groupby('category', dropna=False)['visits'].mean()

print("GroupBy result with NaN:")

print(grouped)

# 使用fillna处理缺失值

df['category'] = df['category'].fillna('Unknown')

grouped = df.groupby('category')['visits'].mean()

print("\nGroupBy result after filling NaN:")

print(grouped)

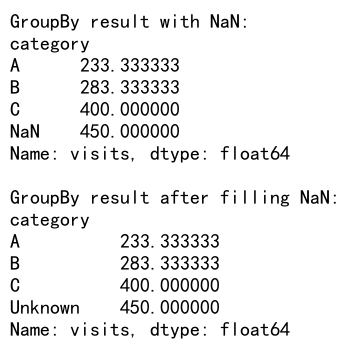

Output:

这个例子展示了如何在GroupBy操作中处理缺失值,包括保留缺失值和填充缺失值两种方法。

8.2 在Filter操作中处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'website': ['pandasdataframe.com'] * 10,

'category': ['A', 'B', 'A', 'B', 'C', np.nan, 'A', 'B', 'C', np.nan],

'visits': [100, 150, 200, 250, 300, 350, 400, 450, 500, 550]

}

df = pd.DataFrame(data)

# 筛选出非缺失值

filtered_df = df.dropna(subset=['category'])

print("Filtered DataFrame (dropping NaN):")

print(filtered_df)

# 将缺失值视为特定类别

df['category'] = df['category'].fillna('Unknown')

filtered_df = df[df['category'].isin(['A', 'B', 'Unknown'])]

print("\nFiltered DataFrame (treating NaN as 'Unknown'):")

print(filtered_df)

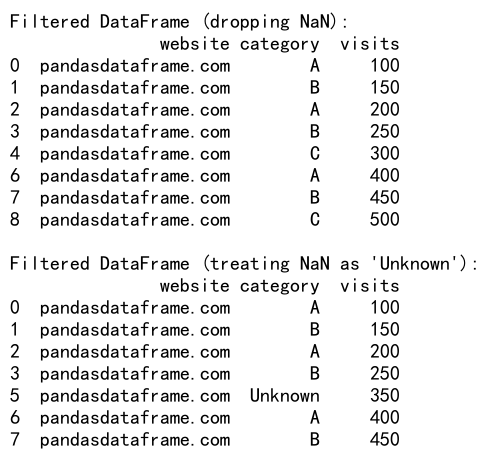

Output:

这个例子展示了如何在Filter操作中处理缺失值,包括删除包含缺失值的行和将缺失值视为特定类别两种方法。

9. 高级数据转换

GroupBy和Filter操作常常与其他高级数据转换技术结合使用,以实现更复杂的数据处理任务。

9.1 使用pivot_table进行数据重塑

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 12,

'date': pd.date_range(start='2023-01-01', periods=12, freq='M'),

'category': ['A', 'B', 'C'] * 4,

'sales': np.random.randint(1000, 5000, 12)

}

df = pd.DataFrame(data)

# 使用pivot_table创建交叉表

pivot_table = pd.pivot_table(df, values='sales', index='date', columns='category', aggfunc='sum')

print("Pivot Table:")

print(pivot_table)

# 计算每个类别的累计销售额

pivot_table_cumsum = pivot_table.cumsum()

print("\nCumulative Sales:")

print(pivot_table_cumsum)

这个例子展示了如何使用pivot_table函数创建一个交叉表,显示不同日期和类别的销售额,以及如何计算累计销售额。

9.2 使用melt进行数据重塑

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 3,

'date': pd.date_range(start='2023-01-01', periods=3),

'category_A': [100, 150, 200],

'category_B': [200, 250, 300],

'category_C': [300, 350, 400]

}

df = pd.DataFrame(data)

# 使用melt函数将宽格式转换为长格式

melted_df = pd.melt(df, id_vars=['website', 'date'], var_name='category', value_name='sales')

print("Melted DataFrame:")

print(melted_df)

# 对melted数据进行分组分析

grouped = melted_df.groupby('category')['sales'].agg(['mean', 'sum'])

print("\nGrouped Analysis:")

print(grouped)

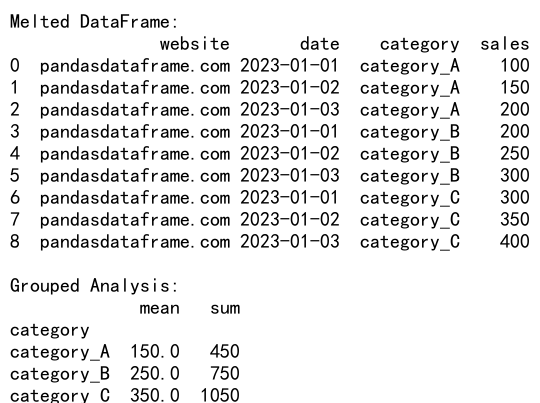

Output:

这个例子展示了如何使用melt函数将宽格式的数据转换为长格式,这在进行某些类型的数据分析时非常有用。

10. 结合其他Pandas功能

GroupBy和Filter操作可以与Pandas的其他功能结合使用,以实现更复杂的数据处理任务。

10.1 结合merge进行数据合并

import pandas as pd

# 创建销售数据

sales_data = {

'website': ['pandasdataframe.com'] * 5,

'product_id': [1, 2, 3, 4, 5],

'sales': [100, 150, 200, 250, 300]

}

sales_df = pd.DataFrame(sales_data)

# 创建产品数据

product_data = {

'website': ['pandasdataframe.com'] * 5,

'product_id': [1, 2, 3, 4, 5],

'category': ['A', 'B', 'A', 'C', 'B']

}

product_df = pd.DataFrame(product_data)

# 合并数据

merged_df = pd.merge(sales_df, product_df, on=['website', 'product_id'])

# 按类别分组并计算总销售额

grouped = merged_df.groupby('category')['sales'].sum()

print("Grouped Sales by Category:")

print(grouped)

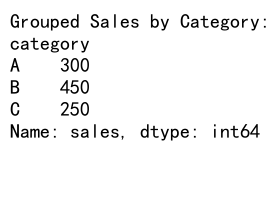

Output:

这个例子展示了如何使用merge函数合并两个数据框,然后对合并后的数据进行分组分析。

10.2 结合apply进行复杂操作

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 10,

'category': ['A', 'B', 'A', 'B', 'C', 'C', 'A', 'B', 'C', 'A'],

'sales': np.random.randint(100, 1000, 10)

}

df = pd.DataFrame(data)

# 定义一个复杂的分组操作函数

def complex_operation(group):

return pd.Series({

'total_sales': group['sales'].sum(),

'avg_sales': group['sales'].mean(),

'sales_range': group['sales'].max() - group['sales'].min(),

'pct_of_total': group['sales'].sum() / df['sales'].sum() * 100

})

# 应用复杂操作

result = df.groupby('category').apply(complex_operation)

print("Complex Grouped Analysis:")

print(result)

这个例子展示了如何使用apply函数对分组后的数据进行复杂的操作,包括计算总销售额、平均销售额、销售范围和占总销售额的百分比。

11. 处理大型数据集

当处理大型数据集时,内存使用和计算效率变得尤为重要。以下是一些处理大型数据集时的技巧和注意事项。

11.1 使用chunksize分块读取数据

当数据集太大无法一次性加载到内存时,可以使用chunksize参数分块读取数据。

import pandas as pd

# 假设我们有一个大型CSV文件 'large_data.csv'

chunk_size = 10000

chunks = []

for chunk in pd.read_csv('pandasdataframe.com_large_data.csv', chunksize=chunk_size):

# 对每个chunk进行处理

processed_chunk = chunk.groupby('category')['sales'].sum()

chunks.append(processed_chunk)

# 合并所有处理后的chunk

result = pd.concat(chunks)

# 对合并后的结果进行最终的聚合

final_result = result.groupby(level=0).sum()

print("Final Result:")

print(final_result)

这个例子展示了如何使用chunksize参数分块读取大型CSV文件,对每个块进行处理,然后合并结果。

11.2 使用dask进行并行计算

对于非常大的数据集,可以考虑使用dask库进行并行计算。

import dask.dataframe as dd

# 读取大型CSV文件

ddf = dd.read_csv('pandasdataframe.com_large_data.csv')

# 进行分组操作

result = ddf.groupby('category')['sales'].sum().compute()

print("Result using dask:")

print(result)

这个例子展示了如何使用dask来处理大型数据集,dask可以自动进行并行计算,提高处理效率。

12. 高级GroupBy技巧

以下是一些更高级的GroupBy技巧,可以帮助你更灵活地处理复杂的数据分析任务。

12.1 使用agg方法应用多个函数

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 100,

'category': np.random.choice(['A', 'B', 'C'], 100),

'sales': np.random.randint(100, 1000, 100),

'profit': np.random.randint(10, 100, 100)

}

df = pd.DataFrame(data)

# 使用agg方法应用多个函数

result = df.groupby('category').agg({

'sales': ['sum', 'mean', 'max'],

'profit': ['mean', lambda x: x.max() - x.min()]

})

print("Advanced GroupBy Result:")

print(result)

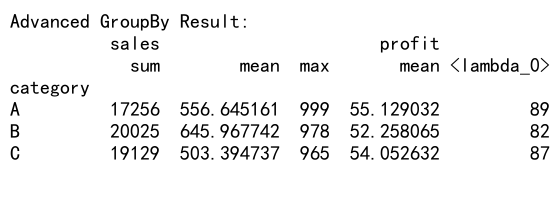

Output:

这个例子展示了如何使用agg方法对不同列应用不同的聚合函数,包括内置函数和自定义函数。

12.2 使用transform方法进行组内计算

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 100,

'category': np.random.choice(['A', 'B', 'C'], 100),

'sales': np.random.randint(100, 1000, 100)

}

df = pd.DataFrame(data)

# 使用transform方法计算每个类别的平均销售额

df['category_avg_sales'] = df.groupby('category')['sales'].transform('mean')

# 计算每行销售额与其类别平均销售额的差值

df['sales_diff_from_avg'] = df['sales'] - df['category_avg_sales']

print("DataFrame with Transformed Columns:")

print(df.head(10))

# 找出每个类别中销售额最高的记录

top_sales = df.loc[df.groupby('category')['sales'].transform(max) == df['sales']]

print("\nTop Sales in Each Category:")

print(top_sales)

这个例子展示了如何使用transform方法进行组内计算,包括计算每个类别的平均销售额和找出每个类别中销售额最高的记录。

13. 高级Filter技巧

以下是一些更高级的Filter技巧,可以帮助你更精确地筛选数据。

13.1 使用复杂条件进行筛选

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 100,

'category': np.random.choice(['A', 'B', 'C'], 100),

'sales': np.random.randint(100, 1000, 100),

'date': pd.date_range(start='2023-01-01', periods=100)

}

df = pd.DataFrame(data)

# 使用复杂条件进行筛选

filtered_df = df[

(df['category'].isin(['A', 'B'])) &

(df['sales'] > 500) &

(df['date'] > '2023-03-01')

]

print("Filtered DataFrame:")

print(filtered_df)

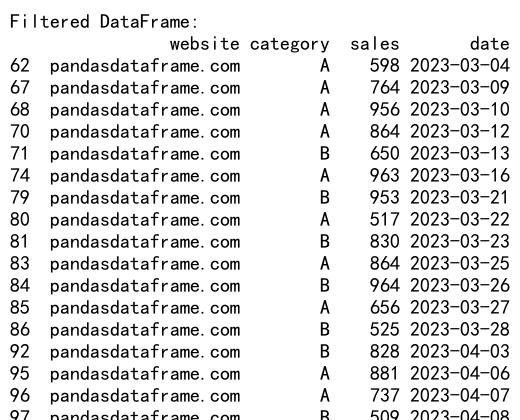

Output:

这个例子展示了如何使用多个条件组合进行复杂的数据筛选。

13.2 使用自定义函数进行筛选

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 100,

'text': ['This is a sample text ' + str(i) for i in range(100)],

'value': np.random.randint(1, 100, 100)

}

df = pd.DataFrame(data)

# 定义自定义筛选函数

def complex_filter(row):

return len(row['text']) > 25 and row['value'] % 2 == 0

# 使用自定义函数进行筛选

filtered_df = df[df.apply(complex_filter, axis=1)]

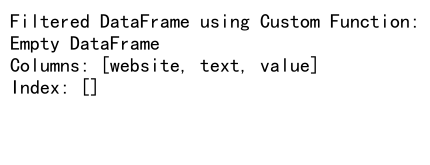

print("Filtered DataFrame using Custom Function:")

print(filtered_df)

Output:

这个例子展示了如何使用自定义函数进行更复杂的数据筛选,这在标准筛选方法无法满足需求时特别有用。

结论

Pandas的GroupBy和Filter操作是数据分析中非常强大的工具。它们允许我们以灵活和高效的方式处理和分析数据。通过本文介绍的各种技巧和示例,你应该能够更好地理解和运用这些操作来处理各种复杂的数据分析任务。

记住,在处理大型数据集时,要注意内存使用和计算效率。适当地使用分块处理、并行计算等技术可以帮助你更有效地处理大规模数据。

最后,持续学习和实践是掌握这些技能的关键。随着你在实际项目中应用这些技巧,你会发现更多有趣和有用的方法来利用Pandas的GroupBy和Filter功能。希望本文能为你的数据分析工作提供有价值的参考和启发。

极客教程

极客教程