Pandas GroupBy和Unique Count操作:数据分组与唯一值统计详解

参考:pandas groupby unique count

Pandas是Python中强大的数据处理库,其中GroupBy和Unique Count操作是进行数据分析时常用的功能。本文将深入探讨Pandas中的GroupBy操作以及如何结合unique count进行数据统计,帮助读者更好地理解和应用这些功能。

1. Pandas GroupBy简介

GroupBy操作允许我们将数据按照一个或多个列进行分组,然后对每个分组应用特定的操作。这是数据分析中非常常见的需求,可以帮助我们更好地理解数据的结构和特征。

1.1 基本GroupBy操作

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 按name列进行分组并计算sales的总和

grouped = df.groupby('name')['sales'].sum()

print(grouped)

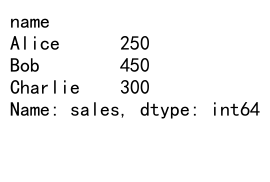

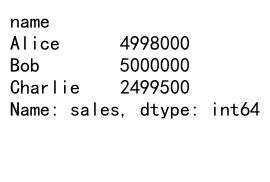

Output:

在这个例子中,我们首先创建了一个包含姓名、城市和销售额的DataFrame。然后,我们使用groupby('name')按姓名进行分组,并计算每个人的总销售额。

1.2 多列分组

Pandas还支持按多个列进行分组:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'category': ['A', 'B', 'A', 'B', 'A'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 按name和city列进行分组并计算sales的平均值

grouped = df.groupby(['name', 'city'])['sales'].mean()

print(grouped)

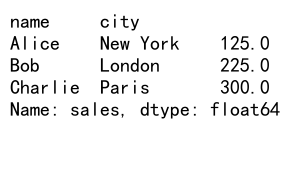

Output:

这个例子展示了如何按多个列(姓名和城市)进行分组,并计算每个组的平均销售额。

2. GroupBy后的聚合操作

GroupBy操作后,我们通常需要对分组后的数据进行聚合操作。Pandas提供了多种聚合方法。

2.1 常用聚合函数

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 使用多个聚合函数

result = df.groupby('name')['sales'].agg(['sum', 'mean', 'max', 'min'])

print(result)

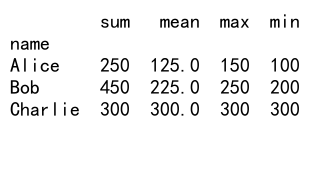

Output:

这个例子展示了如何使用多个聚合函数,包括求和、平均值、最大值和最小值。

2.2 自定义聚合函数

除了内置的聚合函数,我们还可以使用自定义函数进行聚合:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 自定义聚合函数

def range_diff(x):

return x.max() - x.min()

# 使用自定义函数进行聚合

result = df.groupby('name')['sales'].agg(range_diff)

print(result)

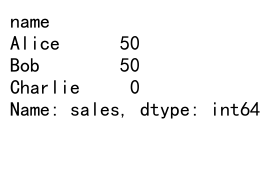

Output:

在这个例子中,我们定义了一个range_diff函数来计算每组销售额的范围(最大值减最小值),然后将这个函数应用到分组后的数据上。

3. Unique Count操作

Unique Count操作用于统计某一列或某些列中唯一值的数量。这在数据分析中非常有用,特别是当我们需要了解数据的多样性或重复程度时。

3.1 基本Unique Count

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob', 'Alice'],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'category': ['A', 'B', 'A', 'B', 'A', 'C']

}

df = pd.DataFrame(data)

# 计算name列的唯一值数量

unique_count = df['name'].nunique()

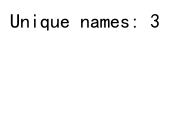

print(f"Unique names: {unique_count}")

Output:

这个例子展示了如何使用nunique()方法计算’name’列中唯一值的数量。

3.2 多列Unique Count

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob', 'Alice'],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'category': ['A', 'B', 'A', 'B', 'A', 'C']

}

df = pd.DataFrame(data)

# 计算多列的唯一值数量

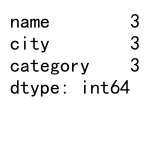

unique_counts = df.nunique()

print(unique_counts)

Output:

这个例子展示了如何计算DataFrame中所有列的唯一值数量。

4. 结合GroupBy和Unique Count

GroupBy和Unique Count操作可以结合使用,以获得更深入的数据洞察。

4.1 按组计算唯一值数量

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob', 'Alice'],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'category': ['A', 'B', 'A', 'B', 'A', 'C']

}

df = pd.DataFrame(data)

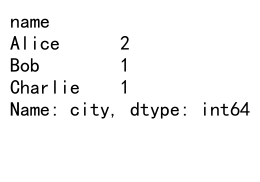

# 按name分组,计算每个人访问的唯一城市数量

unique_cities = df.groupby('name')['city'].nunique()

print(unique_cities)

Output:

这个例子展示了如何按’name’列分组,然后计算每个人访问的唯一城市数量。

4.2 多列分组和唯一值统计

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob', 'Alice'],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'category': ['A', 'B', 'A', 'B', 'A', 'C'],

'product': ['X', 'Y', 'Z', 'X', 'Y', 'Z']

}

df = pd.DataFrame(data)

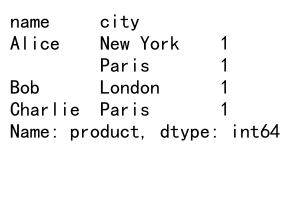

# 按name和city分组,计算每组的唯一产品数量

unique_products = df.groupby(['name', 'city'])['product'].nunique()

print(unique_products)

Output:

这个例子展示了如何按多个列(’name’和’city’)分组,然后计算每组中唯一产品的数量。

5. 高级GroupBy和Unique Count技巧

5.1 使用transform方法

transform方法允许我们在保持原始DataFrame结构的同时应用分组操作:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 使用transform计算每个人的平均销售额

df['avg_sales'] = df.groupby('name')['sales'].transform('mean')

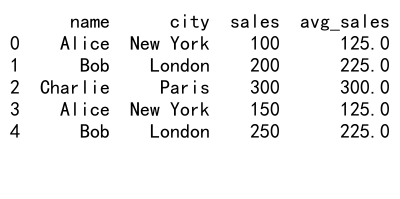

print(df)

Output:

这个例子展示了如何使用transform方法为每个人计算平均销售额,并将结果添加为新列。

5.2 使用filter方法

filter方法允许我们基于组级别的条件筛选数据:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 筛选出总销售额超过400的组

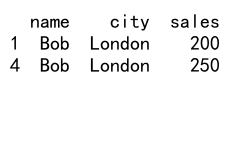

filtered_df = df.groupby('name').filter(lambda x: x['sales'].sum() > 400)

print(filtered_df)

Output:

这个例子展示了如何使用filter方法筛选出总销售额超过400的组。

5.3 使用apply方法

apply方法允许我们对每个组应用自定义函数:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 150, 250]

}

df = pd.DataFrame(data)

# 自定义函数:计算每组的销售额范围

def sales_range(group):

return pd.Series({

'sales_range': group['sales'].max() - group['sales'].min(),

'avg_sales': group['sales'].mean()

})

# 应用自定义函数

result = df.groupby('name').apply(sales_range)

print(result)

这个例子展示了如何使用apply方法对每个组应用自定义函数,计算销售额范围和平均销售额。

6. 处理缺失值

在进行GroupBy和Unique Count操作时,处理缺失值是一个常见的挑战。

6.1 GroupBy时处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob', np.nan],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Berlin'],

'sales': [100, 200, 300, 150, 250, 180]

}

df = pd.DataFrame(data)

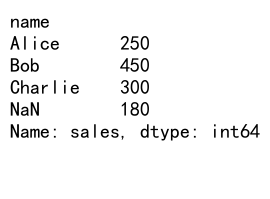

# 处理缺失值

result = df.groupby('name', dropna=False)['sales'].sum()

print(result)

Output:

这个例子展示了如何在GroupBy操作中处理缺失值。dropna=False参数确保包含缺失值的组也被保留。

6.2 Unique Count时处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob', np.nan],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Berlin'],

'category': ['A', 'B', 'A', 'B', 'A', np.nan]

}

df = pd.DataFrame(data)

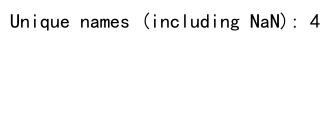

# 计算唯一值数量,包括缺失值

unique_count = df['name'].nunique(dropna=False)

print(f"Unique names (including NaN): {unique_count}")

Output:

这个例子展示了如何在计算唯一值数量时包括缺失值。dropna=False参数确保缺失值也被视为一个唯一值。

7. 性能优化技巧

在处理大型数据集时,GroupBy和Unique Count操作可能会变得很慢。以下是一些优化技巧:

7.1 使用categoricals

对于包含重复值的列,将其转换为categorical类型可以提高性能:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 1000,

'city': ['New York', 'London', 'Paris', 'New York', 'London'] * 1000,

'sales': list(range(5000))

}

df = pd.DataFrame(data)

# 将name列转换为categorical

df['name'] = df['name'].astype('category')

# 进行GroupBy操作

result = df.groupby('name')['sales'].sum()

print(result)

这个例子展示了如何将’name’列转换为categorical类型,这可以在大数据集上提高GroupBy操作的性能。

7.2 使用索引

如果你经常对某一列进行GroupBy操作,可以考虑将该列设置为索引:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 1000,

'city': ['New York', 'London', 'Paris', 'New York', 'London'] * 1000,

'sales': list(range(5000))

}

df = pd.DataFrame(data)

# 将name列设置为索引

df.set_index('name', inplace=True)

# 进行GroupBy操作

result = df.groupby(level=0)['sales'].sum()

print(result)

Output:

这个例子展示了如何将’name’列设置为索引,然后使用level=0进行GroupBy操作,这可以提高性能。

7.3 使用numba加速

对于自定义聚合函数,可以使用numba库来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 1000,

'sales': np.random.randint(100, 1000, 5000)

}

df = pd.DataFrame(data)

# 使用numba加速的自定义函数

@jit(nopython=True)

def fast_range(arr):

return arr.max() - arr.min()

# 应用加速后的函数

result = df.groupby('name')['sales'].agg(fast_range)

print(result)

这个例子展示了如何使用numba的@jit装饰器来加速自定义聚合函数。

8. 处理时间序列数据

GroupBy和Unique Count操作在处理时间序列数据时也非常有用。

8.1 按时间间隔分组

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=1000, freq='H')

data = {

'timestamp': dates,

'value': np.random.randn(1000)

}

df = pd.DataFrame(data)

# 按天分组并计算平均值

daily_avg = df.groupby(df['timestamp'].dt.date)['value'].mean()

print(daily_avg)

这个例子展示了如何按天对时间序列数据进行分组,并计算每天的平均值。

8.2 滚动窗口统计

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=1000, freq='H')

data = {

'timestamp': dates,

'value': np.random.randn(1000)

}

df = pd.DataFrame(data)

# 设置时间戳为索引

df.set_index('timestamp', inplace=True)

# 计算7天滚动窗口的唯一值数量

rolling_unique = df['value'].rolling('7D').apply(lambda x: x.nunique())

print(rolling_unique)

这个例子展示了如何使用滚动窗口来计算时间序列数据中的唯一值数量。

9. 高级数据分析技巧

9.1 交叉表分析

交叉表是一种特殊的分组统计方法,可以快速查看两个分类变量之间的关系:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 100,

'city': ['New York', 'London', 'Paris', 'New York', 'London'] * 100,

'category': np.random.choice(['A', 'B', 'C'], 500)

}

df = pd.DataFrame(data)

# 创建交叉表

cross_tab = pd.crosstab(df['name'], df['category'])

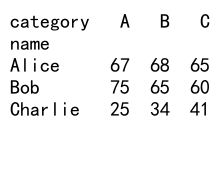

print(cross_tab)

Output:

这个例子展示了如何使用crosstab函数创建交叉表,显示不同人在不同类别中的出现次数。

9.2 透视表

透视表是另一种强大的数据汇总工具:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 100,

'city': ['New York', 'London', 'Paris', 'New York', 'London'] * 100,

'sales': np.random.randint(100, 1000, 500)

}

df = pd.DataFrame(data)

# 创建透视表

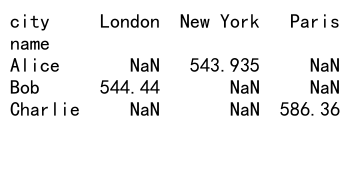

pivot_table = pd.pivot_table(df, values='sales', index='name', columns='city', aggfunc='mean')

print(pivot_table)

Output:

这个例子展示了如何使用pivot_table函数创建透视表,显示每个人在不同城市的平均销售额。

10. 数据可视化

结合GroupBy和Unique Count的结果进行可视化可以帮助我们更好地理解数据。

10.1 柱状图

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 100,

'city': ['New York', 'London', 'Paris', 'New York', 'London'] * 100,

'sales': [100, 200, 300, 150, 250] * 100

}

df = pd.DataFrame(data)

# 按name分组并计算总销售额

sales_by_name = df.groupby('name')['sales'].sum()

# 绘制柱状图

sales_by_name.plot(kind='bar')

plt.title('Total Sales by Name')

plt.xlabel('Name')

plt.ylabel('Total Sales')

plt.show()

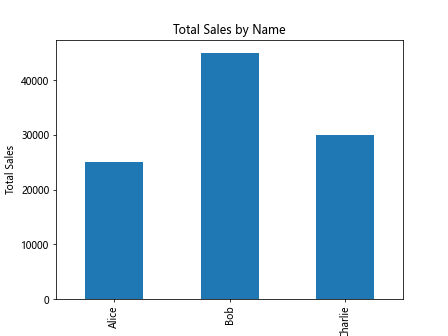

Output:

这个例子展示了如何使用matplotlib库将GroupBy结果可视化为柱状图。

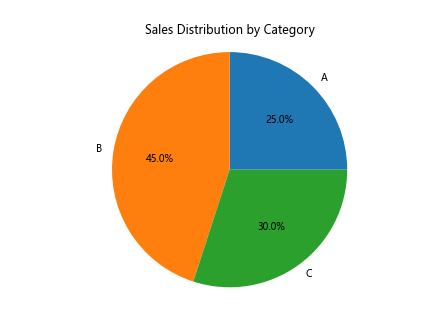

10.2 饼图

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'category': ['A', 'B', 'C', 'A', 'B'] * 100,

'sales': [100, 200, 300, 150, 250] * 100

}

df = pd.DataFrame(data)

# 计算每个类别的销售总额

sales_by_category = df.groupby('category')['sales'].sum()

# 绘制饼图

plt.pie(sales_by_category, labels=sales_by_category.index, autopct='%1.1f%%')

plt.title('Sales Distribution by Category')

plt.axis('equal')

plt.show()

Output:

这个例子展示了如何使用饼图来可视化不同类别的销售额分布。

结论

Pandas的GroupBy和Unique Count操作是数据分析中非常强大的工具。它们允许我们深入挖掘数据,发现隐藏的模式和趋势。通过本文的详细介绍和示例,我们了解了如何使用这些功能进行基本和高级的数据分析,包括处理时间序列数据、优化性能、处理缺失值等。

在实际应用中,这些技术可以帮助我们解答诸如”哪个产品类别的销售增长最快?”、”不同地区的客户行为有何差异?”等复杂问题。通过结合其他Pandas功能和数据可视化工具,我们可以创建全面而深入的数据分析报告。

随着数据量的不断增长和分析需求的日益复杂,掌握这些技能将使你在数据分析领域中脱颖而出。继续练习和探索Pandas的其他功能,你将能够处理更加复杂的数据分析任务,为决策制定提供有力支持。

极客教程

极客教程