Pandas GroupBy Size:高效统计和分析数据的利器

Pandas是Python中最流行的数据处理库之一,而GroupBy操作是数据分析中常用的一种方法。本文将深入探讨Pandas中的GroupBy Size功能,这是一个强大的工具,可以帮助我们快速统计和分析数据。我们将通过详细的解释和丰富的示例代码,全面了解如何使用GroupBy Size来处理各种数据分析任务。

1. GroupBy Size的基本概念

GroupBy Size是Pandas中用于计算分组后每个组中元素数量的方法。它结合了GroupBy操作和Size函数,可以快速统计各个分组的大小。这个功能在数据分析中非常有用,特别是当我们需要了解数据分布或进行频率统计时。

让我们从一个简单的例子开始:

import pandas as pd

# 创建一个示例DataFrame

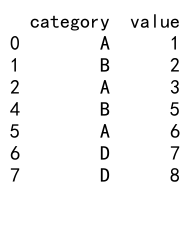

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'value': [1, 2, 3, 4, 5, 6]

})

# 使用GroupBy Size统计每个类别的数量

result = df.groupby('category').size()

print(result)

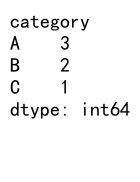

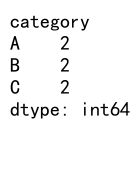

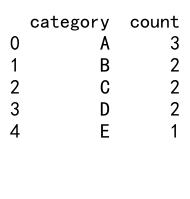

Output:

在这个例子中,我们创建了一个包含’category’和’value’两列的DataFrame。通过groupby('category').size(),我们可以快速统计每个类别出现的次数。这个操作返回一个Series,索引是分组的类别,值是每个类别的计数。

2. GroupBy Size与其他聚合函数的比较

GroupBy Size虽然简单,但它与其他聚合函数有一些重要的区别。让我们比较一下Size和Count:

import pandas as pd

# 创建一个包含缺失值的DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'value': [1, 2, None, 4, 5, 6]

})

# 使用Size

size_result = df.groupby('category').size()

# 使用Count

count_result = df.groupby('category').count()

print("Size result:")

print(size_result)

print("\nCount result:")

print(count_result)

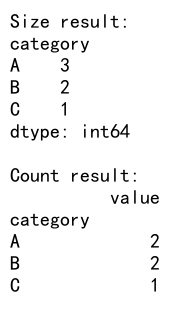

Output:

这个例子展示了Size和Count在处理缺失值时的区别。Size会计算每个组中的所有元素,包括缺失值,而Count默认会忽略缺失值。这在处理包含缺失数据的数据集时尤为重要。

3. 在多列分组中使用GroupBy Size

GroupBy Size不仅可以用于单列分组,还可以应用于多列分组。这在处理复杂的数据结构时非常有用:

import pandas as pd

# 创建一个多列的DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'subcategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z'],

'value': [1, 2, 3, 4, 5, 6]

})

# 使用多列进行分组并计算size

result = df.groupby(['category', 'subcategory']).size()

print(result)

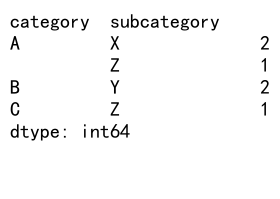

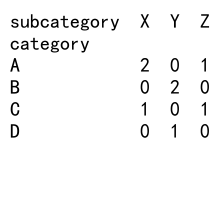

Output:

在这个例子中,我们按’category’和’subcategory’两列进行分组,然后计算每个组合的大小。这种方法可以帮助我们深入了解数据的层次结构和分布。

4. 使用GroupBy Size进行数据归一化

GroupBy Size还可以用于数据归一化,这在许多数据分析和机器学习任务中非常有用:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'value': [10, 20, 30, 40, 50, 60]

})

# 计算每个类别的大小

category_sizes = df.groupby('category').size()

# 使用transform方法将大小应用到每一行

df['normalized_value'] = df['value'] / df.groupby('category')['value'].transform('size')

print(df)

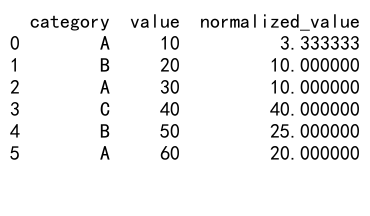

Output:

这个例子展示了如何使用GroupBy Size来归一化数据。我们首先计算每个类别的大小,然后使用这个大小来归一化’value’列。这种方法可以帮助我们消除不同组之间的规模差异。

5. GroupBy Size在时间序列数据中的应用

GroupBy Size在处理时间序列数据时也非常有用,特别是当我们需要按时间间隔统计事件频率时:

import pandas as pd

# 创建一个时间序列DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'event': ['A', 'B', 'A', 'C', 'B', 'A'] * 61

})

# 按月分组并计算每个事件的频率

monthly_event_counts = df.groupby([df['date'].dt.to_period('M'), 'event']).size().unstack(fill_value=0)

print(monthly_event_counts)

在这个例子中,我们创建了一个包含全年数据的DataFrame,然后使用GroupBy Size按月统计每种事件的发生频率。这种方法可以帮助我们识别时间序列数据中的模式和趋势。

6. 使用GroupBy Size进行数据筛选

GroupBy Size还可以用于数据筛选,例如找出频率超过某个阈值的组:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'D', 'D', 'E'],

'value': [1, 2, 3, 4, 5, 6, 7, 8, 9]

})

# 计算每个类别的大小

category_sizes = df.groupby('category').size()

# 筛选出出现次数大于1的类别

frequent_categories = category_sizes[category_sizes > 1]

# 使用筛选结果过滤原DataFrame

filtered_df = df[df['category'].isin(frequent_categories.index)]

print(filtered_df)

Output:

这个例子展示了如何使用GroupBy Size来筛选出频繁出现的类别。我们首先计算每个类别的大小,然后选择出现次数大于1的类别,最后使用这些类别来过滤原始DataFrame。

7. GroupBy Size与其他DataFrame操作的结合

GroupBy Size可以与其他DataFrame操作结合使用,以实现更复杂的数据分析任务:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'value': [10, 20, 30, 40, 50, 60]

})

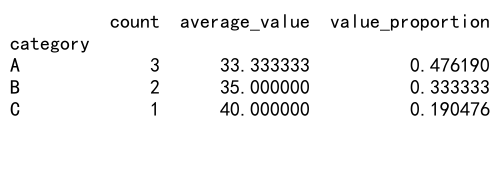

# 计算每个类别的大小和平均值

result = df.groupby('category').agg({

'category': 'size',

'value': 'mean'

})

# 重命名列

result.columns = ['count', 'average_value']

# 计算每个类别的总和占比

result['value_proportion'] = df.groupby('category')['value'].sum() / df['value'].sum()

print(result)

Output:

这个例子展示了如何将GroupBy Size与其他聚合函数和计算结合使用。我们不仅计算了每个类别的大小,还计算了平均值和总和占比。这种方法可以帮助我们全面了解数据的分布和特征。

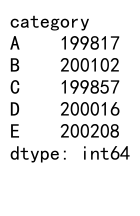

8. 在大型数据集上使用GroupBy Size

当处理大型数据集时,GroupBy Size的效率就显得尤为重要。以下是一个在大型数据集上使用GroupBy Size的示例:

import pandas as pd

import numpy as np

# 创建一个大型DataFrame

n = 1000000

df = pd.DataFrame({

'category': np.random.choice(['A', 'B', 'C', 'D', 'E'], n),

'value': np.random.randn(n)

})

# 使用GroupBy Size

result = df.groupby('category').size()

print(result)

Output:

这个例子创建了一个包含100万行的DataFrame,然后使用GroupBy Size来统计每个类别的数量。尽管数据量很大,Pandas的GroupBy Size操作仍然能够高效地处理。

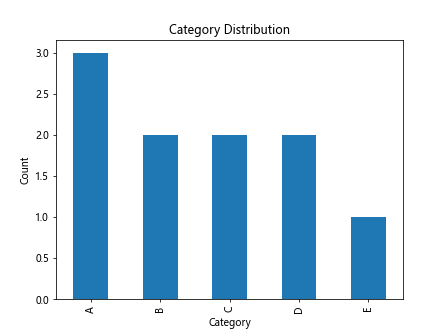

9. GroupBy Size与数据可视化的结合

GroupBy Size的结果通常可以直接用于数据可视化,这可以帮助我们更直观地理解数据分布:

import pandas as pd

import matplotlib.pyplot as plt

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C', 'D', 'E', 'D'],

'value': [1, 2, 3, 4, 5, 6, 7, 8, 9, 10]

})

# 使用GroupBy Size

result = df.groupby('category').size()

# 创建柱状图

result.plot(kind='bar')

plt.title('Category Distribution')

plt.xlabel('Category')

plt.ylabel('Count')

plt.show()

Output:

这个例子展示了如何将GroupBy Size的结果直接用于创建柱状图。这种可视化方法可以帮助我们快速识别数据中的模式和异常。

10. 使用GroupBy Size处理多层索引

当处理具有多层索引的DataFrame时,GroupBy Size也能发挥作用:

import pandas as pd

# 创建一个多层索引的DataFrame

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C', 'C'],

'subcategory': ['X', 'Y', 'X', 'Y', 'X', 'Y'],

'value': [1, 2, 3, 4, 5, 6]

})

df.set_index(['category', 'subcategory'], inplace=True)

# 使用GroupBy Size

result = df.groupby(level='category').size()

print(result)

Output:

这个例子展示了如何在多层索引的DataFrame上使用GroupBy Size。我们可以指定要使用的索引级别来进行分组。

11. GroupBy Size与重采样的结合

在时间序列分析中,GroupBy Size可以与重采样操作结合使用:

import pandas as pd

# 创建一个时间序列DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'event': ['A', 'B', 'A', 'C', 'B', 'A'] * 61

})

df.set_index('date', inplace=True)

# 按周重采样并计算每个事件的频率

weekly_event_counts = df.groupby('event').resample('W').size().unstack(fill_value=0)

print(weekly_event_counts)

这个例子展示了如何将GroupBy Size与重采样操作结合使用。我们首先按事件类型分组,然后按周重采样,最后计算每周每种事件的发生次数。

12. 使用GroupBy Size处理分类数据

GroupBy Size在处理分类数据时特别有用:

import pandas as pd

# 创建一个包含分类数据的DataFrame

df = pd.DataFrame({

'category': pd.Categorical(['A', 'B', 'A', 'C', 'B', 'A', 'D', 'E']),

'value': [1, 2, 3, 4, 5, 6, 7, 8]

})

# 使用GroupBy Size

result = df.groupby('category').size()

# 计算每个类别的比例

result_proportion = result / result.sum()

print("Counts:")

print(result)

print("\nProportions:")

print(result_proportion)

这个例子展示了如何使用GroupBy Size来处理分类数据。我们不仅计算了每个类别的数量,还计算了每个类别占总体的比例。这种方法在分析调查数据或市场份额时特别有用。

13. GroupBy Size与数据透视表的结合

GroupBy Size可以与Pandas的数据透视表功能结合使用,以创建更复杂的数据摘要:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C', 'D'],

'subcategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z', 'X', 'Y'],

'value': [1, 2, 3, 4, 5, 6, 7, 8]

})

# 创建数据透视表并使用size作为聚合函数

pivot_table = pd.pivot_table(df, values='value', index='category',

columns='subcategory', aggfunc='size', fill_value=0)

print(pivot_table)

Output:

这个例子展示了如何使用数据透视表和GroupBy Size来创建一个交叉表。这种方法可以帮助我们快速了解不同类别和子类别的分布情况。

14. 使用GroupBy Size进行异常检测

GroupBy Size可以用于异常检测,例如找出出现频率异常低或高的类别:

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': np.random.choice(['A', 'B', 'C', 'D', 'E'], 1000),

'value': np.random.randn(1000)

})

# 添加一些异常值

df = df.append({'category': 'F', 'value': 0}, ignore_index=True)

df = df.append({'category': 'G', 'value': 0}, ignore_index=True)

df = df.append({'category': 'G', 'value': 0}, ignore_index=True)

# 使用GroupBy Size

category_counts = df.groupby('category').size()

# 计算Z-score

z_scores = (category_counts - category_counts.mean()) / category_counts.std()

# 找出异常值(这里我们定义|Z-score| > 2为异常)

anomalies = z_scores[abs(z_scores) > 2]

print("Anomalies:")

print(anomalies)

这个例子展示了如何使用GroupBy Size来检测异常类别。我们首先计算每个类别的出现次数,然后计算Z-score来识别异常值。这种方法可以帮助我们发现数据中的不寻常模式。

15. GroupBy Size与滑动窗口操作的结合

GroupBy Size可以与滑动窗口操作结合,用于分析时间序列数据中的趋势:

import pandas as pd

import numpy as np

# 创建一个时间序列DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'category': np.random.choice(['A', 'B', 'C'], 365),

'value': np.random.randn(365)

})

# 设置日期为索引

df.set_index('date', inplace=True)

# 使用30天滑动窗口计算每个类别的出现频率

rolling_counts = df.groupby('category').rolling(window='30D').size().unstack(fill_value=0)

print(rolling_counts)

这个例子展示了如何将GroupBy Size与滑动窗口操作结合使用。我们计算了每个类别在30天滑动窗口内的出现频率。这种方法可以帮助我们识别时间序列数据中的短期趋势和周期性模式。

16. 使用GroupBy Size进行数据抽样

GroupBy Size可以用于创建分层抽样:

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000),

'value': np.random.randn(1000)

})

# 计算每个类别的大小

category_sizes = df.groupby('category').size()

# 定义每个类别要抽取的样本数(这里我们抽取每个类别的10%)

sample_sizes = (category_sizes * 0.1).astype(int)

# 进行分层抽样

stratified_sample = df.groupby('category').apply(lambda x: x.sample(n=sample_sizes[x.name]))

print(stratified_sample)

这个例子展示了如何使用GroupBy Size来进行分层抽样。我们首先计算每个类别的大小,然后根据这个大小决定每个类别要抽取的样本数。这种方法可以确保我们的样本保持原始数据的分布特征。

17. GroupBy Size与数据标准化的结合

GroupBy Size可以用于数据标准化,特别是当我们需要考虑组内分布时:

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C', 'C'] * 10,

'value': np.random.randn(60)

})

# 计算每个类别的大小

category_sizes = df.groupby('category').size()

# 使用transform方法计算每个组的均值和标准差

df['group_mean'] = df.groupby('category')['value'].transform('mean')

df['group_std'] = df.groupby('category')['value'].transform('std')

# 进行组内标准化

df['normalized_value'] = (df['value'] - df['group_mean']) / df['group_std']

print(df)

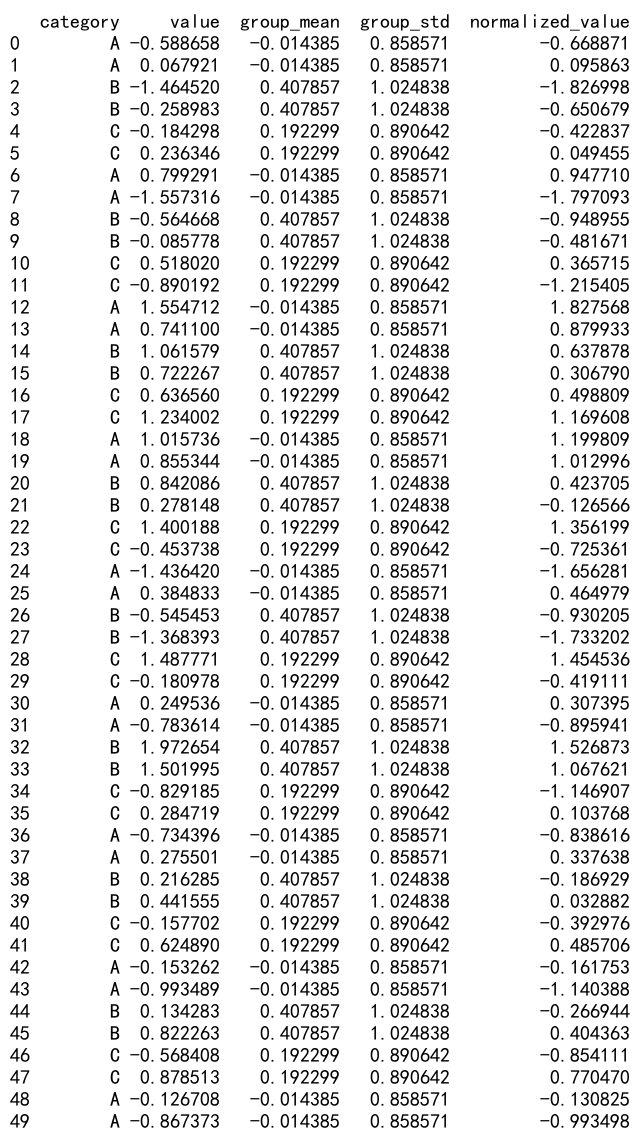

Output:

这个例子展示了如何使用GroupBy Size来辅助数据标准化。我们首先计算每个类别的大小,然后计算每个组的均值和标准差,最后进行组内标准化。这种方法可以帮助我们消除不同组之间的尺度差异,同时保留组内的相对关系。

18. 使用GroupBy Size进行数据质量检查

GroupBy Size可以用于数据质量检查,例如检测重复数据或数据完整性:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'id': [1, 2, 3, 4, 5, 1, 2],

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Alice', 'Bob'],

'value': [10, 20, 30, 40, 50, 60, 70]

})

# 检查ID的唯一性

id_counts = df.groupby('id').size()

duplicate_ids = id_counts[id_counts > 1]

print("Duplicate IDs:")

print(duplicate_ids)

# 检查名称和ID的一致性

name_id_counts = df.groupby(['id', 'name']).size()

inconsistent_name_ids = name_id_counts[name_id_counts > 1]

print("\nInconsistent Name-ID pairs:")

print(inconsistent_name_ids)

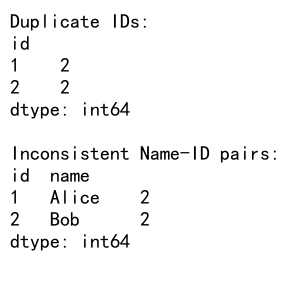

Output:

这个例子展示了如何使用GroupBy Size来进行数据质量检查。我们首先检查ID的唯一性,然后检查名称和ID的一致性。这种方法可以帮助我们快速识别数据中的重复或不一致问题。

19. GroupBy Size在时间序列预测中的应用

GroupBy Size可以用于时间序列预测的特征工程:

import pandas as pd

import numpy as np

# 创建一个时间序列DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'category': np.random.choice(['A', 'B', 'C'], 365),

'value': np.random.randn(365)

})

# 设置日期为索引

df.set_index('date', inplace=True)

# 计算过去7天每个类别的出现次数

df['past_7d_count'] = df.groupby('category').rolling(window='7D').size().reset_index(level=0, drop=True)

# 计算过去30天每个类别的出现次数

df['past_30d_count'] = df.groupby('category').rolling(window='30D').size().reset_index(level=0, drop=True)

print(df)

这个例子展示了如何使用GroupBy Size来创建时间序列预测的特征。我们计算了过去7天和30天每个类别的出现次数。这些特征可以帮助捕捉时间序列数据中的短期和长期趋势。

20. GroupBy Size与数据库操作的结合

最后,让我们看看如何将GroupBy Size与数据库操作结合使用:

import pandas as pd

import sqlite3

# 创建一个示例DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C', 'D', 'E', 'D'],

'value': [1, 2, 3, 4, 5, 6, 7, 8, 9, 10]

})

# 创建一个内存数据库并将DataFrame写入其中

conn = sqlite3.connect(':memory:')

df.to_sql('data', conn, index=False)

# 使用SQL查询执行GroupBy Size操作

query = """

SELECT category, COUNT(*) as count

FROM data

GROUP BY category

"""

result = pd.read_sql_query(query, conn)

print(result)

# 关闭数据库连接

conn.close()

Output:

这个例子展示了如何将GroupBy Size操作转换为SQL查询,并在数据库中执行。这种方法在处理大型数据集或需要与数据库系统集成时特别有用。

总结起来,Pandas的GroupBy Size是一个强大而灵活的工具,可以应用于各种数据分析任务。从基本的频率统计到复杂的时间序列分析,从数据质量检查到特征工程,GroupBy Size都能发挥重要作用。通过本文的详细介绍和丰富的示例,我们希望能够帮助读者充分理解和利用这个功能,提高数据分析的效率和质量。

极客教程

极客教程