Pandas GroupBy和Shift操作:数据分析的强大工具

Pandas是Python中最流行的数据处理库之一,它提供了许多强大的功能来处理结构化数据。在本文中,我们将深入探讨Pandas中的两个重要操作:GroupBy和Shift。这两个操作在数据分析、时间序列处理和复杂计算中扮演着关键角色。我们将通过详细的解释和实际示例来展示如何有效地使用这些工具,以及它们如何帮助我们解决各种数据处理问题。

1. Pandas GroupBy操作

GroupBy操作是数据分析中的一个基本概念,它允许我们将数据分成不同的组,然后对每个组应用特定的操作。这在处理大型数据集时特别有用,可以帮助我们发现数据中的模式和趋势。

1.1 基本的GroupBy操作

让我们从一个简单的例子开始:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [80, 85, 90, 75, 95]

})

# 按名字分组并计算平均分数

grouped = df.groupby('name')['score'].mean()

print(grouped)

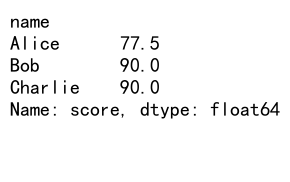

Output:

在这个例子中,我们创建了一个包含名字、年龄、城市和分数的DataFrame。然后,我们使用groupby('name')按名字分组,并计算每个人的平均分数。这个操作会返回一个Series,其中索引是不同的名字,值是对应的平均分数。

1.2 多列分组

GroupBy操作不仅限于单列,我们还可以按多列进行分组:

import pandas as pd

# 创建一个新的DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=6),

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 150, 120, 180, 90, 200],

'website': ['pandasdataframe.com'] * 6

})

# 按日期和类别分组,计算销售总和

grouped = df.groupby(['date', 'category'])['sales'].sum()

print(grouped)

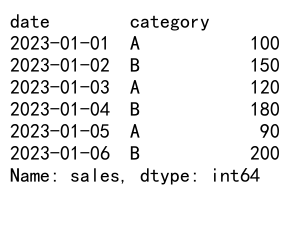

Output:

这个例子展示了如何按多个列(日期和类别)进行分组,然后计算每个组的销售总和。这种方法在分析时间序列数据时特别有用,可以帮助我们了解不同类别在不同时间点的表现。

1.3 应用自定义函数

GroupBy操作的强大之处在于它可以与自定义函数结合使用:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'team': ['A', 'B', 'A', 'B', 'A', 'B'],

'points': [10, 15, 7, 12, 9, 14],

'assists': [5, 7, 3, 6, 4, 8],

'website': ['pandasdataframe.com'] * 6

})

# 定义一个自定义函数

def efficiency(group):

return group['points'].sum() / group['assists'].sum()

# 应用自定义函数

result = df.groupby('team').apply(efficiency)

print(result)

在这个例子中,我们定义了一个efficiency函数来计算每个队伍的效率(总得分除以总助攻)。通过groupby('team').apply(efficiency),我们可以对每个队伍应用这个自定义函数。

1.4 聚合操作

Pandas提供了许多内置的聚合函数,可以同时应用于多个列:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'product': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 150, 120, 180, 90, 200],

'returns': [5, 8, 3, 10, 4, 7],

'website': ['pandasdataframe.com'] * 6

})

# 使用agg方法进行多列聚合

result = df.groupby('product').agg({

'sales': ['sum', 'mean'],

'returns': ['max', 'min']

})

print(result)

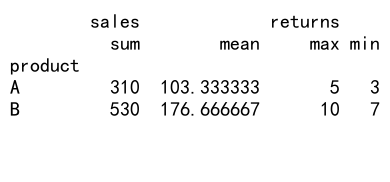

Output:

这个例子展示了如何使用agg方法对不同的列应用不同的聚合函数。对于’sales’列,我们计算了总和和平均值;对于’returns’列,我们找出了最大值和最小值。

2. Pandas Shift操作

Shift操作是另一个强大的工具,特别是在处理时间序列数据时。它允许我们将数据向前或向后移动指定的步数,这在计算变化率、滞后效应等方面非常有用。

2.1 基本的Shift操作

让我们从一个简单的shift操作开始:

import pandas as pd

# 创建一个示例Series

s = pd.Series([1, 2, 3, 4, 5], name='pandasdataframe.com')

# 向后移动1步

shifted = s.shift(1)

print(shifted)

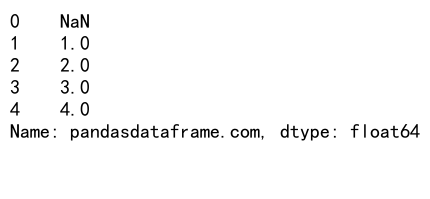

Output:

在这个例子中,我们创建了一个简单的Series,然后使用shift(1)将所有值向后移动一步。这会导致第一个元素变为NaN(因为没有前一个值可以移动到这个位置),而原来的最后一个元素会被”移出”Series。

2.2 在DataFrame中使用Shift

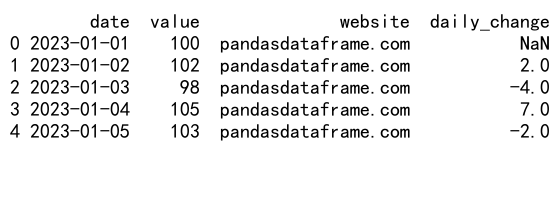

Shift操作也可以应用于DataFrame的列:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=5),

'value': [100, 102, 98, 105, 103],

'website': ['pandasdataframe.com'] * 5

})

# 计算每日变化

df['daily_change'] = df['value'] - df['value'].shift(1)

print(df)

Output:

这个例子展示了如何使用shift操作来计算每日的价值变化。我们将’value’列向后移动一步,然后用原始值减去移动后的值,得到每日的变化量。

2.3 使用不同的填充方法

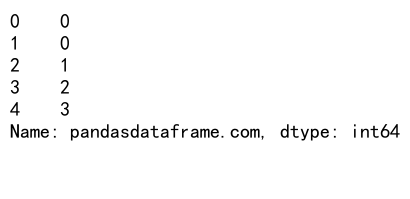

当使用shift操作时,我们可以指定如何填充由于移动而产生的空值:

import pandas as pd

# 创建一个示例Series

s = pd.Series([1, 2, 3, 4, 5], name='pandasdataframe.com')

# 向后移动2步,用0填充

shifted_fill = s.shift(2, fill_value=0)

print(shifted_fill)

Output:

在这个例子中,我们将Series向后移动两步,并使用0来填充由于移动而产生的空值。这在某些情况下比使用默认的NaN更有用。

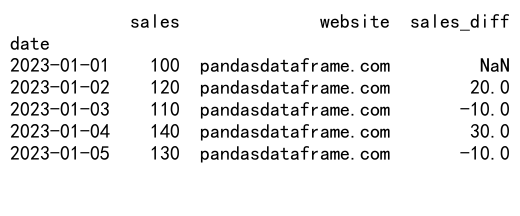

2.4 在时间序列数据中使用Shift

Shift操作在处理时间序列数据时特别有用:

import pandas as pd

# 创建一个时间序列DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=5),

'sales': [100, 120, 110, 140, 130],

'website': ['pandasdataframe.com'] * 5

})

df.set_index('date', inplace=True)

# 计算与前一天的销售差异

df['sales_diff'] = df['sales'] - df['sales'].shift(1)

print(df)

Output:

这个例子展示了如何在一个以日期为索引的DataFrame中使用shift操作。我们计算了每天的销售额与前一天的差异,这可以帮助我们识别销售趋势。

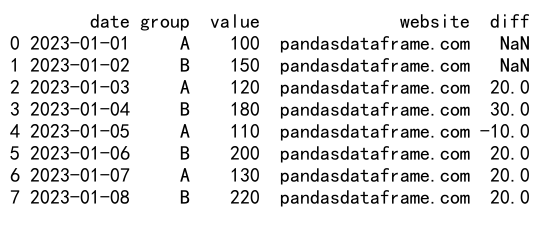

3. 结合GroupBy和Shift的高级操作

当我们将GroupBy和Shift操作结合使用时,可以进行更复杂和强大的数据分析。这种组合允许我们在分组的基础上进行时间序列或序列操作。

3.1 计算组内的差异

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=8),

'group': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [100, 150, 120, 180, 110, 200, 130, 220],

'website': ['pandasdataframe.com'] * 8

})

# 计算每个组内的差异

df['diff'] = df.groupby('group')['value'].diff()

print(df)

Output:

在这个例子中,我们使用groupby('group')['value'].diff()来计算每个组内的连续差异。这允许我们分别查看A组和B组的值变化,而不会混淆不同组之间的计算。

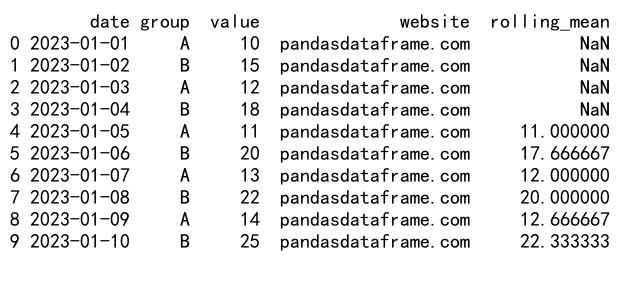

3.2 计算滚动平均

结合GroupBy和Shift,我们可以计算每个组的滚动平均:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=10),

'group': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 15, 12, 18, 11, 20, 13, 22, 14, 25],

'website': ['pandasdataframe.com'] * 10

})

# 计算每个组的3天滚动平均

df['rolling_mean'] = df.groupby('group')['value'].rolling(window=3).mean().reset_index(level=0, drop=True)

print(df)

Output:

这个例子展示了如何使用groupby和rolling函数来计算每个组的3天滚动平均。这种方法在分析每个组的趋势时非常有用。

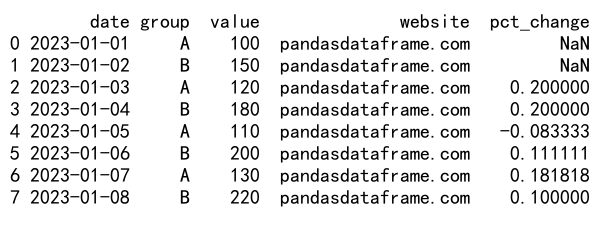

3.3 计算组内的百分比变化

我们可以使用GroupBy和Shift来计算每个组内的百分比变化:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=8),

'group': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [100, 150, 120, 180, 110, 200, 130, 220],

'website': ['pandasdataframe.com'] * 8

})

# 计算每个组内的百分比变化

df['pct_change'] = df.groupby('group')['value'].pct_change()

print(df)

Output:

这个例子展示了如何使用groupby和pct_change函数来计算每个组内的百分比变化。这对于分析每个组的增长率非常有用。

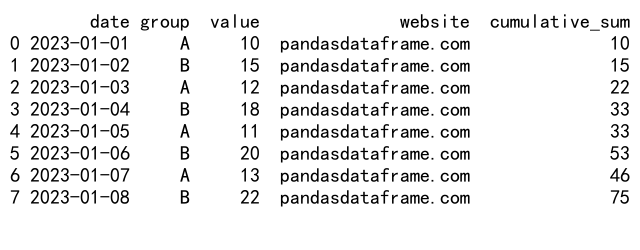

3.4 计算组内的累积和

使用GroupBy和cumsum,我们可以计算每个组的累积和:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=8),

'group': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 15, 12, 18, 11, 20, 13, 22],

'website': ['pandasdataframe.com'] * 8

})

# 计算每个组的累积和

df['cumulative_sum'] = df.groupby('group')['value'].cumsum()

print(df)

Output:

这个例子展示了如何使用groupby和cumsum函数来计算每个组的累积和。这对于跟踪每个组的总体进展非常有用。

4. 高级应用场景

现在,让我们探讨一些更复杂的应用场景,这些场景结合了GroupBy和Shift操作,展示了这些工具在实际数据分析中的强大功能。

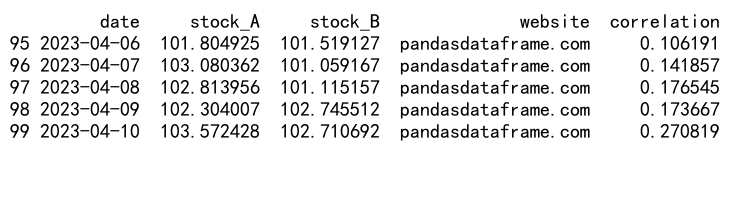

4.1 计算移动相关性

在金融分析中,计算不同资产之间的移动相关性是一个常见任务:

import pandas as pd

import numpy as np

# 创建一个示例DataFrame,模拟两支股票的价格

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=100),

'stock_A': np.random.randn(100).cumsum() + 100,

'stock_B': np.random.randn(100).cumsum() + 100,

'website': ['pandasdataframe.com'] * 100

})

# 计算30天移动相关性

window = 30

df['correlation'] = df['stock_A'].rolling(window=window).corr(df['stock_B'])

print(df.tail())

Output:

这个例子展示了如何计算两支股票之间的30天移动相关性。我们首先创建了一个模拟两支股票价格的DataFrame,然后使用rolling和corr函数来计算移动相关性。这种分析可以帮助投资者了解两支股票之间的关系是否随时间变化。

4.2 计算组内的排名变化

在竞争分析中,跟踪不同参与者的排名变化是很有价值的:

import pandas as pd

# 创建一个示例DataFrame

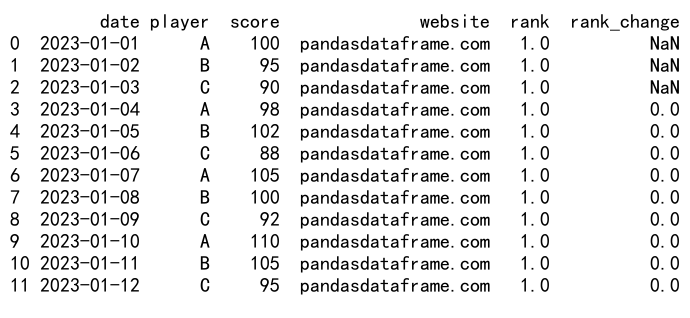

df =pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=12),

'player': ['A', 'B', 'C', 'A', 'B', 'C', 'A', 'B', 'C', 'A', 'B', 'C'],

'score': [100, 95, 90, 98, 102, 88, 105, 100, 92, 110, 105, 95],

'website': ['pandasdataframe.com'] * 12

})

# 计算每个日期的排名

df['rank'] = df.groupby('date')['score'].rank(ascending=False, method='dense')

# 计算排名变化

df['rank_change'] = df.groupby('player')['rank'].diff()

print(df)

Output:

这个例子展示了如何计算每个玩家在不同日期的排名,以及他们的排名变化。我们首先使用groupby和rank函数计算每个日期的排名,然后使用diff函数计算每个玩家的排名变化。这种分析可以帮助我们追踪参与者的表现趋势。

4.3 计算滚动的组间差异

在比较不同组的表现时,计算滚动的组间差异可以提供有价值的洞察:

import pandas as pd

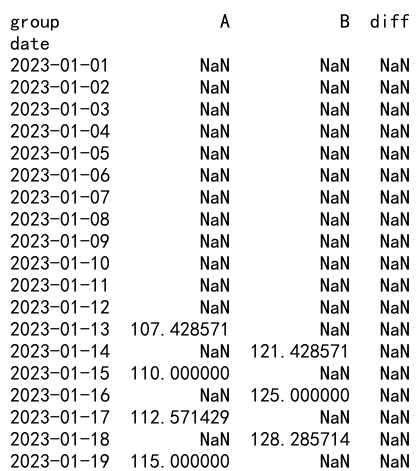

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=20),

'group': ['A', 'B'] * 10,

'value': [100, 110, 102, 115, 105, 118, 108, 122, 110, 125,

112, 128, 115, 132, 118, 135, 120, 138, 122, 142],

'website': ['pandasdataframe.com'] * 20

})

# 计算每个组的7天滚动平均

df['rolling_avg'] = df.groupby('group')['value'].rolling(window=7).mean().reset_index(level=0, drop=True)

# 计算组间的滚动差异

df_pivot = df.pivot(index='date', columns='group', values='rolling_avg')

df_pivot['diff'] = df_pivot['A'] - df_pivot['B']

print(df_pivot)

Output:

这个例子展示了如何计算两个组之间的滚动差异。我们首先计算每个组的7天滚动平均,然后使用pivot函数重塑数据,最后计算两个组之间的差异。这种分析可以帮助我们了解两个组之间的相对表现如何随时间变化。

4.4 计算组内的累积百分比

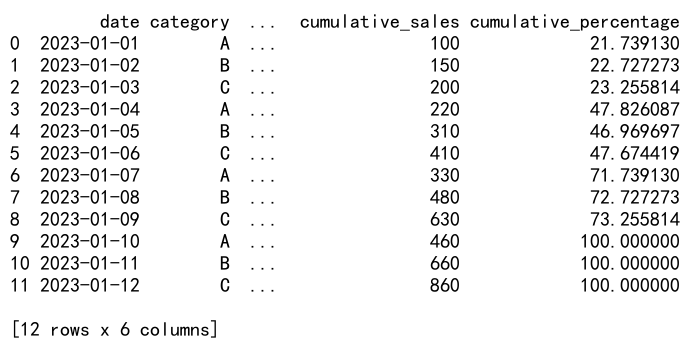

在销售分析中,计算每个类别的累积销售百分比是一个常见任务:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=12),

'category': ['A', 'B', 'C'] * 4,

'sales': [100, 150, 200, 120, 160, 210, 110, 170, 220, 130, 180, 230],

'website': ['pandasdataframe.com'] * 12

})

# 计算每个类别的总销售额

total_sales = df.groupby('category')['sales'].transform('sum')

# 计算累积销售额

df['cumulative_sales'] = df.groupby('category')['sales'].cumsum()

# 计算累积百分比

df['cumulative_percentage'] = df['cumulative_sales'] / total_sales * 100

print(df)

Output:

这个例子展示了如何计算每个类别的累积销售百分比。我们首先计算每个类别的总销售额,然后计算累积销售额,最后计算累积百分比。这种分析可以帮助我们了解每个类别的销售进度。

5. 性能优化和注意事项

在使用Pandas的GroupBy和Shift操作时,有一些性能优化和注意事项需要考虑:

5.1 使用适当的数据类型

确保你的数据使用适当的数据类型可以显著提高性能。例如,对于分类数据,使用category数据类型可以减少内存使用并提高处理速度:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'group': ['A', 'B', 'C'] * 1000,

'value': range(3000),

'website': ['pandasdataframe.com'] * 3000

})

# 将'group'列转换为category类型

df['group'] = df['group'].astype('category')

# 进行GroupBy操作

result = df.groupby('group')['value'].mean()

print(result)

在这个例子中,我们将’group’列转换为category类型。对于包含大量重复值的列,这可以显著提高GroupBy操作的性能。

5.2 使用索引进行GroupBy操作

当可能的时候,使用索引进行GroupBy操作可以提高性能:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=1000),

'value': range(1000),

'website': ['pandasdataframe.com'] * 1000

})

# 将'date'列设置为索引

df.set_index('date', inplace=True)

# 按月分组并计算平均值

result = df.groupby(pd.Grouper(freq='M'))['value'].mean()

print(result)

在这个例子中,我们将’date’列设置为索引,然后使用pd.Grouper按月分组。这种方法通常比使用非索引列进行分组更快。

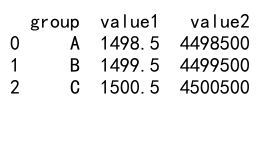

5.3 避免链式操作

在进行复杂的数据处理时,避免使用过多的链式操作可以提高性能:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'group': ['A', 'B', 'C'] * 1000,

'value1': range(3000),

'value2': range(3000, 6000),

'website': ['pandasdataframe.com'] * 3000

})

# 不推荐的方式:链式操作

# result = df.groupby('group').agg({'value1': 'mean'}).reset_index().merge(

# df.groupby('group').agg({'value2': 'sum'}).reset_index(),

# on='group'

# )

# 推荐的方式:一次性完成所有聚合操作

result = df.groupby('group').agg({

'value1': 'mean',

'value2': 'sum'

}).reset_index()

print(result)

Output:

在这个例子中,我们展示了如何避免使用多个链式操作,而是一次性完成所有聚合操作。这种方法通常更高效,因为它减少了中间结果的创建和内存使用。

5.4 注意内存使用

在处理大型数据集时,要注意内存使用。使用chunksize参数可以帮助你分批处理数据:

import pandas as pd

# 假设我们有一个大型CSV文件

# 使用chunksize参数分批读取和处理数据

chunk_size = 10000

result = pd.DataFrame()

for chunk in pd.read_csv('large_file.csv', chunksize=chunk_size):

# 对每个chunk进行处理

processed = chunk.groupby('group')['value'].mean()

result = result.append(processed)

# 对最终结果进行处理

final_result = result.groupby(level=0).mean()

print(final_result)

这个例子展示了如何使用chunksize参数分批读取和处理大型CSV文件。这种方法可以帮助你处理超出内存容量的数据集。

6. 结论

Pandas的GroupBy和Shift操作是数据分析中非常强大的工具。它们允许我们进行复杂的数据分组、时间序列分析和序列操作。通过结合这两种操作,我们可以执行更高级的分析任务,如计算组内差异、滚动平均、排名变化等。

在使用这些工具时,重要的是要考虑性能优化和内存使用。选择适当的数据类型、利用索引、避免不必要的链式操作,以及在处理大型数据集时使用分批处理,都可以帮助提高分析的效率。

随着数据分析需求的不断增长和复杂化,掌握Pandas的GroupBy和Shift操作将使你能够更有效地处理各种数据分析任务,从简单的数据汇总到复杂的时间序列分析。通过不断实践和探索,你将能够充分利用这些工具的潜力,为你的数据分析工作带来更多洞察和价值。

极客教程

极客教程