Pandas GroupBy Count:高效数据分组统计的利器

Pandas是Python中最流行的数据处理库之一,其中的GroupBy功能为数据分析提供了强大的支持。本文将深入探讨Pandas中的GroupBy Count操作,这是一种常用于数据分组和统计的方法。我们将通过详细的解释和丰富的示例代码,帮助您全面掌握这一重要技能。

1. GroupBy Count的基本概念

GroupBy Count是Pandas中用于对数据进行分组并计数的操作。它允许我们按照一个或多个列的值将数据分成不同的组,然后统计每个组中的记录数量。这种操作在数据分析中非常常见,例如统计不同类别的商品销量、不同地区的客户数量等。

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 使用GroupBy Count

result = df.groupby('category').size()

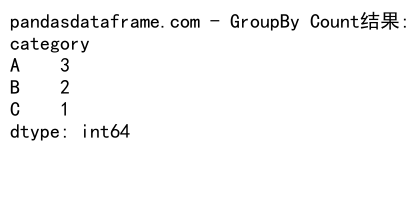

print("pandasdataframe.com - GroupBy Count结果:")

print(result)

Output:

在这个例子中,我们首先创建了一个包含’category’和’value’两列的DataFrame。然后,我们使用groupby('category').size()对数据按’category’列进行分组,并计算每个组的大小(即记录数量)。

2. GroupBy Count的不同方法

Pandas提供了多种方法来执行GroupBy Count操作。以下是几种常用的方法:

2.1 使用size()方法

size()方法是最直接的GroupBy Count方法之一。它返回每个组的元素数量。

import pandas as pd

# 创建示例数据

data = {

'fruit': ['apple', 'banana', 'apple', 'cherry', 'banana', 'date'],

'color': ['red', 'yellow', 'green', 'red', 'yellow', 'brown']

}

df = pd.DataFrame(data)

# 使用size()方法

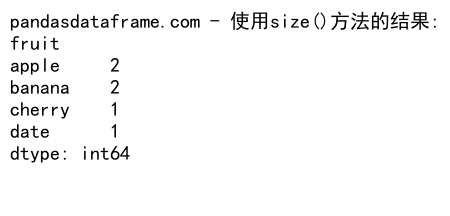

result = df.groupby('fruit').size()

print("pandasdataframe.com - 使用size()方法的结果:")

print(result)

Output:

这个例子展示了如何使用size()方法来统计每种水果出现的次数。

2.2 使用count()方法

count()方法类似于size(),但它可以应用于特定的列,并且会排除NaN值。

import pandas as pd

# 创建示例数据

data = {

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Tokyo'],

'population': [8.4, 8.9, 2.2, None, 8.9, 13.9]

}

df = pd.DataFrame(data)

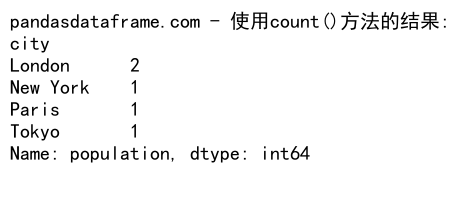

# 使用count()方法

result = df.groupby('city')['population'].count()

print("pandasdataframe.com - 使用count()方法的结果:")

print(result)

Output:

在这个例子中,我们使用count()方法来统计每个城市的人口数据记录数量,忽略了NaN值。

2.3 使用value_counts()方法

value_counts()方法是另一种快速进行分组计数的方法,特别适用于单列数据。

import pandas as pd

# 创建示例数据

data = {

'animal': ['cat', 'dog', 'cat', 'bird', 'dog', 'cat', 'fish']

}

df = pd.DataFrame(data)

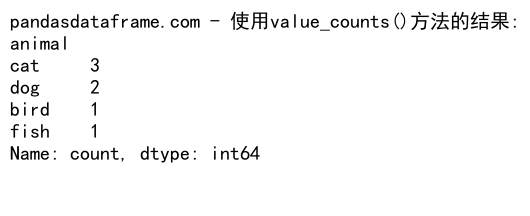

# 使用value_counts()方法

result = df['animal'].value_counts()

print("pandasdataframe.com - 使用value_counts()方法的结果:")

print(result)

Output:

这个例子展示了如何使用value_counts()方法来快速统计不同动物的出现次数。

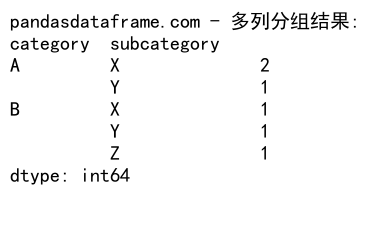

3. 多列分组

GroupBy Count不仅可以对单列进行分组,还可以同时对多列进行分组。这在处理复杂数据时非常有用。

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'subcategory': ['X', 'Y', 'X', 'Z', 'Y', 'X'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 多列分组

result = df.groupby(['category', 'subcategory']).size()

print("pandasdataframe.com - 多列分组结果:")

print(result)

Output:

在这个例子中,我们同时按’category’和’subcategory’两列进行分组,然后计算每个组合的出现次数。

4. 处理缺失值

在进行GroupBy Count操作时,处理缺失值(NaN)是一个重要的考虑因素。Pandas提供了多种方法来处理这种情况。

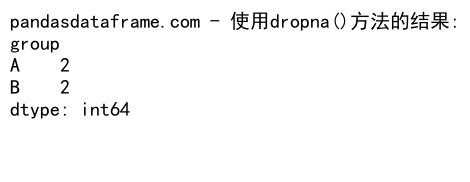

4.1 使用dropna()方法

import pandas as pd

import numpy as np

# 创建包含NaN的示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, np.nan, 3, 4, np.nan, 6]

}

df = pd.DataFrame(data)

# 使用dropna()方法

result = df.dropna().groupby('group').size()

print("pandasdataframe.com - 使用dropna()方法的结果:")

print(result)

Output:

在这个例子中,我们首先使用dropna()方法删除包含NaN的行,然后进行分组计数。

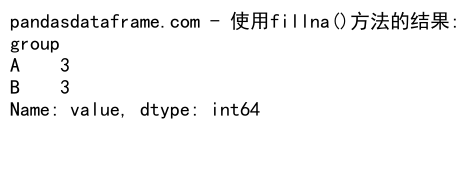

4.2 使用fillna()方法

import pandas as pd

import numpy as np

# 创建包含NaN的示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, np.nan, 3, 4, np.nan, 6]

}

df = pd.DataFrame(data)

# 使用fillna()方法

df['value'] = df['value'].fillna('Unknown')

result = df.groupby('group')['value'].count()

print("pandasdataframe.com - 使用fillna()方法的结果:")

print(result)

Output:

这个例子展示了如何使用fillna()方法将NaN值替换为’Unknown’,然后进行分组计数。

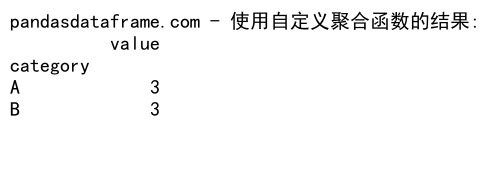

5. 自定义聚合函数

除了内置的计数方法,Pandas还允许我们使用自定义的聚合函数进行GroupBy操作。

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 自定义聚合函数

def custom_count(x):

return len(x)

# 使用自定义函数

result = df.groupby('category').agg({'value': custom_count})

print("pandasdataframe.com - 使用自定义聚合函数的结果:")

print(result)

Output:

在这个例子中,我们定义了一个简单的自定义函数custom_count,它实现了与内置count()方法相同的功能。然后,我们使用agg()方法应用这个自定义函数。

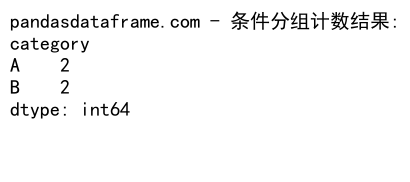

6. 条件分组计数

有时,我们可能需要在分组计数时应用某些条件。Pandas提供了灵活的方法来实现这一点。

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 条件分组计数

result = df[df['value'] > 2].groupby('category').size()

print("pandasdataframe.com - 条件分组计数结果:")

print(result)

Output:

这个例子展示了如何只对’value’大于2的行进行分组计数。

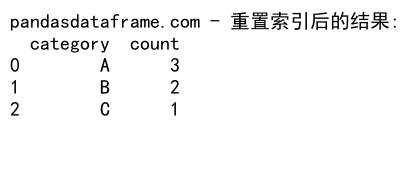

7. 重置索引

GroupBy操作的结果通常是一个Series或DataFrame,其中分组列成为了索引。有时我们可能希望将这些索引重置为普通列。

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# GroupBy Count并重置索引

result = df.groupby('category').size().reset_index(name='count')

print("pandasdataframe.com - 重置索引后的结果:")

print(result)

Output:

在这个例子中,我们使用reset_index()方法将分组结果的索引重置为普通列,并将计数列命名为’count’。

8. 处理大型数据集

当处理大型数据集时,GroupBy Count操作可能会变得耗时。以下是一些提高效率的技巧:

8.1 使用分块处理

import pandas as pd

# 假设我们有一个大型CSV文件

chunk_size = 1000

result = pd.Series(dtype=int)

for chunk in pd.read_csv('pandasdataframe.com_large_file.csv', chunksize=chunk_size):

result = result.add(chunk['category'].value_counts(), fill_value=0)

print("pandasdataframe.com - 分块处理大型数据集的结果:")

print(result)

这个例子展示了如何使用分块读取大型CSV文件,并逐步累加GroupBy Count的结果。

8.2 使用categoricals

对于包含重复值较多的列,将其转换为categorical类型可以提高GroupBy操作的效率。

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A'] * 1000,

'value': range(6000)

}

df = pd.DataFrame(data)

# 将category列转换为categorical类型

df['category'] = df['category'].astype('category')

# 进行GroupBy Count

result = df.groupby('category').size()

print("pandasdataframe.com - 使用categorical类型的结果:")

print(result)

这个例子展示了如何将’category’列转换为categorical类型,这在处理大型数据集时可以显著提高性能。

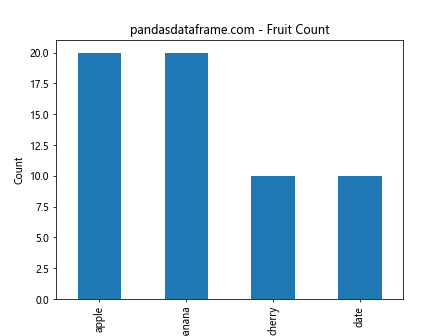

9. 可视化GroupBy Count结果

将GroupBy Count的结果可视化可以帮助我们更直观地理解数据。Pandas与Matplotlib的结合使这一过程变得简单。

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'fruit': ['apple', 'banana', 'apple', 'cherry', 'banana', 'date'] * 10

}

df = pd.DataFrame(data)

# 进行GroupBy Count

result = df['fruit'].value_counts()

# 绘制柱状图

result.plot(kind='bar')

plt.title('pandasdataframe.com - Fruit Count')

plt.xlabel('Fruit')

plt.ylabel('Count')

plt.show()

Output:

这个例子展示了如何使用Matplotlib将GroupBy Count的结果绘制成柱状图。

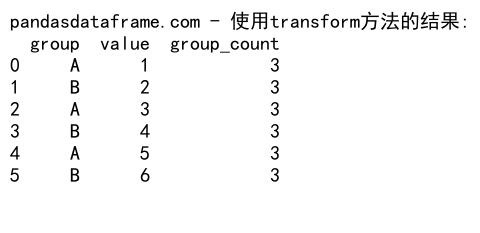

10. 高级GroupBy Count技巧

10.1 使用transform方法

transform方法允许我们将GroupBy操作的结果广播回原始DataFrame的形状。

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 使用transform方法

df['group_count'] = df.groupby('group')['value'].transform('count')

print("pandasdataframe.com - 使用transform方法的结果:")

print(df)

Output:

这个例子展示了如何使用transform方法将每个组的计数添加为新列。

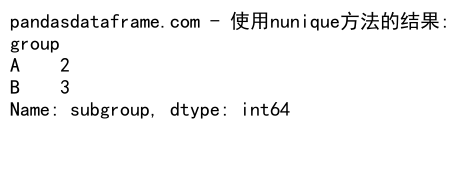

10.2 使用nunique方法

nunique方法用于计算每个组中唯一值的数量。

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'B', 'A', 'B', 'A', 'B'],

'subgroup': ['X', 'Y', 'X', 'Z', 'Y', 'X']

}

df = pd.DataFrame(data)

# 使用nunique方法

result = df.groupby('group')['subgroup'].nunique()

print("pandasdataframe.com - 使用nunique方法的结果:")

print(result)

Output:

这个例子展示了如何使用nunique方法计算每个组中唯一子组的数量。

结论

Pandas的GroupBy Count功能是数据分析中不可或缺的工具。通过本文的详细介绍和丰富的示例,我们深入探讨了GroupBy Count的各种用法和技巧。从基本的分组计数到处理大型数据集,从处理缺失值到自定义聚合函数,我们涵盖了广泛的应用场景。掌握这些技能将极大地提高您的数据处理和分析能力,使您能够更有效地从数据中提取有价值的见解。

无论您是数据分析师、数据科学家还是Python开发者,熟练运用Pandas的GroupBy Count功能都将成为您的得力助手。通过实践和不断探索,您将发现更多GroupBy Count的高级应用,进一步提升您的数据分析技能。

11. GroupBy Count与其他Pandas功能的结合

GroupBy Count不仅可以单独使用,还可以与Pandas的其他功能结合,创造出更强大的数据分析工具。

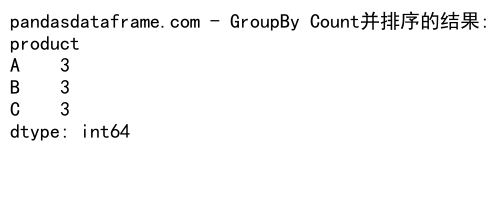

11.1 结合排序功能

我们可以将GroupBy Count的结果与排序功能结合,以获得更有意义的数据洞察。

import pandas as pd

# 创建示例数据

data = {

'product': ['A', 'B', 'C', 'A', 'B', 'A', 'C', 'B', 'C'],

'sales': [100, 200, 150, 300, 250, 180, 220, 190, 170]

}

df = pd.DataFrame(data)

# GroupBy Count并排序

result = df.groupby('product').size().sort_values(ascending=False)

print("pandasdataframe.com - GroupBy Count并排序的结果:")

print(result)

Output:

这个例子展示了如何对产品进行分组计数,并按照计数结果降序排列。

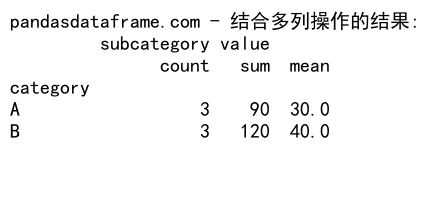

11.2 结合多列操作

我们可以在GroupBy Count的同时执行其他聚合操作,以获得更全面的数据概览。

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'subcategory': ['X', 'Y', 'X', 'Z', 'Y', 'X'],

'value': [10, 20, 30, 40, 50, 60]

}

df = pd.DataFrame(data)

# 多列操作

result = df.groupby('category').agg({

'subcategory': 'count',

'value': ['sum', 'mean']

})

print("pandasdataframe.com - 结合多列操作的结果:")

print(result)

Output:

这个例子展示了如何在进行分组计数的同时,计算’value’列的总和和平均值。

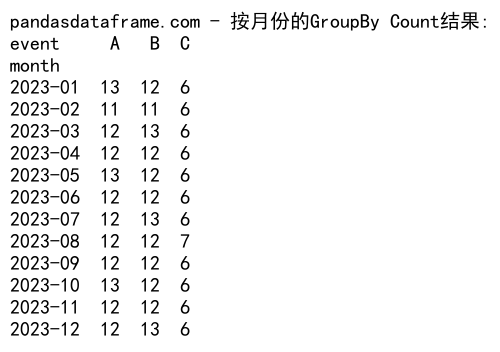

12. 处理时间序列数据

GroupBy Count在处理时间序列数据时也非常有用,特别是在进行时间相关的统计时。

import pandas as pd

# 创建时间序列数据

date_rng = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': date_rng,

'event': ['A', 'B', 'C', 'A', 'B'] * 73

}

df = pd.DataFrame(data)

# 按月份进行GroupBy Count

df['month'] = df['date'].dt.to_period('M')

result = df.groupby('month')['event'].value_counts().unstack()

print("pandasdataframe.com - 按月份的GroupBy Count结果:")

print(result)

Output:

这个例子展示了如何对一年的数据按月份进行分组,并计算每个月中不同事件的发生次数。

13. 使用GroupBy Count进行数据清洗

GroupBy Count不仅用于数据分析,还可以帮助我们发现和处理数据中的异常。

import pandas as pd

# 创建包含异常值的数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'D', 'D'],

'value': [1, 2, 3, 4, 5, 6, 7, 8]

}

df = pd.DataFrame(data)

# 使用GroupBy Count识别低频类别

category_counts = df['category'].value_counts()

rare_categories = category_counts[category_counts < 2].index

# 移除低频类别

df_cleaned = df[~df['category'].isin(rare_categories)]

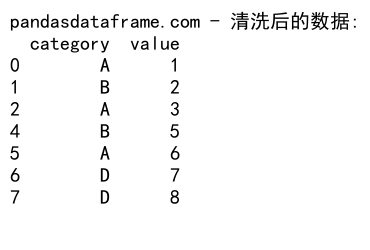

print("pandasdataframe.com - 清洗后的数据:")

print(df_cleaned)

Output:

这个例子展示了如何使用GroupBy Count来识别和移除数据集中出现频率较低的类别。

14. GroupBy Count在机器学习中的应用

在机器学习中,特别是在特征工程阶段,GroupBy Count是一个非常有用的工具。

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A'] * 100,

'subcategory': ['X', 'Y', 'Z', 'X', 'Y', 'Z'] * 100,

'target': [0, 1, 1, 0, 1, 0] * 100

}

df = pd.DataFrame(data)

# 使用GroupBy Count创建新特征

df['category_count'] = df.groupby('category')['category'].transform('count')

df['subcategory_count'] = df.groupby('subcategory')['subcategory'].transform('count')

# 准备特征和目标变量

X = df[['category_count', 'subcategory_count']]

y = df['target']

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 标准化特征

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

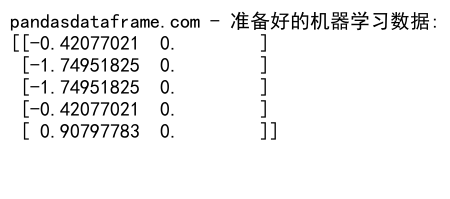

print("pandasdataframe.com - 准备好的机器学习数据:")

print(X_train_scaled[:5])

Output:

这个例子展示了如何使用GroupBy Count创建新的特征,这些特征可以用于机器学习模型的训练。

15. GroupBy Count的性能优化

当处理大型数据集时,GroupBy Count的性能可能会成为一个问题。以下是一些优化技巧:

15.1 使用Categorical数据类型

import pandas as pd

import numpy as np

# 创建大型数据集

n = 1000000

data = {

'category': np.random.choice(['A', 'B', 'C', 'D'], n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 转换为categorical类型

df['category'] = df['category'].astype('category')

# 执行GroupBy Count

result = df.groupby('category').size()

print("pandasdataframe.com - 使用Categorical类型的GroupBy Count结果:")

print(result)

使用Categorical数据类型可以显著提高大型数据集的GroupBy Count性能。

15.2 使用Numba加速

对于更复杂的自定义聚合函数,可以考虑使用Numba进行加速。

import pandas as pd

import numpy as np

from numba import jit

@jit(nopython=True)

def custom_count(array):

return len(array)

# 创建示例数据

data = {

'category': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

}

df = pd.DataFrame(data)

# 使用Numba加速的自定义函数

result = df.groupby('category')['value'].agg(custom_count)

print("pandasdataframe.com - 使用Numba加速的GroupBy Count结果:")

print(result)

这个例子展示了如何使用Numba来加速自定义的计数函数。

结语

通过本文的深入探讨,我们全面了解了Pandas中GroupBy Count的强大功能和广泛应用。从基本的分组计数到高级的数据分析技巧,从处理小型数据集到优化大规模数据处理,我们涵盖了GroupBy Count的方方面面。

GroupBy Count不仅是一个简单的计数工具,它还是数据清洗、特征工程和数据可视化的重要组成部分。通过灵活运用GroupBy Count,数据分析师和数据科学家可以更有效地探索数据,发现隐藏的模式和趋势。

随着数据规模的不断增长和分析需求的日益复杂,掌握和灵活运用GroupBy Count将成为数据专业人士的必备技能。我们鼓励读者在实际项目中多加练习和应用,不断探索GroupBy Count的新用法,以充分发挥这一强大工具的潜力。

最后,记住数据分析是一个不断学习和创新的过程。GroupBy Count只是Pandas和数据分析世界中的一小部分,还有更多精彩的功能和技巧等待您去发现和掌握。保持好奇心,不断学习和实践,您将在数据分析的道路上走得更远。

极客教程

极客教程