Pandas GroupBy 和计算所有列平均值的全面指南

参考:pandas groupby average all columns

Pandas 是一个强大的数据处理和分析库,其中 GroupBy 操作和计算平均值是常见的数据分析任务。本文将详细介绍如何使用 Pandas 的 GroupBy 功能对数据进行分组,并计算所有列的平均值。我们将探讨不同的方法、技巧和注意事项,以帮助您更好地理解和应用这些概念。

1. Pandas GroupBy 简介

GroupBy 是 Pandas 中一个非常重要的功能,它允许我们根据一个或多个列对数据进行分组,然后对每个组应用各种聚合操作。这种操作类似于 SQL 中的 GROUP BY 子句。

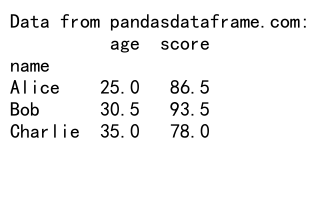

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'score': [85, 92, 78, 88, 95]

}

df = pd.DataFrame(data)

# 按 name 列分组并计算 age 和 score 的平均值

result = df.groupby('name').mean()

print("Data from pandasdataframe.com:")

print(result)

Output:

在这个例子中,我们创建了一个包含姓名、年龄和分数的数据框。然后,我们使用 groupby('name') 按姓名分组,并使用 mean() 计算每个组的平均年龄和分数。

2. 计算所有列的平均值

在某些情况下,我们可能需要计算数据框中所有数值列的平均值。Pandas 提供了几种方法来实现这一目标。

2.1 使用 mean() 方法

最直接的方法是使用 mean() 方法,它会自动计算所有数值列的平均值:

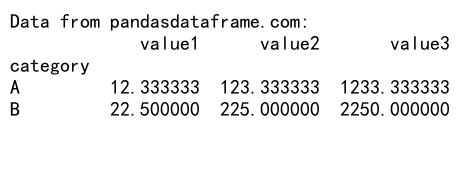

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A'],

'value1': [10, 20, 15, 25, 12],

'value2': [100, 200, 150, 250, 120],

'value3': [1000, 2000, 1500, 2500, 1200]

}

df = pd.DataFrame(data)

# 按 category 分组并计算所有数值列的平均值

result = df.groupby('category').mean()

print("Data from pandasdataframe.com:")

print(result)

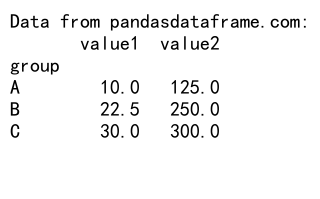

Output:

在这个例子中,我们创建了一个包含类别和三个数值列的数据框。使用 groupby('category').mean() 会自动计算每个类别的所有数值列的平均值。

2.2 使用 agg() 方法

agg() 方法提供了更灵活的方式来应用聚合函数:

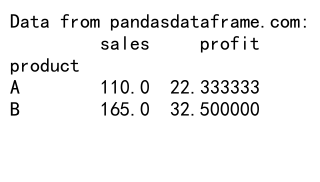

import pandas as pd

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A'],

'sales': [100, 150, 120, 180, 110],

'profit': [20, 30, 25, 35, 22]

}

df = pd.DataFrame(data)

# 使用 agg() 方法计算平均值

result = df.groupby('product').agg('mean')

print("Data from pandasdataframe.com:")

print(result)

Output:

这个例子展示了如何使用 agg() 方法来计算每个产品的平均销售额和利润。

3. 处理非数值列

在实际应用中,数据框可能包含非数值列。在这种情况下,我们需要特别注意如何处理这些列。

3.1 自动忽略非数值列

默认情况下,mean() 和 agg('mean') 会自动忽略非数值列:

import pandas as pd

# 创建包含非数值列的示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'score': [85, 92, 78, 88, 95],

'grade': ['A', 'B', 'C', 'A', 'A']

}

df = pd.DataFrame(data)

# 按 name 分组并计算平均值

result = df.groupby('name').mean()

print("Data from pandasdataframe.com:")

print(result)

在这个例子中,’grade’ 列是非数值的,所以在计算平均值时会被自动忽略。

3.2 选择特定列计算平均值

如果我们只想计算特定列的平均值,可以在 groupby() 后使用索引或列名:

import pandas as pd

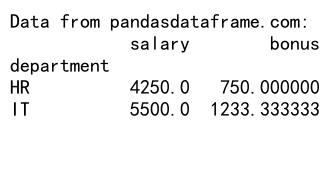

# 创建示例数据

data = {

'department': ['IT', 'HR', 'IT', 'HR', 'IT'],

'employee_id': [101, 102, 103, 104, 105],

'salary': [5000, 4500, 5500, 4000, 6000],

'bonus': [1000, 800, 1200, 700, 1500]

}

df = pd.DataFrame(data)

# 只计算 salary 和 bonus 的平均值

result = df.groupby('department')[['salary', 'bonus']].mean()

print("Data from pandasdataframe.com:")

print(result)

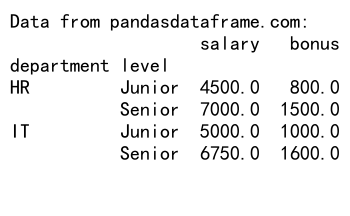

Output:

这个例子展示了如何只计算 ‘salary’ 和 ‘bonus’ 列的平均值,而忽略其他列。

4. 处理缺失值

在实际数据中,我们经常会遇到缺失值(NaN)。了解如何处理这些缺失值对于获得准确的结果至关重要。

4.1 默认行为

默认情况下,Pandas 在计算平均值时会忽略缺失值:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C'],

'value1': [10, np.nan, 20, 25, 30],

'value2': [100, 150, np.nan, 250, 300]

}

df = pd.DataFrame(data)

# 计算平均值

result = df.groupby('group').mean()

print("Data from pandasdataframe.com:")

print(result)

Output:

在这个例子中,’value1′ 和 ‘value2’ 列都包含缺失值。Pandas 会在计算平均值时自动忽略这些缺失值。

4.2 使用 fillna() 填充缺失值

如果我们想在计算平均值之前填充缺失值,可以使用 fillna() 方法:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'category': ['X', 'X', 'Y', 'Y', 'Z'],

'sales': [1000, np.nan, 2000, 2500, 3000],

'costs': [800, 900, np.nan, 2000, 2500]

}

df = pd.DataFrame(data)

# 填充缺失值后计算平均值

result = df.fillna(df.mean()).groupby('category').mean()

print("Data from pandasdataframe.com:")

print(result)

在这个例子中,我们首先使用整个数据框的平均值填充缺失值,然后再进行分组和计算平均值。

5. 高级 GroupBy 技巧

除了基本的分组和平均值计算,Pandas 还提供了一些高级技巧来处理更复杂的场景。

5.1 多列分组

我们可以使用多个列进行分组:

import pandas as pd

# 创建示例数据

data = {

'department': ['IT', 'HR', 'IT', 'HR', 'IT'],

'level': ['Junior', 'Senior', 'Senior', 'Junior', 'Senior'],

'salary': [5000, 7000, 6000, 4500, 7500],

'bonus': [1000, 1500, 1200, 800, 2000]

}

df = pd.DataFrame(data)

# 按部门和级别分组,计算平均工资和奖金

result = df.groupby(['department', 'level']).mean()

print("Data from pandasdataframe.com:")

print(result)

Output:

这个例子展示了如何按部门和级别进行分组,然后计算每个组的平均工资和奖金。

5.2 使用自定义聚合函数

我们可以使用 agg() 方法应用自定义的聚合函数:

import pandas as pd

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A'],

'sales': [100, 150, 120, 180, 110],

'returns': [5, 8, 6, 10, 7]

}

df = pd.DataFrame(data)

# 定义自定义函数计算净销售额

def net_sales(x):

return x['sales'].sum() - x['returns'].sum()

# 使用自定义函数进行聚合

result = df.groupby('product').agg({

'sales': 'mean',

'returns': 'mean',

'net_sales': net_sales

})

print("Data from pandasdataframe.com:")

print(result)

这个例子展示了如何使用自定义函数 net_sales 来计算每个产品的净销售额,同时计算平均销售额和平均退货量。

6. 处理大型数据集

当处理大型数据集时,性能可能会成为一个问题。以下是一些提高性能的技巧:

6.1 使用 categorical 数据类型

对于分组列,使用 categorical 数据类型可以提高性能:

import pandas as pd

# 创建大型示例数据

data = {

'category': ['A', 'B', 'C'] * 1000000,

'value': range(3000000)

}

df = pd.DataFrame(data)

# 将 category 列转换为 categorical 类型

df['category'] = df['category'].astype('category')

# 计算平均值

result = df.groupby('category').mean()

print("Data from pandasdataframe.com:")

print(result)

这个例子展示了如何将分组列转换为 categorical 类型,这可以显著提高大型数据集的分组性能。

6.2 使用 numba 加速

对于自定义聚合函数,我们可以使用 numba 来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

np.random.seed(0)

data = {

'group': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

}

df = pd.DataFrame(data)

# 使用 numba 加速的自定义函数

@jit(nopython=True)

def custom_mean(x):

return np.mean(x)

# 使用加速后的函数计算平均值

result = df.groupby('group')['value'].agg(custom_mean)

print("Data from pandasdataframe.com:")

print(result)

这个例子展示了如何使用 numba 来加速自定义聚合函数的计算。

7. 处理时间序列数据

在处理时间序列数据时,我们可能需要按时间间隔进行分组和计算平均值。

7.1 按日期分组

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=100, freq='D')

data = {

'date': dates,

'value': np.random.randn(100)

}

df = pd.DataFrame(data)

# 按月分组并计算平均值

result = df.groupby(df['date'].dt.to_period('M'))['value'].mean()

print("Data from pandasdataframe.com:")

print(result)

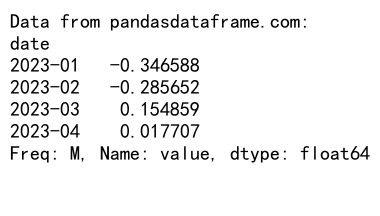

Output:

这个例子展示了如何按月对时间序列数据进行分组并计算平均值。

7.2 使用滚动窗口

对于时间序列数据,我们可能需要计算滚动平均值:

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=100, freq='D')

data = {

'date': dates,

'value': np.random.randn(100)

}

df = pd.DataFrame(data)

df.set_index('date', inplace=True)

# 计算7天滚动平均值

result = df['value'].rolling(window=7).mean()

print("Data from pandasdataframe.com:")

print(result)

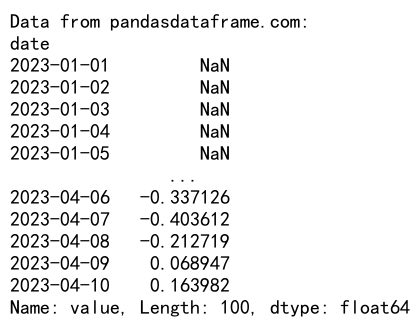

Output:

这个例子展示了如何计算7天滚动平均值。

8. 处理多层索引

GroupBy 操作可能会产生多层索引(MultiIndex)的结果。了解如何处理这种结构很重要。

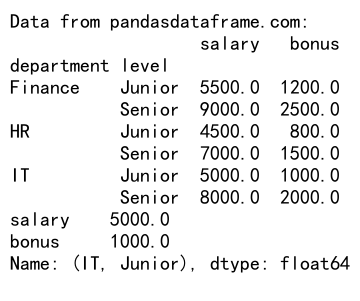

8.1 处理多层索引结果

import pandas as pd

# 创建示例数据

data = {

'department': ['IT', 'IT', 'HR', 'HR', 'Finance', 'Finance'],

'level': ['Junior', 'Senior', 'Junior', 'Senior', 'Junior', 'Senior'],

'salary': [5000, 8000, 4500, 7000, 5500, 9000],

'bonus': [1000, 2000, 800, 1500, 1200, 2500]

}

df = pd.DataFrame(data)

# 按部门和级别分组

result = df.groupby(['department', 'level']).mean()

print("Data from pandasdataframe.com:")

print(result)

# 访问特定组的数据

print(result.loc['IT', 'Junior'])

Output:

这个例子展示了如何处理多层索引的结果,以及如何访问特定组的数据。

8.2 展平多层索引

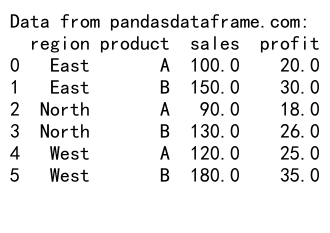

有时我们可能需要将多层索引展平为单层索引:

import pandas as pd

# 创建示例数据

data = {

'region': ['East', 'East', 'West', 'West', 'North', 'North'],

'product': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 150, 120, 180, 90, 130],

'profit': [20, 30, 25, 35, 18, 26]

}

df = pd.DataFrame(data)

# 按地区和产品分组

result = df.groupby(['region', 'product']).mean()

# 展平多层索引

result_flat = result.reset_index()

print("Data from pandasdataframe.com:")

print(result_flat)

Output:

这个例子展示了如何使用 reset_index() 方法将多层索引展平为单层索引。

9. 高级数据分析技巧

除了基本的平均值计算,GroupBy 还可以用于更复杂的数据分析任务。

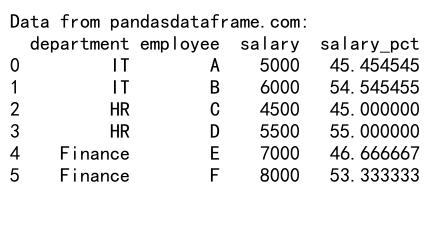

9.1 计算组内百分比

import pandas as pd

# 创建示例数据

data = {

'department': ['IT', 'IT', 'HR', 'HR', 'Finance', 'Finance'],

'employee': ['A', 'B', 'C', 'D', 'E', 'F'],

'salary': [5000, 6000, 4500, 5500, 7000, 8000]

}

df = pd.DataFrame(data)

# 计算每个部门内员工工资占比

df['salary_pct'] = df.groupby('department')['salary'].transform(lambda x: x / x.sum() * 100)

print("Data from pandasdataframe.com:")

print(df)

Output:

这个例子展示了如何计算每个部门内员工工资占该部门总工资的百分比。

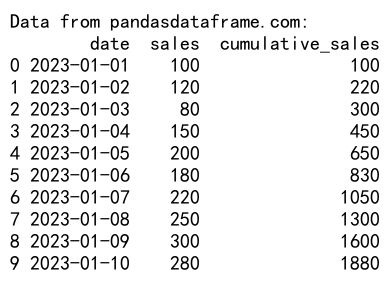

9.2 计算累积和

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range('2023-01-01', periods=10),

'sales': [100, 120, 80, 150, 200, 180, 220, 250, 300, 280]

}

df = pd.DataFrame(data)

# 计算累积销售额

df['cumulative_sales'] = df.groupby(df['date'].dt.to_period('M'))['sales'].cumsum()

print("Data from pandasdataframe.com:")

print(df)

Output:

这个例子展示了如何计算每月的累积销售额。

10. 处理大规模数据的优化技巧

当处理大规模数据时,优化性能变得尤为重要。以下是一些额外的优化技巧:

10.1 使用 Dask 进行并行计算

对于非常大的数据集,我们可以使用 Dask 来进行并行计算:

import pandas as pd

import dask.dataframe as dd

# 创建大型示例数据

data = {

'category': ['A', 'B', 'C'] * 10000000,

'value': range(30000000)

}

df = pd.DataFrame(data)

# 转换为 Dask DataFrame

ddf = dd.from_pandas(df, npartitions=4)

# 使用 Dask 进行分组计算

result = ddf.groupby('category')['value'].mean().compute()

print("Data from pandasdataframe.com:")

print(result)

这个例子展示了如何使用 Dask 来并行处理大规模数据。

10.2 使用 SQL 查询

对于存储在数据库中的大型数据集,直接使用 SQL 查询可能更高效:

import pandas as pd

import sqlite3

# 创建示例数据库

conn = sqlite3.connect(':memory:')

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 1000000,

'value': range(3000000)

})

df.to_sql('data', conn, index=False)

# 使用 SQL 查询计算平均值

query = """

SELECT category, AVG(value) as mean_value

FROM data

GROUP BY category

"""

result = pd.read_sql_query(query, conn)

print("Data from pandasdataframe.com:")

print(result)

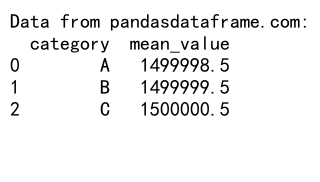

Output:

这个例子展示了如何使用 SQL 查询来计算大型数据集的分组平均值。

结论

Pandas 的 GroupBy 功能和计算所有列平均值的能力为数据分析提供了强大的工具。通过本文介绍的各种技巧和方法,您应该能够处理各种复杂的数据分析任务,从基本的分组计算到处理大规模数据集和时间序列数据。

记住,选择合适的方法取决于您的具体需求和数据特征。对于小型数据集,标准的 Pandas 方法通常就足够了。但对于大型数据集,您可能需要考虑使用 categorical 数据类型、Numba 加速、Dask 并行计算或直接的 SQL 查询等优化技巧。

无论您面对什么样的数据分析挑战,Pandas 的灵活性和强大功能都能帮助您高效地完成任务。继续探索和实践,您将发现更多 Pandas 的强大功能和使用技巧。

极客教程

极客教程