Pandas中使用groupby、agg和count进行高效数据分析

参考:pandas groupby agg count all

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,我们经常需要对数据进行分组、聚合和计数等操作。本文将详细介绍Pandas中的groupby、agg和count函数,以及如何结合使用这些函数来进行高效的数据分析。

1. Pandas中的groupby操作

groupby是Pandas中非常重要的一个功能,它允许我们按照一个或多个列对数据进行分组,然后对每个分组应用各种操作。

1.1 基本的groupby操作

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Alice', 'Bob'],

'age': [25, 30, 35, 40, 25, 31],

'city': ['New York', 'London', 'Paris', 'Tokyo', 'New York', 'London'],

'salary': [50000, 60000, 70000, 80000, 55000, 65000]

}

df = pd.DataFrame(data)

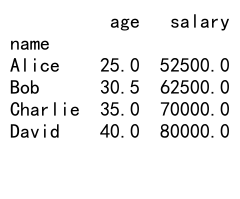

# 按name分组并计算平均年龄和工资

grouped = df.groupby('name').agg({'age': 'mean', 'salary': 'mean'})

print(grouped)

Output:

在这个例子中,我们首先创建了一个包含姓名、年龄、城市和工资信息的DataFrame。然后,我们使用groupby('name')按姓名分组,并使用agg函数计算每个人的平均年龄和工资。

1.2 多列分组

我们也可以按多个列进行分组:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Alice', 'Bob'],

'department': ['HR', 'IT', 'Finance', 'IT', 'HR', 'IT'],

'salary': [50000, 60000, 70000, 80000, 55000, 65000]

}

df = pd.DataFrame(data)

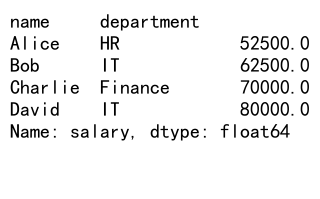

# 按name和department分组,计算平均工资

grouped = df.groupby(['name', 'department'])['salary'].mean()

print(grouped)

Output:

这个例子展示了如何按姓名和部门进行分组,然后计算每个组的平均工资。

2. 使用agg函数进行聚合

agg函数是一个强大的工具,它允许我们对分组后的数据应用多种聚合操作。

2.1 使用内置聚合函数

Pandas提供了许多内置的聚合函数,如mean、sum、count等:

import pandas as pd

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 200, 150, 250, 180, 220],

'quantity': [10, 15, 12, 18, 14, 16]

}

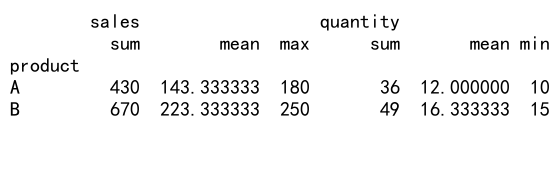

df = pd.DataFrame(data)

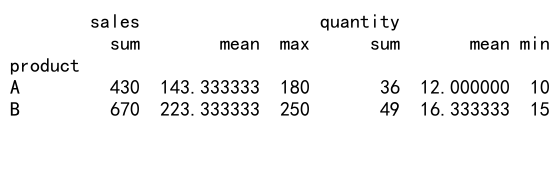

# 使用多个聚合函数

result = df.groupby('product').agg({

'sales': ['sum', 'mean', 'max'],

'quantity': ['sum', 'mean', 'min']

})

print(result)

Output:

在这个例子中,我们对sales列应用了sum、mean和max函数,对quantity列应用了sum、mean和min函数。

2.2 使用自定义聚合函数

除了内置函数,我们还可以使用自定义函数进行聚合:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 200, 150, 250, 180, 220]

}

df = pd.DataFrame(data)

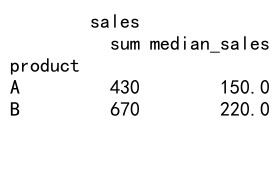

# 自定义函数:计算销售额的中位数

def median_sales(x):

return np.median(x)

# 使用自定义函数进行聚合

result = df.groupby('product').agg({

'sales': ['sum', median_sales]

})

print(result)

Output:

这个例子展示了如何使用自定义函数median_sales来计算每个产品的销售额中位数。

3. count函数的使用

count函数用于计算非空值的数量,它在数据分析中经常被用来检查数据完整性或进行简单的统计。

3.1 基本的count使用

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Alice', 'Bob'],

'age': [25, 30, None, 40, 25, 31],

'city': ['New York', 'London', 'Paris', None, 'New York', 'London']

}

df = pd.DataFrame(data)

# 计算每列非空值的数量

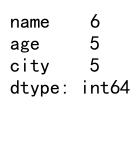

counts = df.count()

print(counts)

Output:

这个例子展示了如何使用count函数计算DataFrame中每列非空值的数量。

3.2 结合groupby使用count

count函数经常与groupby一起使用,用于计算每个组中的记录数:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'B', 'A', 'B', 'A'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

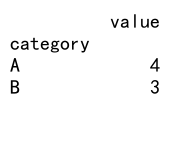

df = pd.DataFrame(data)

# 计算每个类别的记录数

category_counts = df.groupby('category').count()

print(category_counts)

Output:

这个例子展示了如何计算每个类别的记录数。

4. 高级groupby技巧

4.1 使用多个聚合函数

我们可以在一个groupby操作中使用多个聚合函数:

import pandas as pd

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 200, 150, 250, 180, 220],

'quantity': [10, 15, 12, 18, 14, 16]

}

df = pd.DataFrame(data)

# 使用多个聚合函数

result = df.groupby('product').agg({

'sales': ['sum', 'mean', 'max'],

'quantity': ['sum', 'mean', 'min']

})

print(result)

Output:

这个例子展示了如何对不同的列应用不同的聚合函数。

4.2 使用transform函数

transform函数允许我们在保持原始DataFrame结构的同时应用聚合操作:

import pandas as pd

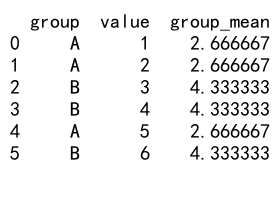

# 创建示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'A', 'B'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 使用transform计算每个组的平均值

df['group_mean'] = df.groupby('group')['value'].transform('mean')

print(df)

Output:

这个例子展示了如何使用transform函数计算每个组的平均值,并将结果添加为新列。

5. 处理时间序列数据

groupby和agg函数在处理时间序列数据时特别有用:

import pandas as pd

import numpy as np

# 创建示例时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'sales': np.random.randint(100, 1000, size=len(dates))

}

df = pd.DataFrame(data)

# 按月份分组并计算每月总销售额

monthly_sales = df.groupby(df['date'].dt.to_period('M'))['sales'].sum()

print(monthly_sales)

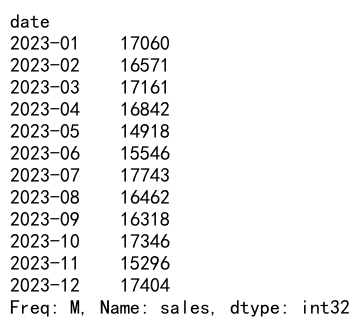

Output:

这个例子展示了如何按月份对销售数据进行分组,并计算每月的总销售额。

6. 处理分类数据

对于分类数据,我们可以使用groupby和agg函数进行各种统计分析:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'C', 'A', 'B', 'C', 'A', 'B', 'C'],

'subcategory': ['X', 'Y', 'Z', 'X', 'Y', 'Z', 'X', 'Y', 'Z'],

'value': [1, 2, 3, 4, 5, 6, 7, 8, 9]

}

df = pd.DataFrame(data)

# 按category和subcategory分组,计算平均值和总和

result = df.groupby(['category', 'subcategory']).agg({

'value': ['mean', 'sum']

})

print(result)

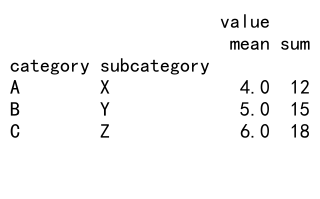

Output:

这个例子展示了如何对分类数据进行多级分组,并计算每个组的平均值和总和。

7. 使用filter函数

filter函数允许我们根据某些条件筛选分组:

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C', 'C'],

'value': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 筛选出平均值大于3的组

filtered = df.groupby('group').filter(lambda x: x['value'].mean() > 3)

print(filtered)

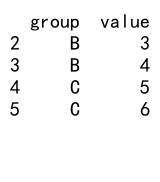

Output:

这个例子展示了如何使用filter函数筛选出平均值大于3的组。

8. 使用apply函数

apply函数允许我们对每个分组应用自定义函数:

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C', 'C'],

'value1': [1, 2, 3, 4, 5, 6],

'value2': [10, 20, 30, 40, 50, 60]

}

df = pd.DataFrame(data)

# 自定义函数:计算value1和value2的比率

def calculate_ratio(group):

return pd.Series({

'ratio': group['value1'].sum() / group['value2'].sum()

})

# 应用自定义函数

result = df.groupby('group').apply(calculate_ratio)

print(result)

这个例子展示了如何使用apply函数对每个分组应用自定义函数,计算value1和value2的比率。

9. 处理缺失值

在进行groupby操作时,我们经常需要处理缺失值:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C', 'C'],

'value': [1, np.nan, 3, 4, np.nan, 6]

}

df = pd.DataFrame(data)

# 计算每个组的平均值,忽略缺失值

result = df.groupby('group')['value'].mean()

print(result)

# 使用fillna填充缺失值后再计算平均值

df['value_filled'] = df.groupby('group')['value'].transform(lambda x: x.fillna(x.mean()))

result_filled = df.groupby('group')['value_filled'].mean()

print(result_filled)

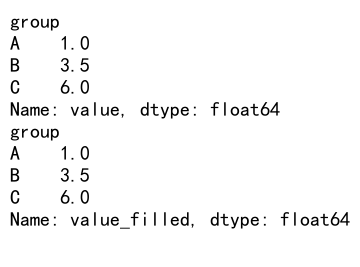

Output:

这个例子展示了如何在存在缺失值的情况下计算每个组的平均值,以及如何使用fillna函数填充缺失值。

10. 高级聚合技巧

10.1 使用named aggregation

Pandas 0.25.0版本引入了named aggregation,它提供了一种更清晰的方式来指定聚合操作:

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C', 'C'],

'value1': [1, 2, 3, 4, 5, 6],

'value2': [10, 20, 30, 40, 50, 60]

}

df = pd.DataFrame(data)

# 使用named aggregation

result = df.groupby('group').agg(

value1_mean=('value1', 'mean'),

value1_sum=('value1', 'sum'),

value2_max=('value2', 'max')

)

print(result)

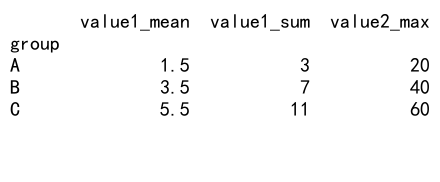

Output:

这个例子展示了如何使用named aggregation来指定聚合操作,使结果更易读和理解。

10.2 使用groupby和agg进行复杂计算

我们可以结合groupby和agg函数进行更复杂的计算:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'category': np.random.choice(['A', 'B', 'C'], size=365),

'sales': np.random.randint(100, 1000, size=365),

'quantity': np.random.randint(10, 100, size=365)

}

df = pd.DataFrame(data)

# 复杂的聚合操作

result = df.groupby([df['date'].dt.month, 'category']).agg({

'sales': ['sum', 'mean', lambda x: x.max() - x.min()],

'quantity': ['sum', 'mean', lambda x: x.quantile(0.75)]

}).reset_index()

# 重命名列

result.columns= ['month', 'category', 'sales_sum', 'sales_mean', 'sales_range', 'quantity_sum', 'quantity_mean', 'quantity_75th']

print(result)

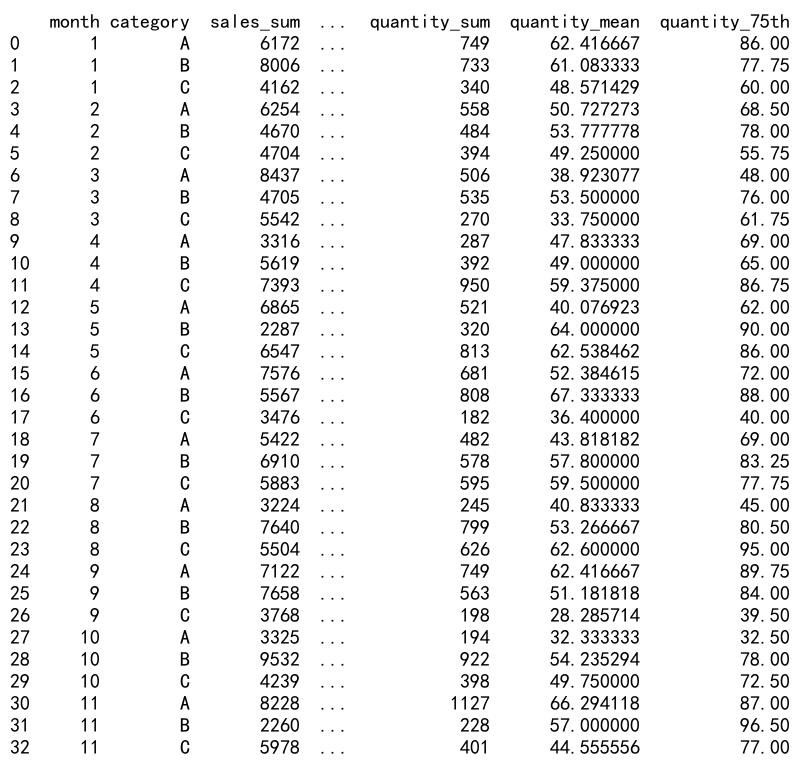

Output:

这个例子展示了如何进行复杂的聚合操作,包括自定义函数和多级索引的处理。

11. 性能优化技巧

在处理大型数据集时,groupby操作可能会变得很慢。以下是一些优化性能的技巧:

11.1 使用categoricals

对于包含重复值的列,将其转换为categorical类型可以显著提高groupby的性能:

import pandas as pd

import numpy as np

# 创建大型示例数据

n = 1000000

data = {

'group': np.random.choice(['A', 'B', 'C', 'D', 'E'], size=n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 将group列转换为categorical类型

df['group'] = df['group'].astype('category')

# 执行groupby操作

result = df.groupby('group')['value'].mean()

print(result)

这个例子展示了如何将分组列转换为categorical类型以提高性能。

11.2 使用numba加速

对于自定义聚合函数,我们可以使用numba来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

n = 1000000

data = {

'group': np.random.choice(['A', 'B', 'C', 'D', 'E'], size=n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 使用numba加速的自定义函数

@jit(nopython=True)

def custom_agg(values):

return np.mean(values) * np.std(values)

# 应用加速后的函数

result = df.groupby('group')['value'].agg(custom_agg)

print(result)

这个例子展示了如何使用numba来加速自定义聚合函数。

12. 处理多层索引

groupby操作经常会产生多层索引,我们需要学会如何处理这种结构:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'category': np.random.choice(['A', 'B', 'C'], size=365),

'subcategory': np.random.choice(['X', 'Y', 'Z'], size=365),

'sales': np.random.randint(100, 1000, size=365)

}

df = pd.DataFrame(data)

# 多层分组

result = df.groupby([df['date'].dt.month, 'category', 'subcategory'])['sales'].sum().unstack(level=[1, 2])

print(result)

# 访问特定组

print(result.loc[1, ('A', 'X')])

# 重置索引

result_reset = result.reset_index()

print(result_reset)

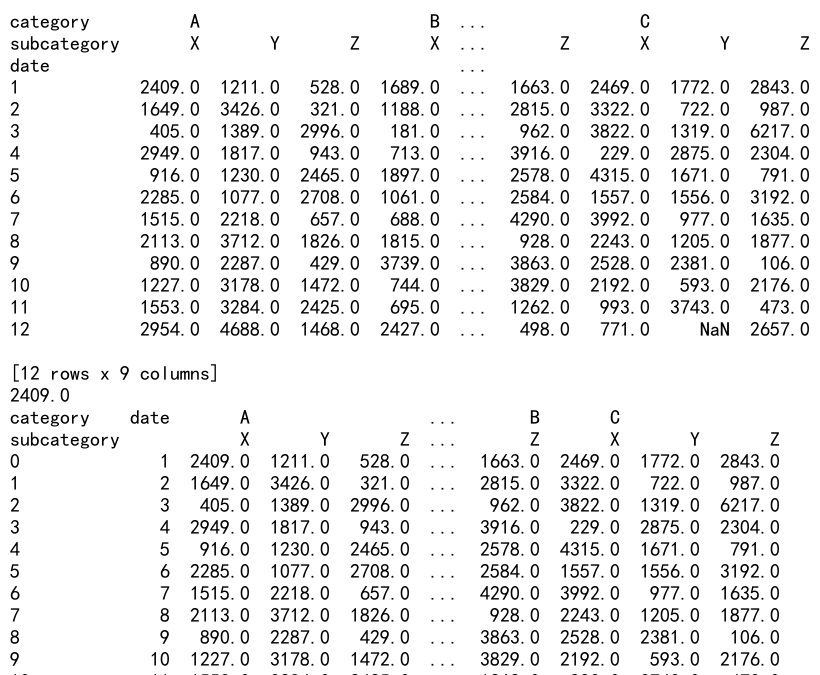

Output:

这个例子展示了如何创建、访问和重置多层索引。

13. 使用groupby进行时间序列分析

groupby函数在时间序列分析中非常有用:

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'sales': np.random.randint(100, 1000, size=len(dates))

}

df = pd.DataFrame(data)

# 按周分组并计算平均销售额

weekly_sales = df.groupby(df['date'].dt.isocalendar().week)['sales'].mean()

print(weekly_sales)

# 计算7天移动平均

df['7d_moving_avg'] = df.groupby(df['date'].dt.dayofweek)['sales'].transform(lambda x: x.rolling(7, min_periods=1).mean())

print(df.head(10))

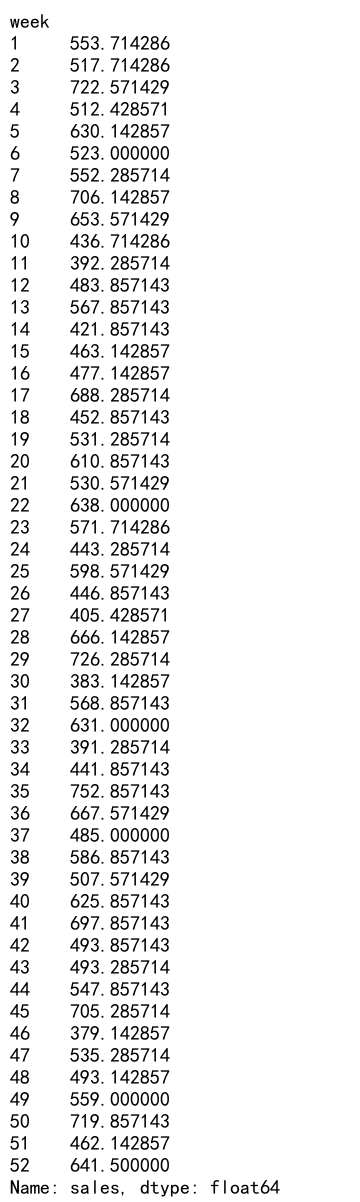

Output:

这个例子展示了如何使用groupby进行基本的时间序列分析,包括按周分组和计算移动平均。

14. 使用groupby进行数据透视

groupby和pivot_table函数可以结合使用来创建数据透视表:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'product': np.random.choice(['A', 'B', 'C'], size=365),

'region': np.random.choice(['North', 'South', 'East', 'West'], size=365),

'sales': np.random.randint(100, 1000, size=365)

}

df = pd.DataFrame(data)

# 创建数据透视表

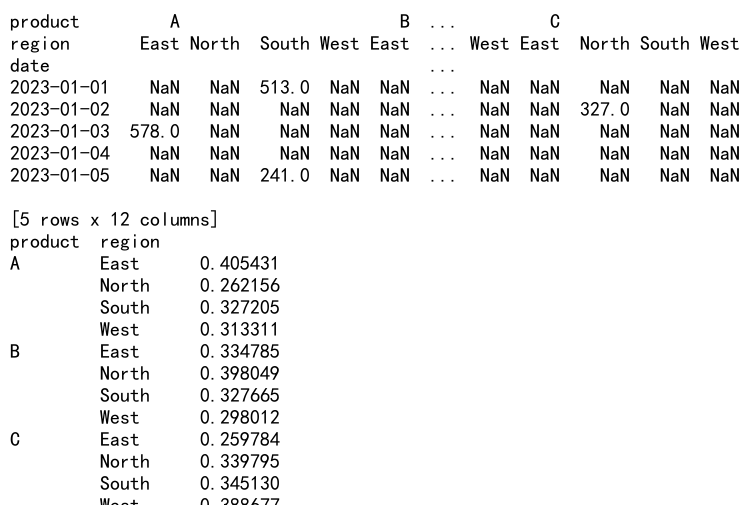

pivot = pd.pivot_table(df, values='sales', index=['date'], columns=['product', 'region'], aggfunc='sum')

print(pivot.head())

# 计算每个产品在每个地区的市场份额

market_share = df.groupby(['product', 'region'])['sales'].sum() / df.groupby('region')['sales'].sum()

print(market_share)

Output:

这个例子展示了如何使用pivot_table创建数据透视表,以及如何使用groupby计算市场份额。

15. 使用groupby进行数据规范化

groupby可以用于数据规范化,例如计算z-score或百分比排名:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'group': np.repeat(['A', 'B', 'C'], 100),

'value': np.random.randn(300)

}

df = pd.DataFrame(data)

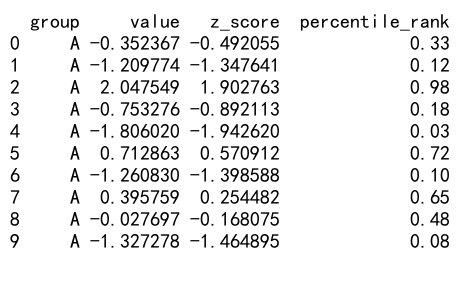

# 计算每个组内的z-score

df['z_score'] = df.groupby('group')['value'].transform(lambda x: (x - x.mean()) / x.std())

# 计算每个组内的百分比排名

df['percentile_rank'] = df.groupby('group')['value'].transform(lambda x: x.rank(pct=True))

print(df.head(10))

Output:

这个例子展示了如何使用groupby进行数据规范化,包括计算z-score和百分比排名。

结论

Pandas中的groupby、agg和count函数是进行数据分析的强大工具。通过本文的详细介绍和丰富的示例,我们了解了这些函数的基本用法和高级技巧。从简单的分组统计到复杂的时间序列分析,从数据透视到性能优化,这些函数为我们提供了灵活而高效的数据处理方法。

在实际的数据分析项目中,我们常常需要结合使用这些函数来解决复杂的问题。通过熟练掌握这些技巧,我们可以更好地理解数据,发现隐藏的模式,并做出数据驱动的决策。

随着数据量的不断增长和分析需求的日益复杂,掌握这些高级数据处理技巧变得越来越重要。希望本文能够帮助读者更好地理解和应用Pandas中的这些强大功能,从而在数据分析工作中游刃有余。

极客教程

极客教程