R语言 简单回归方程估计

在R编程语言中,lm()函数可以用来估计一个简单的线性回归方程。该函数需要两个参数:自变量和因变量。

估计的简单线性回归和简单线性回归的区别 。

简单线性回归是一种用于建立单一因变量(也称为结果)和一个或多个自变量(也称为预测变量或解释变量)之间模型关系的方法。该模型由以下形式的方程表示。

y = a + b x

估计的简单线性回归与简单线性回归相同,但区别在于估计的系数。我们使用样本数据来估计模型的参数。估计的系数是使样本数据的平方误差之和最小的a和b的值。估计的简单线性回归模型由以下形式的方程表示。

y = a' + b' x

其中a’和b’是估计值。这些值被用来寻找直线的最佳拟合,并减少平方误差之和。

计算公式 。

误差平方和=Σ(yi-(a+b*xi))^2

其中yi和xi分别是y和x的实际值,yi’, a + bxi是y的预测值。

语法

lm(y ~ x)

y = 数据向量,包含 独立值。

x = 包含自变量的数据向量。

# create data

x <- c(1, 2, 4, 7, 11)

y <- c(2, 7, 9, 10, 13)

# estimate linear regression equation

model <- lm(y ~ x)

model

输出

Call:

lm(formula = y ~ x)

Coefficients:

(Intercept) x

3.6545 0.9091

输出形式 。

代码的输出是通过简单的线性回归方程来估计的,其形式是。

y = b0 + b1 * x

y = 预测值或函数。

b0 = 截距

b1 = 系数

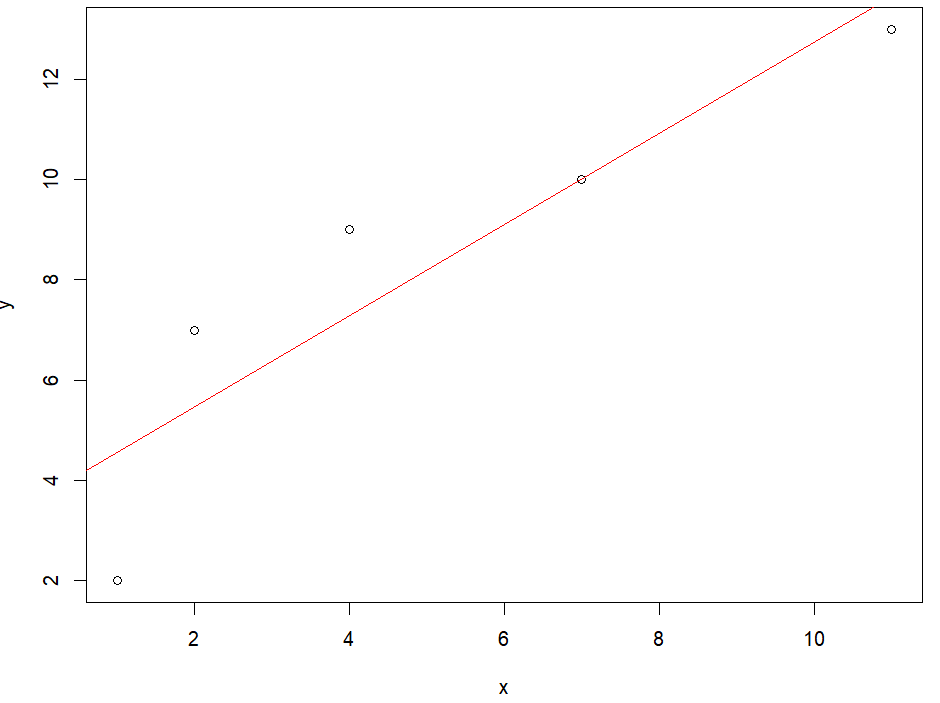

绘制线性回归线的二维平面图

现在让我们在二维平面上画出这些点,然后在同一平面上画出回归线,这将有助于我们分析估计的线性回归在多大程度上适合我们的数据。

# create data

x <- c(1, 2, 4, 7, 11)

y <- c(2, 7, 9, 10, 13)

# fit a linear regression model

fit <- lm(y ~ x)

# create a scatter plot of the data

plot(x, y)

# add the regression line to the plot

abline(fit, col = "red")

输出

散点图和回归线

现在让我们来看看模型的系数,它是在训练过程后确定的。

# printing coefficent.

coef(model)

输出

(Intercept) x

3.6545455 0.9090909

现在让我们尝试预测一个随机数据点的值,并使用估计的简单线性回归方程得到因果或目标特征的值。

# new data point

new_data <- 7

# wraping the datapoint and calling predict function.

prediction <- predict(model,

newdata = data.frame(x = new_data))

# printing prediction

print(prediction)

输出

10.01818

极客教程

极客教程