Pandas中使用Groupby和Timedelta进行时间序列数据分析

在数据分析和处理中,Pandas库是一个强大而灵活的工具。本文将深入探讨Pandas中Groupby和Timedelta的使用,特别是在时间序列数据分析中的应用。我们将通过详细的解释和实际的代码示例,帮助您更好地理解和运用这些功能。

1. Pandas Groupby简介

Groupby是Pandas中一个非常重要的功能,它允许我们根据某些条件将数据分组,然后对每个组应用特定的操作。这在处理大量数据时特别有用,可以帮助我们快速地进行数据汇总和分析。

1.1 基本用法

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'date': ['2023-01-01', '2023-01-01', '2023-01-02', '2023-01-02', '2023-01-03'],

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 15, 12, 18, 14]

}

df = pd.DataFrame(data)

df['date'] = pd.to_datetime(df['date'])

# 使用groupby按日期分组并计算每天的平均值

result = df.groupby('date')['value'].mean()

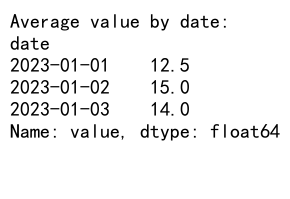

print("Average value by date:")

print(result)

Output:

在这个例子中,我们创建了一个包含日期、类别和值的DataFrame。然后,我们使用groupby('date')按日期分组,并计算每天的平均值。这个简单的操作展示了groupby的基本用法。

1.2 多列分组

Groupby不仅可以按单个列分组,还可以按多个列进行分组:

import pandas as pd

# 创建示例数据

data = {

'date': ['2023-01-01', '2023-01-01', '2023-01-02', '2023-01-02', '2023-01-03'],

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 15, 12, 18, 14],

'website': ['pandasdataframe.com'] * 5

}

df = pd.DataFrame(data)

df['date'] = pd.to_datetime(df['date'])

# 按日期和类别分组,计算每组的平均值

result = df.groupby(['date', 'category'])['value'].mean()

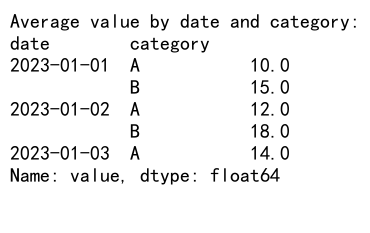

print("Average value by date and category:")

print(result)

Output:

在这个例子中,我们按日期和类别两个列进行分组。这样可以得到更细粒度的分组结果,比如每天每个类别的平均值。

1.3 聚合函数

Groupby操作通常与聚合函数一起使用。Pandas提供了多种内置的聚合函数,如sum()、mean()、count()等。我们也可以使用自定义的聚合函数:

import pandas as pd

# 创建示例数据

data = {

'date': ['2023-01-01', '2023-01-01', '2023-01-02', '2023-01-02', '2023-01-03'],

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 15, 12, 18, 14],

'website': ['pandasdataframe.com'] * 5

}

df = pd.DataFrame(data)

df['date'] = pd.to_datetime(df['date'])

# 使用多个聚合函数

result = df.groupby('date').agg({

'value': ['mean', 'sum', 'count'],

'category': 'nunique'

})

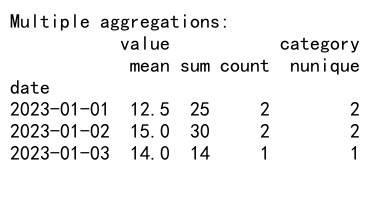

print("Multiple aggregations:")

print(result)

Output:

这个例子展示了如何在一个groupby操作中使用多个聚合函数。我们计算了每天的平均值、总和、计数,以及不同类别的数量。

2. Pandas Timedelta介绍

Timedelta是Pandas中用于表示时间差的数据类型。它可以用来进行时间相关的计算,比如计算两个日期之间的差异,或者在日期上加减一定的时间。

2.1 创建Timedelta

有多种方式可以创建Timedelta对象:

import pandas as pd

# 创建Timedelta

td1 = pd.Timedelta(days=1, hours=2, minutes=30)

td2 = pd.Timedelta('1 day 2 hours 30 minutes')

td3 = pd.Timedelta('1d 2h 30min')

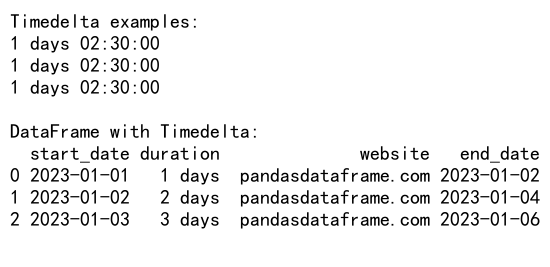

print("Timedelta examples:")

print(td1)

print(td2)

print(td3)

# 在DataFrame中使用Timedelta

df = pd.DataFrame({

'start_date': ['2023-01-01', '2023-01-02', '2023-01-03'],

'duration': ['1d', '2d', '3d'],

'website': ['pandasdataframe.com'] * 3

})

df['start_date'] = pd.to_datetime(df['start_date'])

df['duration'] = pd.to_timedelta(df['duration'])

df['end_date'] = df['start_date'] + df['duration']

print("\nDataFrame with Timedelta:")

print(df)

Output:

这个例子展示了创建Timedelta的不同方法,以及如何在DataFrame中使用Timedelta进行日期计算。

2.2 Timedelta运算

Timedelta支持各种算术运算,可以很方便地进行时间的加减:

import pandas as pd

# 创建示例数据

df = pd.DataFrame({

'date': ['2023-01-01', '2023-01-02', '2023-01-03'],

'value': [10, 15, 20],

'website': ['pandasdataframe.com'] * 3

})

df['date'] = pd.to_datetime(df['date'])

# 添加1天

df['next_day'] = df['date'] + pd.Timedelta(days=1)

# 减去12小时

df['previous_12h'] = df['date'] - pd.Timedelta(hours=12)

# 添加自定义时间

df['custom_time'] = df['date'] + pd.to_timedelta(df['value'], unit='h')

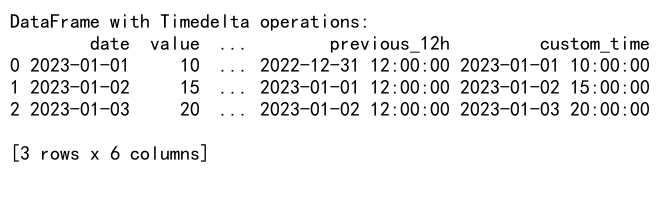

print("DataFrame with Timedelta operations:")

print(df)

Output:

这个例子展示了如何使用Timedelta进行日期的加减运算,包括添加固定时间和基于DataFrame中的值进行动态时间调整。

3. 结合Groupby和Timedelta进行时间序列分析

现在,让我们看看如何结合Groupby和Timedelta来进行更复杂的时间序列数据分析。

3.1 按时间间隔分组

一个常见的需求是按特定的时间间隔对数据进行分组:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-01-31', freq='D')

df = pd.DataFrame({

'date': dates,

'value': range(len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 按周分组

weekly_groups = df.groupby(pd.Grouper(key='date', freq='W'))

weekly_sum = weekly_groups['value'].sum()

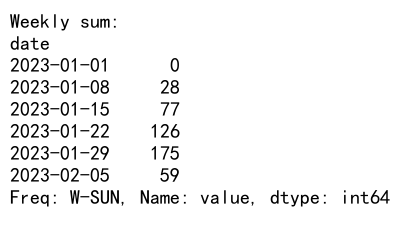

print("Weekly sum:")

print(weekly_sum)

Output:

这个例子展示了如何使用pd.Grouper按周对数据进行分组。我们可以轻松地更改频率,比如改为’M’来按月分组,或’D’来按天分组。

3.2 滚动时间窗口分析

滚动时间窗口分析是时间序列数据处理中的一个重要概念:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-01-31', freq='D')

df = pd.DataFrame({

'date': dates,

'value': range(len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

df.set_index('date', inplace=True)

# 7天滚动平均

rolling_mean = df['value'].rolling(window='7D').mean()

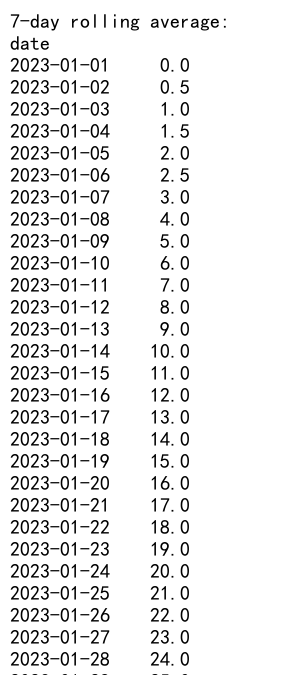

print("7-day rolling average:")

print(rolling_mean)

Output:

这个例子计算了7天的滚动平均值。滚动窗口分析可以帮助我们发现数据中的趋势和模式。

3.3 时间差分析

使用Timedelta可以帮助我们分析事件之间的时间差:

import pandas as pd

# 创建示例数据

data = {

'event': ['A', 'B', 'A', 'B', 'A'],

'timestamp': ['2023-01-01 10:00:00', '2023-01-01 11:30:00',

'2023-01-02 09:15:00', '2023-01-02 14:45:00',

'2023-01-03 08:30:00'],

'website': ['pandasdataframe.com'] * 5

}

df = pd.DataFrame(data)

df['timestamp'] = pd.to_datetime(df['timestamp'])

# 计算每个事件类型的时间差

df = df.sort_values('timestamp')

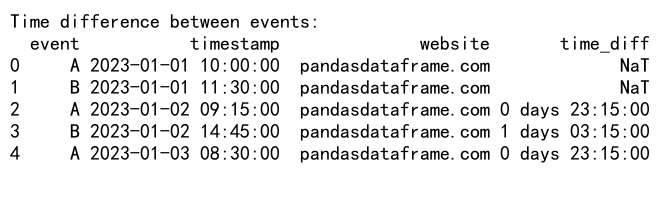

df['time_diff'] = df.groupby('event')['timestamp'].diff()

print("Time difference between events:")

print(df)

Output:

这个例子展示了如何计算同一类型事件之间的时间差。这种分析在研究事件频率和模式时非常有用。

3.4 时间区间分组

有时我们需要将时间分成自定义的区间进行分析:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-01-31', freq='H')

df = pd.DataFrame({

'timestamp': dates,

'value': range(len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 定义时间区间

def time_of_day(hour):

if 6 <= hour < 12:

return 'Morning'

elif 12 <= hour < 18:

return 'Afternoon'

elif 18 <= hour < 22:

return 'Evening'

else:

return 'Night'

# 按时间区间分组

df['time_period'] = df['timestamp'].dt.hour.map(time_of_day)

result = df.groupby('time_period')['value'].mean()

print("Average value by time of day:")

print(result)

这个例子展示了如何将一天分成不同的时间段,并按这些时间段对数据进行分组分析。

3.5 时间序列重采样

重采样是时间序列分析中的一个重要概念,它允许我们改变数据的频率:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-01-31', freq='H')

df = pd.DataFrame({

'timestamp': dates,

'value': range(len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

df.set_index('timestamp', inplace=True)

# 按天重采样

daily_sum = df.resample('D')['value'].sum()

print("Daily sum after resampling:")

print(daily_sum)

这个例子展示了如何将小时级别的数据重采样为每日汇总。重采样可以帮助我们在不同时间尺度上分析数据。

4. 高级应用

现在,让我们看一些更高级的应用,结合Groupby和Timedelta来解决复杂的时间序列分析问题。

4.1 连续时间段分析

有时我们需要分析连续的时间段,比如连续工作日或连续活跃天数:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-01-31', freq='D')

df = pd.DataFrame({

'date': dates,

'active': [1, 1, 1, 0, 0, 1, 1, 1, 1, 0] * 3 + [1],

'website': ['pandasdataframe.com'] * len(dates)

})

# 计算连续活跃天数

df['active_group'] = (df['active'] != df['active'].shift()).cumsum()

consecutive_days = df[df['active'] == 1].groupby('active_group')['date'].agg(['count', 'min', 'max'])

consecutive_days['duration'] = consecutive_days['max'] - consecutive_days['min'] + pd.Timedelta(days=1)

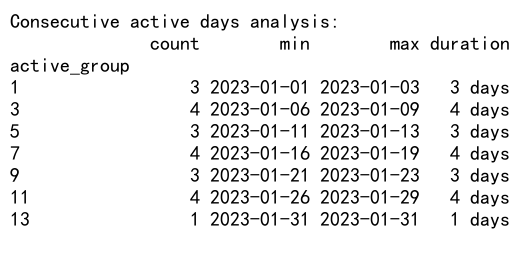

print("Consecutive active days analysis:")

print(consecutive_days)

Output:

这个例子展示了如何分析连续活跃的时间段。我们首先标记了每个连续活跃期,然后计算了每个期间的持续时间和天数。

4.2 时间窗口累积统计

在某些情况下,我们可能需要计算滚动时间窗口内的累积统计:

import pandas as pd

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-01-31', freq='D')

df = pd.DataFrame({

'date': dates,

'value': range(len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

df.set_index('date', inplace=True)

# 计算7天滚动窗口内的累积和

df['7d_cumsum'] = df['value'].rolling('7D').sum()

# 计算30天滚动窗口内的累积平均

df['30d_cummean'] = df['value'].rolling('30D').mean()

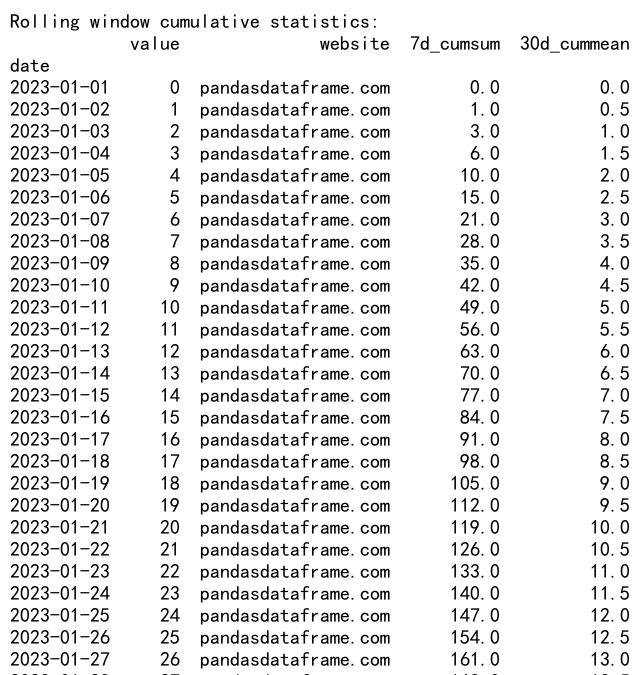

print("Rolling window cumulative statistics:")

print(df)

Output:

这个例子展示了如何计算滚动时间窗口内的累积统计。我们计算了7天滚动窗口的累积和和30天滚动窗口的累积平均值。这种分析对于识别长期趋势和季节性模式非常有用。

4.3 时间间隔分布分析

分析事件之间的时间间隔分布可以帮助我们理解事件的发生模式:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

events = np.random.choice(dates, size=100, replace=False)

df = pd.DataFrame({

'event_date': pd.to_datetime(sorted(events)),

'website': ['pandasdataframe.com'] * 100

})

# 计算事件之间的时间间隔

df['time_interval'] = df['event_date'].diff()

# 分析时间间隔的分布

interval_stats = df['time_interval'].describe()

interval_distribution = df['time_interval'].value_counts().sort_index()

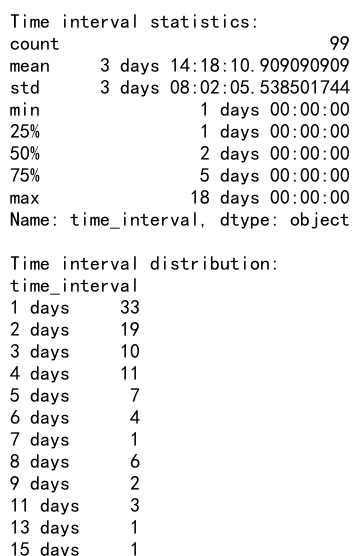

print("Time interval statistics:")

print(interval_stats)

print("\nTime interval distribution:")

print(interval_distribution)

Output:

这个例子展示了如何分析事件之间的时间间隔分布。我们首先计算了相邻事件之间的时间差,然后对这些时间差进行了统计分析和分布分析。这种分析可以帮助我们理解事件的发生频率和规律。

4.4 周期性分析

许多时间序列数据具有周期性特征,比如每周或每月的模式:

import pandas as pd

import numpy as np

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

df = pd.DataFrame({

'date': dates,

'value': np.sin(np.arange(len(dates)) * 2 * np.pi / 7) + np.random.normal(0, 0.1, len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 提取周几和月份信息

df['weekday'] = df['date'].dt.dayofweek

df['month'] = df['date'].dt.month

# 按周几分组分析

weekday_analysis = df.groupby('weekday')['value'].agg(['mean', 'std'])

# 按月份分组分析

month_analysis = df.groupby('month')['value'].agg(['mean', 'std'])

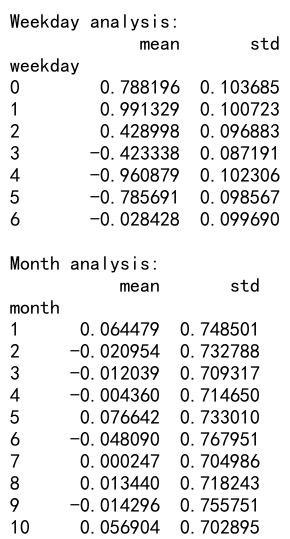

print("Weekday analysis:")

print(weekday_analysis)

print("\nMonth analysis:")

print(month_analysis)

Output:

这个例子展示了如何分析数据的周期性特征。我们创建了一个具有每周周期性的模拟数据集,然后分别按周几和月份进行了分组分析。这种分析可以帮助我们发现数据中的周期性模式。

4.5 时间序列分解

时间序列分解是一种将时间序列数据分解为趋势、季节性和残差成分的技术:

import pandas as pd

from statsmodels.tsa.seasonal import seasonal_decompose

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

df = pd.DataFrame({

'date': dates,

'value': np.sin(np.arange(len(dates)) * 2 * np.pi / 365) * 10 + np.arange(len(dates)) * 0.05 + np.random.normal(0, 1, len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

df.set_index('date', inplace=True)

# 进行时间序列分解

result = seasonal_decompose(df['value'], model='additive', period=365)

# 创建包含分解结果的DataFrame

decomposed = pd.DataFrame({

'observed': result.observed,

'trend': result.trend,

'seasonal': result.seasonal,

'residual': result.resid

})

print("Time series decomposition:")

print(decomposed.head())

这个例子展示了如何使用statsmodels库进行时间序列分解。我们创建了一个包含趋势和季节性成分的模拟数据集,然后将其分解为趋势、季节性和残差成分。这种分析可以帮助我们更好地理解时间序列数据的各个组成部分。

5. 性能优化和最佳实践

在处理大型时间序列数据集时,性能优化变得尤为重要。以下是一些提高Pandas中Groupby和Timedelta操作效率的技巧和最佳实践。

5.1 使用适当的数据类型

确保使用正确的数据类型可以显著提高性能:

import pandas as pd

import numpy as np

# 创建大型示例数据集

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='H')

df = pd.DataFrame({

'timestamp': dates,

'value': np.random.randn(len(dates)),

'category': np.random.choice(['A', 'B', 'C'], size=len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 优化数据类型

df['timestamp'] = pd.to_datetime(df['timestamp'])

df['category'] = df['category'].astype('category')

print("DataFrame info after optimization:")

df.info()

在这个例子中,我们将时间戳列转换为datetime类型,将类别列转换为category类型。这可以减少内存使用并提高某些操作的速度。

5.2 使用索引进行分组操作

当进行频繁的分组操作时,使用索引可以提高性能:

import pandas as pd

import numpy as np

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

df = pd.DataFrame({

'date': dates,

'value': np.random.randn(len(dates)),

'category': np.random.choice(['A', 'B', 'C'], size=len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 设置索引

df.set_index(['date', 'category'], inplace=True)

# 使用索引进行分组操作

result = df.groupby(level=['date', 'category'])['value'].mean()

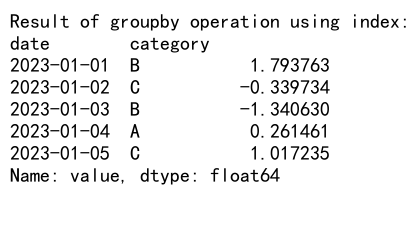

print("Result of groupby operation using index:")

print(result.head())

Output:

通过将分组列设置为索引,我们可以加速groupby操作,特别是在处理大型数据集时。

5.3 使用分块处理大型数据集

当处理非常大的数据集时,可以考虑使用分块处理:

import pandas as pd

import numpy as np

# 创建大型示例数据集

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='H')

df = pd.DataFrame({

'timestamp': dates,

'value': np.random.randn(len(dates)),

'category': np.random.choice(['A', 'B', 'C'], size=len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 分块处理

chunk_size = 1000000

results = []

for chunk in pd.read_csv('large_file.csv', chunksize=chunk_size):

# 对每个块进行处理

chunk_result = chunk.groupby('category')['value'].mean()

results.append(chunk_result)

# 合并结果

final_result = pd.concat(results).groupby(level=0).mean()

print("Final result after chunk processing:")

print(final_result)

这个例子展示了如何使用分块处理大型CSV文件。我们逐块读取数据,对每个块进行处理,然后合并结果。这种方法可以有效减少内存使用。

5.4 利用并行处理

对于某些操作,可以利用并行处理来提高性能:

import pandas as pd

import numpy as np

from pandarallel import pandarallel

# 初始化并行处理

pandarallel.initialize()

# 创建示例数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='H')

df = pd.DataFrame({

'timestamp': dates,

'value': np.random.randn(len(dates)),

'category': np.random.choice(['A', 'B', 'C'], size=len(dates)),

'website': ['pandasdataframe.com'] * len(dates)

})

# 定义一个耗时的操作

def complex_operation(group):

# 模拟复杂计算

return group['value'].mean() * np.sin(group['value'].sum())

# 使用并行处理

result = df.groupby('category').parallel_apply(complex_operation)

print("Result of parallel processing:")

print(result)

这个例子使用pandarallel库来并行化groupby操作。对于计算密集型的操作,这可以显著提高处理速度。

6. 结论

Pandas中的Groupby和Timedelta功能为时间序列数据分析提供了强大的工具。通过本文的详细介绍和实例,我们探讨了如何有效地使用这些功能来处理和分析时间相关的数据。从基本的分组操作到复杂的时间序列分析,这些技术可以应用于各种实际场景,如金融数据分析、用户行为研究、传感器数据处理等。

重要的是要记住,在处理大型数据集时,性能优化变得尤为重要。使用适当的数据类型、索引、分块处理和并行计算等技术可以显著提高数据处理的效率。

随着数据分析领域的不断发展,掌握这些技能将使您能够更有效地处理和理解复杂的时间序列数据。继续探索和实践这些技术,将帮助您在数据分析领域取得更大的成功。

极客教程

极客教程