Pandas GroupBy Sum:高效数据分组与汇总技巧

Pandas是Python中强大的数据处理库,其中GroupBy和Sum操作是数据分析中常用的功能。本文将深入探讨Pandas中的GroupBy和Sum操作,介绍它们的使用方法、常见场景以及注意事项,帮助您更好地掌握这些工具,提高数据处理效率。

1. GroupBy操作基础

GroupBy操作是Pandas中用于数据分组的核心功能。它允许我们按照一个或多个列的值将数据分成不同的组,然后对每个组进行独立的操作。

1.1 基本语法

GroupBy的基本语法如下:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 按单列分组

grouped = df.groupby('website')

# 按多列分组

grouped_multi = df.groupby(['website', 'category'])

在这个例子中,我们首先创建了一个包含网站访问数据的DataFrame。然后,我们使用groupby()方法按照’website’列进行分组,以及按照’website’和’category’两列进行多列分组。

1.2 GroupBy对象的特性

GroupBy对象本身并不包含实际的数据,而是一个中间对象,用于后续的聚合操作。我们可以通过以下方式查看GroupBy对象的一些属性:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 按website列分组

grouped = df.groupby('website')

# 查看分组的键

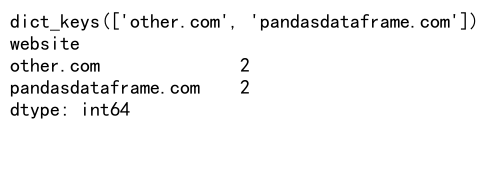

print(grouped.groups.keys())

# 查看每个分组的大小

print(grouped.size())

Output:

这个例子展示了如何查看GroupBy对象的分组键和每个分组的大小。这些信息对于理解数据的分布很有帮助。

2. Sum操作详解

Sum操作是对数据进行求和的基本统计方法。在Pandas中,我们可以对整个DataFrame、特定列或者分组后的数据进行求和操作。

2.1 对整个DataFrame求和

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com'],

'visits': [100, 150, 200],

'bounce_rate': [0.2, 0.3, 0.25]

}

df = pd.DataFrame(data)

# 对所有数值列求和

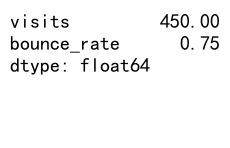

total_sum = df.sum(numeric_only=True)

print(total_sum)

Output:

这个例子展示了如何对DataFrame中的所有数值列进行求和。numeric_only=True参数确保只对数值类型的列进行操作。

2.2 对特定列求和

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com'],

'visits': [100, 150, 200],

'bounce_rate': [0.2, 0.3, 0.25]

}

df = pd.DataFrame(data)

# 对visits列求和

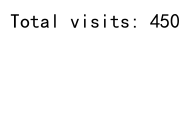

total_visits = df['visits'].sum()

print(f"Total visits: {total_visits}")

Output:

这个例子展示了如何对DataFrame中的特定列(在这里是’visits’列)进行求和操作。

3. GroupBy和Sum的结合使用

GroupBy和Sum的结合使用是数据分析中的常见操作,它允许我们对分组后的数据进行汇总计算。

3.1 基本分组求和

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 按website分组并求和visits

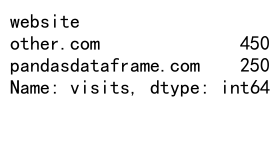

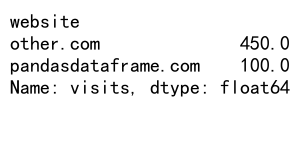

grouped_sum = df.groupby('website')['visits'].sum()

print(grouped_sum)

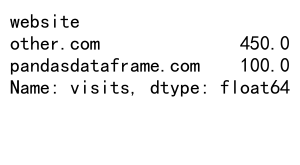

Output:

这个例子展示了如何按’website’列分组,然后对’visits’列进行求和。结果会显示每个网站的总访问量。

3.2 多列分组求和

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250],

'bounce_rate': [0.2, 0.3, 0.25, 0.35]

}

df = pd.DataFrame(data)

# 按website和category分组,并对visits和bounce_rate求和

grouped_sum = df.groupby(['website', 'category']).sum()

print(grouped_sum)

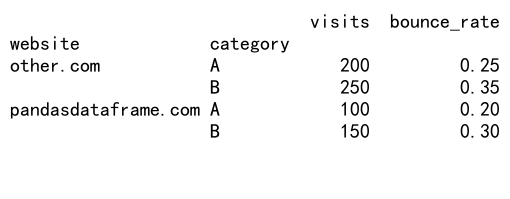

Output:

这个例子展示了如何按多个列(’website’和’category’)进行分组,然后对所有数值列(’visits’和’bounce_rate’)进行求和。

4. 高级GroupBy Sum技巧

除了基本的分组求和操作,Pandas还提供了一些高级技巧,可以让我们更灵活地处理数据。

4.1 使用agg()方法进行多种聚合

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250],

'bounce_rate': [0.2, 0.3, 0.25, 0.35]

}

df = pd.DataFrame(data)

# 使用agg()方法进行多种聚合

result = df.groupby('website').agg({

'visits': ['sum', 'mean'],

'bounce_rate': ['min', 'max']

})

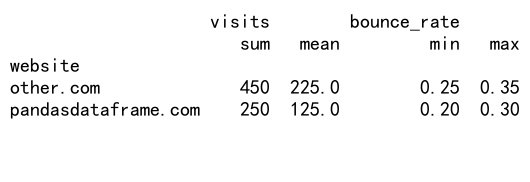

print(result)

Output:

这个例子展示了如何使用agg()方法对不同列应用不同的聚合函数。我们对’visits’列计算了总和和平均值,对’bounce_rate’列计算了最小值和最大值。

4.2 自定义聚合函数

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 自定义聚合函数

def visit_range(x):

return x.max() - x.min()

# 应用自定义聚合函数

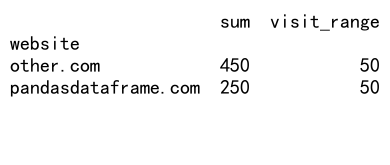

result = df.groupby('website')['visits'].agg(['sum', visit_range])

print(result)

Output:

这个例子展示了如何创建和应用自定义聚合函数。我们定义了一个visit_range函数来计算访问量的范围(最大值减最小值),然后将其与内置的sum函数一起应用于分组后的数据。

5. 处理缺失值

在进行GroupBy和Sum操作时,处理缺失值是一个常见的问题。Pandas提供了多种方法来处理这种情况。

5.1 使用fillna()填充缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, np.nan, 200, 250]

}

df = pd.DataFrame(data)

# 填充缺失值后进行分组求和

result = df.fillna(0).groupby('website')['visits'].sum()

print(result)

Output:

这个例子展示了如何在进行分组求和之前,使用fillna()方法将缺失值填充为0。这样可以确保所有数据都参与到求和计算中。

5.2 使用dropna()删除包含缺失值的行

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, np.nan, 200, 250]

}

df = pd.DataFrame(data)

# 删除包含缺失值的行后进行分组求和

result = df.dropna().groupby('website')['visits'].sum()

print(result)

Output:

这个例子展示了如何在进行分组求和之前,使用dropna()方法删除包含缺失值的行。这种方法适用于我们不希望缺失值影响结果的情况。

6. 处理大数据集

当处理大型数据集时,GroupBy和Sum操作可能会变得很慢。以下是一些提高性能的技巧。

6.1 使用categoricals加速分组

import pandas as pd

import numpy as np

# 创建大型示例数据集

n = 1000000

data = {

'website': np.random.choice(['pandasdataframe.com', 'other.com'], n),

'category': np.random.choice(['A', 'B', 'C'], n),

'visits': np.random.randint(1, 1000, n)

}

df = pd.DataFrame(data)

# 将分组列转换为category类型

df['website'] = df['website'].astype('category')

# 进行分组求和

result = df.groupby('website')['visits'].sum()

print(result)

这个例子展示了如何将分组列转换为category类型,这可以显著提高大数据集的分组性能。

6.2 使用chunk处理超大数据集

import pandas as pd

def process_chunk(chunk):

return chunk.groupby('website')['visits'].sum()

# 假设我们有一个大型CSV文件 'large_data.csv'

chunk_size = 100000

result = pd.DataFrame()

for chunk in pd.read_csv('large_data.csv', chunksize=chunk_size):

chunk_result = process_chunk(chunk)

result = result.add(chunk_result, fill_value=0)

print(result)

这个例子展示了如何使用chunk处理方法来处理无法一次性加载到内存中的超大数据集。我们逐块读取数据,对每个块进行处理,然后将结果累加起来。

7. GroupBy Sum的常见应用场景

GroupBy和Sum操作在许多实际场景中都有广泛应用。以下是一些常见的应用场景。

7.1 销售数据分析

import pandas as pd

# 创建销售数据

sales_data = {

'date': pd.date_range(start='2023-01-01', periods=10),

'product': ['A', 'B', 'A', 'C', 'B', 'A', 'C', 'B', 'A', 'C'],

'sales': [100, 150, 200, 120, 180, 220, 130, 160, 210, 140]

}

df = pd.DataFrame(sales_data)

# 按产品分组并计算总销售额

product_sales = df.groupby('product')['sales'].sum().sort_values(ascending=False)

print("Total sales by product:")

print(product_sales)

# 按月份分组并计算总销售额

df['month'] = df['date'].dt.to_period('M')

monthly_sales = df.groupby('month')['sales'].sum()

print("\nTotal sales by month:")

print(monthly_sales)

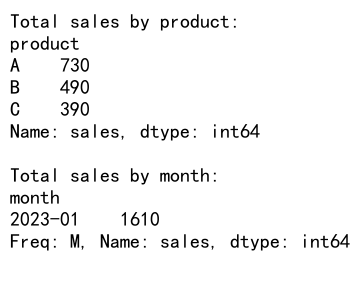

Output:

这个例子展示了如何使用GroupBy和Sum来分析销售数据。我们首先按产品分组计算总销售额,然后按月份分组计算月度销售额。

7.2 网站流量分析

import pandas as pd

import numpy as np

# 创建网站流量数据

traffic_data = {

'date': pd.date_range(start='2023-01-01', periods=100),

'website': np.random.choice(['pandasdataframe.com', 'other.com'], 100),

'page_views': np.random.randint(1000, 10000, 100),

'unique_visitors': np.random.randint(500, 5000, 100)

}

df = pd.DataFrame(traffic_data)

# 按网站分组并计算总页面浏览量和独立访客数

site_traffic = df.groupby('website').agg({

'page_views': 'sum',

'unique_visitors': 'sum'

})

print("Traffic by website:")

print(site_traffic)

# 计算每日平均流量

df['day_of_week'] = df['date'].dt.day_name()

daily_avg_traffic = df.groupby('day_of_week').agg({

'page_views': 'mean',

'unique_visitors': 'mean'

})

print("\nAverage daily traffic:")

print(daily_avg_traffic)

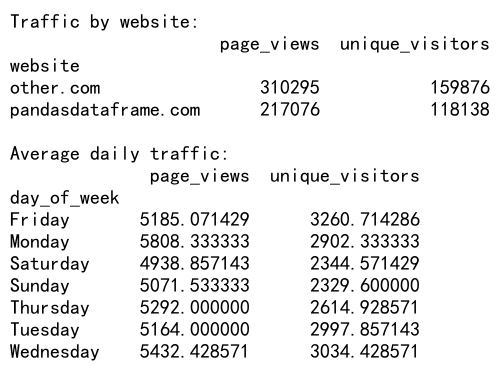

Output:

这个例子展示了如何使用GroupBy和Sum来分析网站流量数据。我们首先按网站分组计算总页面浏览量和独立访客数,然后计算每天的平均流量。

8. GroupBy Sum的注意事项

在使用GroupBy和Sum操作时,有一些注意事项需要考虑,以确保结果的准确性和可靠性。

8.1 数据类型的影响

import pandas as pd

# 创建包含不同数据类型的示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, '150', 200, 250], # 注意:'150'是字符串

'revenue': [1000.5, 1500.75, 2000.25, 2500.0]

}

df = pd.DataFrame(data)

# 尝试直接进行分组求和

try:

result = df.groupby('website').sum()

print(result)

except TypeError as e:

print(f"Error: {e}")

# 正确处理:先转换数据类型

df['visits'] = pd.to_numeric(df['visits'], errors='coerce')

result = df.groupby('website').sum()

print("\nAfter type conversion:")

print(result)

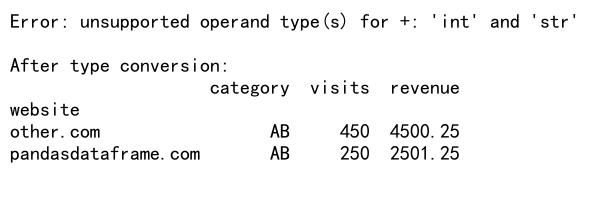

Output:

这个例子展示了数据类型对GroupBy Sum操作的影响。当数据包含混合类型(如数字和字符串)时,可能会导致错误。通过适当的数据类型转换,我们可以解决这个问题。

8.2 处理重复索引

import pandas as pd

# 创建包含重复索引的示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'A', 'B', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

df.set_index(['website', 'category'], inplace=True)

# 显示原始数据

print("Original data:")

print(df)

# 尝试对重复索引进行求和

result = df.sum(level='website')

print("\nSum with duplicate index:")

print(result)

# 正确处理:先处理重复索引

df_unique = df.groupby(level=[0, 1]).sum()

result = df_unique.sum(level='website')

print("\nSum after handling duplicate index:")

print(result)

这个例子展示了如何处理包含重复索引的数据。当直接对包含重复索引的数据进行求和时,可能会得到不正确的结果。通过先对重复索引进行处理,我们可以获得正确的汇总结果。

9. GroupBy Sum的性能优化

在处理大型数据集时,GroupBy Sum操作的性能可能会成为一个问题。以下是一些优化性能的技巧。

9.1 使用numba加速

import pandas as pd

import numpy as np

from numba import jit

# 创建大型示例数据集

n = 1000000

data = {

'website': np.random.choice(['pandasdataframe.com', 'other.com'], n),

'visits': np.random.randint(1, 1000, n)

}

df = pd.DataFrame(data)

# 定义numba加速的函数

@jit(nopython=True)

def fast_group_sum(values, groups):

result = np.zeros(len(np.unique(groups)))

for i in range(len(values)):

result[groups[i]] += values[i]

return result

# 使用numba加速的GroupBy Sum

group_keys = pd.factorize(df['website'])[0]

result = fast_group_sum(df['visits'].values, group_keys)

# 创建结果DataFrame

result_df = pd.DataFrame({

'website': pd.unique(df['website']),

'total_visits': result

})

print(result_df)

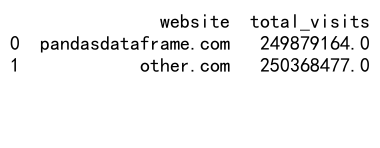

Output:

这个例子展示了如何使用numba库来加速GroupBy Sum操作。通过使用JIT编译,我们可以显著提高大数据集的处理速度。

9.2 使用并行处理

import pandas as pd

import numpy as np

from multiprocessing import Pool

# 创建大型示例数据集

n = 1000000

data = {

'website': np.random.choice(['pandasdataframe.com', 'other.com'], n),

'visits': np.random.randint(1, 1000, n)

}

df = pd.DataFrame(data)

# 定义并行处理函数

def parallel_group_sum(group):

return group['visits'].sum()

# 使用并行处理进行GroupBy Sum

if __name__ == '__main__':

grouped = df.groupby('website')

with Pool() as p:

results = p.map(parallel_group_sum, [group for name, group in grouped])

result_df = pd.DataFrame({

'website': grouped.groups.keys(),

'total_visits': results

})

print(result_df)

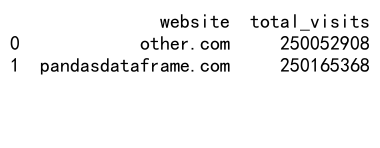

Output:

这个例子展示了如何使用Python的multiprocessing模块来并行处理GroupBy Sum操作。通过将数据分割成多个部分并同时处理,我们可以充分利用多核处理器的优势。

10. GroupBy Sum在数据可视化中的应用

GroupBy Sum操作常常与数据可视化结合使用,以更直观地展示数据分析结果。

10.1 使用matplotlib创建柱状图

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'],

'category': ['A', 'B', 'A', 'B'],

'visits': [100, 150, 200, 250]

}

df = pd.DataFrame(data)

# 进行GroupBy Sum操作

result = df.groupby('website')['visits'].sum()

# 创建柱状图

plt.figure(figsize=(10, 6))

result.plot(kind='bar')

plt.title('Total Visits by Website')

plt.xlabel('Website')

plt.ylabel('Total Visits')

plt.xticks(rotation=45)

plt.tight_layout()

plt.show()

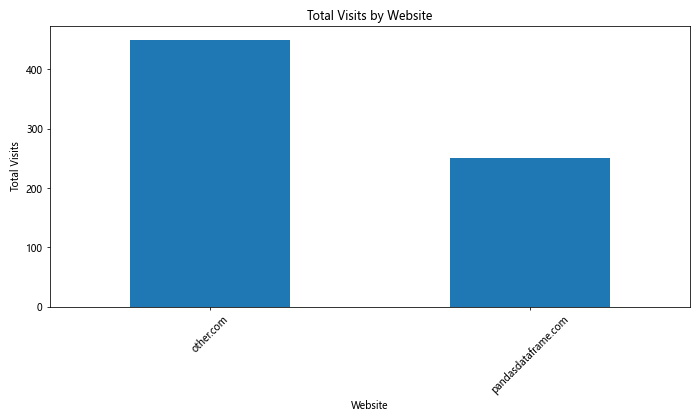

Output:

这个例子展示了如何将GroupBy Sum的结果使用matplotlib库创建柱状图。这种可视化方式可以直观地比较不同网站的总访问量。

10.2 使用seaborn创建热力图

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'other.com', 'other.com'] * 3,

'category': ['A', 'B', 'A', 'B'] * 3,

'day': ['Monday', 'Monday', 'Monday', 'Monday', 'Tuesday', 'Tuesday', 'Tuesday', 'Tuesday', 'Wednesday', 'Wednesday', 'Wednesday', 'Wednesday'],

'visits': [100, 150, 200, 250, 120, 180, 220, 280, 110, 160, 210, 260]

}

df = pd.DataFrame(data)

# 进行GroupBy Sum操作

result = df.groupby(['website', 'day'])['visits'].sum().unstack()

# 创建热力图

plt.figure(figsize=(12, 8))

sns.heatmap(result, annot=True, cmap='YlOrRd', fmt='g')

plt.title('Total Visits by Website and Day')

plt.xlabel('Day')

plt.ylabel('Website')

plt.tight_layout()

plt.show()

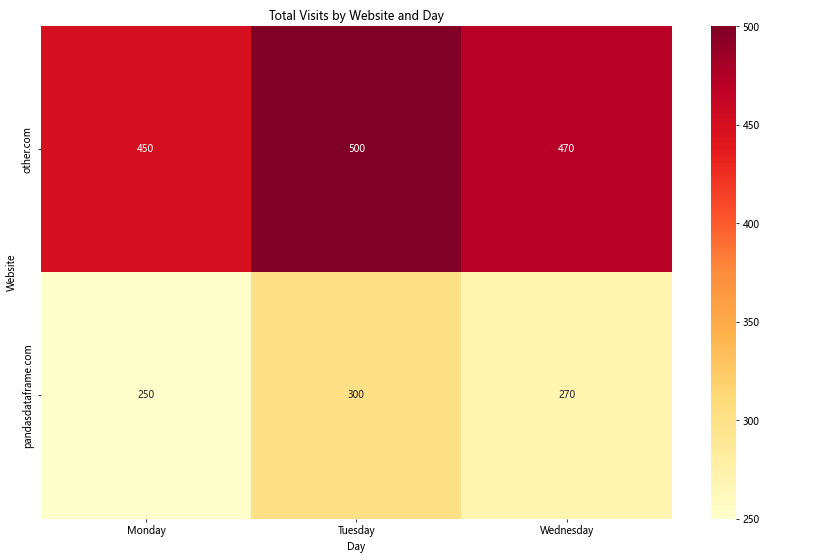

Output:

这个例子展示了如何将GroupBy Sum的结果使用seaborn库创建热力图。热力图可以有效地展示多维度的数据关系,如不同网站在不同日期的访问量分布。

结论

Pandas的GroupBy Sum操作是数据分析中不可或缺的工具。通过本文的详细介绍,我们深入探讨了GroupBy和Sum的基本概念、高级技巧、注意事项以及性能优化方法。从基本的分组求和到处理大型数据集,从处理缺失值到创建可视化图表,我们涵盖了广泛的应用场景和实用技巧。

掌握这些技能将使您能够更有效地处理和分析复杂的数据集。无论是在商业分析、科学研究还是日常数据处理中,GroupBy Sum都是一个强大而灵活的工具。通过不断实践和探索,您将能够充分发挥Pandas的潜力,提高数据分析的效率和质量。

记住,数据分析是一个不断学习和改进的过程。随着您经验的积累,您将发现更多创新的方法来应用GroupBy Sum,解决更复杂的数据问题。继续探索、实验和学习,您的数据分析技能将不断提升,为您的工作和研究带来更大的价值。

极客教程

极客教程