Pandas GroupBy和Bins:高效数据分组与区间划分技巧

Pandas是Python中强大的数据处理库,其中GroupBy和Bins功能为数据分析提供了强大的支持。本文将深入探讨Pandas中GroupBy和Bins的使用方法、应用场景以及相关技巧,帮助您更好地掌握这些工具,提升数据处理效率。

1. GroupBy基础

GroupBy是Pandas中用于数据分组的核心功能。它允许我们按照一个或多个列的值将数据分成不同的组,然后对每个组进行聚合操作。

1.1 基本用法

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

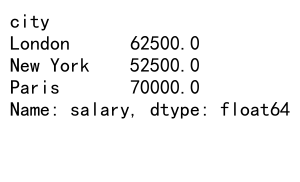

# 按城市分组并计算平均工资

grouped = df.groupby('city')['salary'].mean()

print(grouped)

Output:

在这个例子中,我们首先创建了一个包含姓名、年龄、城市和工资信息的DataFrame。然后,我们使用groupby('city')按城市对数据进行分组,并计算每个城市的平均工资。

1.2 多列分组

GroupBy支持多列分组,这在处理复杂数据时非常有用:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Frank'],

'department': ['HR', 'IT', 'Finance', 'HR', 'IT', 'Finance'],

'gender': ['F', 'M', 'M', 'M', 'F', 'M'],

'salary': [50000, 60000, 70000, 55000, 65000, 75000]

}

df = pd.DataFrame(data)

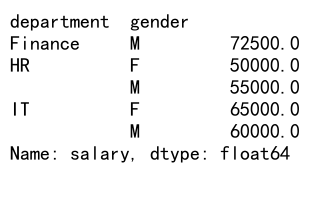

# 按部门和性别分组,计算平均工资

grouped = df.groupby(['department', 'gender'])['salary'].mean()

print(grouped)

Output:

这个例子展示了如何按部门和性别进行多列分组,并计算每个组合的平均工资。

2. GroupBy高级操作

除了基本的分组和聚合,GroupBy还提供了许多高级操作,使数据分析更加灵活和强大。

2.1 自定义聚合函数

您可以使用自定义函数进行聚合操作:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'product': ['A', 'B', 'A', 'B', 'A', 'B'],

'sales': [100, 200, 150, 250, 180, 220],

'date': pd.date_range(start='2023-01-01', periods=6)

}

df = pd.DataFrame(data)

# 自定义聚合函数

def custom_agg(x):

return pd.Series({

'total_sales': x.sum(),

'avg_sales': x.mean(),

'sales_range': x.max() - x.min()

})

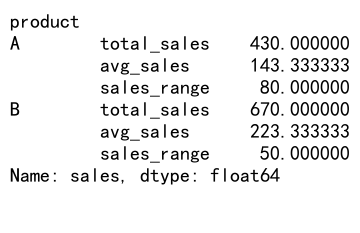

# 按产品分组并应用自定义聚合函数

result = df.groupby('product')['sales'].apply(custom_agg)

print(result)

Output:

这个例子展示了如何创建一个自定义聚合函数,计算总销售额、平均销售额和销售范围,并将其应用于按产品分组的数据。

2.2 转换操作

GroupBy还支持转换操作,可以在保持原始数据结构的同时对数据进行修改:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'department': ['HR', 'IT', 'Finance', 'HR', 'IT'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

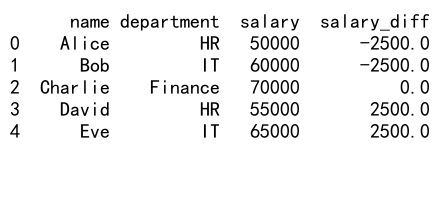

# 计算每个部门的平均工资,并添加一列显示每个员工的工资与部门平均工资的差异

df['salary_diff'] = df.groupby('department')['salary'].transform(lambda x: x - x.mean())

print(df)

Output:

在这个例子中,我们使用transform方法计算每个部门的平均工资,并创建一个新列来显示每个员工的工资与其所在部门平均工资的差异。

3. Bins基础

Bins是Pandas中用于将连续数据划分为离散区间的工具。它在数据分析和可视化中非常有用,特别是在处理大量数据时。

3.1 使用cut函数

pd.cut函数是创建bins的主要方法之一:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'score': np.random.randint(0, 101, 1000)

}

df = pd.DataFrame(data)

# 使用cut函数创建分数区间

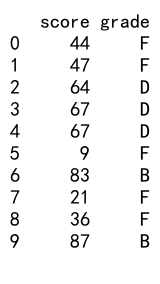

df['grade'] = pd.cut(df['score'], bins=[0, 60, 70, 80, 90, 100], labels=['F', 'D', 'C', 'B', 'A'])

print(df.head(10))

Output:

在这个例子中,我们创建了一个包含1000个随机分数的DataFrame,然后使用pd.cut函数将分数划分为5个等级。

3.2 使用qcut函数

pd.qcut函数用于创建基于分位数的bins:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'salary': np.random.randint(30000, 100001, 1000)

}

df = pd.DataFrame(data)

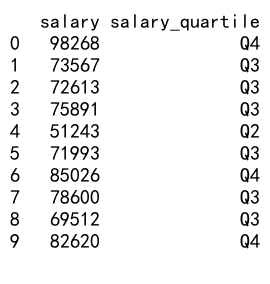

# 使用qcut函数创建工资四分位数

df['salary_quartile'] = pd.qcut(df['salary'], q=4, labels=['Q1', 'Q2', 'Q3', 'Q4'])

print(df.head(10))

Output:

这个例子展示了如何使用pd.qcut函数将工资数据划分为四个等大小的区间(四分位数)。

4. GroupBy和Bins结合使用

GroupBy和Bins的结合使用可以帮助我们更好地分析和理解数据分布。

4.1 按区间分组统计

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'age': np.random.randint(18, 71, 1000),

'income': np.random.randint(20000, 100001, 1000)

}

df = pd.DataFrame(data)

# 创建年龄区间

df['age_group'] = pd.cut(df['age'], bins=[18, 30, 40, 50, 60, 70], labels=['18-30', '31-40', '41-50', '51-60', '61-70'])

# 按年龄组分组并计算平均收入

result = df.groupby('age_group')['income'].mean()

print(result)

这个例子展示了如何创建年龄区间,然后按这些区间对数据进行分组,并计算每个年龄组的平均收入。

4.2 动态创建Bins

有时我们需要根据数据的分布动态创建Bins:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'value': np.random.exponential(scale=1000, size=1000)

}

df = pd.DataFrame(data)

# 动态创建bins

num_bins = 5

df['bin'] = pd.qcut(df['value'], q=num_bins, labels=[f'Q{i+1}' for i in range(num_bins)])

# 按bin分组并计算统计信息

result = df.groupby('bin').agg({

'value': ['count', 'mean', 'min', 'max']

})

print(result)

在这个例子中,我们使用pd.qcut函数动态创建5个等大小的区间,然后对每个区间进行统计分析。

5. 高级应用场景

5.1 时间序列数据分析

GroupBy和Bins在时间序列数据分析中非常有用:

import pandas as pd

import numpy as np

# 创建示例时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'sales': np.random.randint(100, 1001, len(dates))

}

df = pd.DataFrame(data)

# 按月份分组

df['month'] = df['date'].dt.to_period('M')

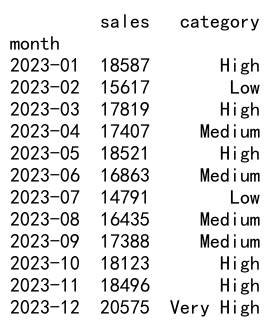

monthly_sales = df.groupby('month')['sales'].sum()

# 创建销售额区间

sales_bins = pd.cut(monthly_sales, bins=4, labels=['Low', 'Medium', 'High', 'Very High'])

result = pd.DataFrame({'sales': monthly_sales, 'category': sales_bins})

print(result)

Output:

这个例子展示了如何对全年的每日销售数据进行月度汇总,然后将月度销售额划分为不同的类别。

5.2 客户分群分析

GroupBy和Bins在客户分群分析中也有广泛应用:

import pandas as pd

import numpy as np

# 创建示例客户数据

np.random.seed(0)

data = {

'customer_id': range(1000),

'total_spend': np.random.exponential(scale=500, size=1000),

'frequency': np.random.poisson(lam=5, size=1000)

}

df = pd.DataFrame(data)

# 创建RFM分数

df['spend_score'] = pd.qcut(df['total_spend'], q=5, labels=[1, 2, 3, 4, 5])

df['frequency_score'] = pd.qcut(df['frequency'], q=5, labels=[1, 2, 3, 4, 5])

# 计算总分

df['total_score'] = df['spend_score'].astype(int) + df['frequency_score'].astype(int)

# 创建客户分群

df['customer_segment'] = pd.cut(df['total_score'], bins=[0, 4, 7, 10], labels=['Low Value', 'Medium Value', 'High Value'])

# 分析每个客户群的特征

result = df.groupby('customer_segment').agg({

'total_spend': 'mean',

'frequency': 'mean',

'customer_id': 'count'

}).rename(columns={'customer_id': 'count'})

print(result)

这个例子展示了如何使用RFM(Recency, Frequency, Monetary)模型对客户进行分群,并分析每个群体的特征。

6. 性能优化技巧

在处理大型数据集时,GroupBy和Bins操作可能会变得耗时。以下是一些优化技巧:

6.1 使用分类数据类型

对于重复值较多的列,使用分类数据类型可以显著提高性能:

import pandas as pd

import numpy as np

# 创建大型示例数据集

np.random.seed(0)

n = 1000000

data = {

'category': np.random.choice(['A', 'B', 'C', 'D', 'E'], n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 将category列转换为分类类型

df['category'] = df['category'].astype('category')

# 执行GroupBy操作

result = df.groupby('category')['value'].mean()

print(result)

在这个例子中,我们将’category’列转换为分类类型,这可以显著提高GroupBy操作的性能,特别是在处理大型数据集时。

6.2 使用numba加速

对于自定义聚合函数,可以使用numba来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

np.random.seed(0)

n = 1000000

data = {

'group': np.random.choice(['A', 'B', 'C', 'D', 'E'], n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 使用numba加速的自定义聚合函数

@jit(nopython=True)

def custom_agg(values):

return np.mean(values) * np.median(values)

# 执行GroupBy操作

result = df.groupby('group')['value'].agg(custom_agg)

print(result)

这个例子展示了如何使用numba来加速自定义聚合函数的计算。

7. 常见陷阱和注意事项

在使用GroupBy和Bins时,有一些常见的陷阱需要注意:

7.1 处理缺失值

GroupBy和Bins操作默认会排除缺失值,这可能会导致意外的结果:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C', 'C'],

'value': [1, 2, 3, np.nan, 5, 6]

}

df = pd.DataFrame(data)

# 默认情况下的GroupBy操作

result_default = df.groupby('group')['value'].mean()

print("Default result:")

print(result_default)

# 包含缺失值的GroupBy操作```python

result_with_na = df.groupby('group')['value'].mean(skipna=False)

print("\nResult including NaN:")

print(result_with_na)

在这个例子中,我们可以看到默认情况下GroupBy操作会忽略缺失值,而通过设置skipna=False,我们可以在结果中包含缺失值的影响。

7.2 Bins边界问题

在创建Bins时,需要注意边界值的处理:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'value': [0, 10, 20, 30, 40, 50, 60, 70, 80, 90, 100]

}

df = pd.DataFrame(data)

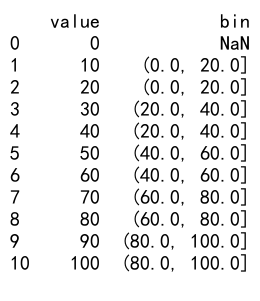

# 创建bins

df['bin'] = pd.cut(df['value'], bins=[0, 20, 40, 60, 80, 100])

print(df)

Output:

在这个例子中,我们需要注意边界值(如0和100)是如何被分配到不同的bin中的。默认情况下,左边界是闭区间,右边界是开区间。

8. 与其他Pandas功能的结合使用

GroupBy和Bins可以与Pandas的其他功能结合使用,以实现更复杂的数据分析任务。

8.1 与Pivot Tables结合

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'product': np.random.choice(['A', 'B', 'C'], 365),

'sales': np.random.randint(100, 1001, 365)

}

df = pd.DataFrame(data)

# 创建月份和季度列

df['month'] = df['date'].dt.to_period('M')

df['quarter'] = df['date'].dt.to_period('Q')

# 创建销售额区间

df['sales_category'] = pd.cut(df['sales'], bins=[0, 300, 600, 1000], labels=['Low', 'Medium', 'High'])

# 创建pivot table

pivot = pd.pivot_table(df, values='sales', index=['quarter', 'product'], columns='sales_category', aggfunc='count', fill_value=0)

print(pivot)

这个例子展示了如何将GroupBy、Bins和Pivot Tables结合使用,创建一个按季度、产品和销售额类别的销售频次统计表。

8.2 与Resampling结合

对于时间序列数据,我们可以将GroupBy和Bins与Resampling结合使用:

import pandas as pd

import numpy as np

# 创建示例时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='H')

data = {

'timestamp': dates,

'value': np.random.randn(len(dates))

}

df = pd.DataFrame(data)

# 按天重采样并计算每日统计

daily_stats = df.resample('D', on='timestamp').agg({

'value': ['mean', 'std', 'min', 'max']

})

# 创建每日波动率区间

daily_stats['volatility'] = daily_stats[('value', 'std')] / daily_stats[('value', 'mean')].abs()

daily_stats['volatility_category'] = pd.cut(daily_stats['volatility'], bins=3, labels=['Low', 'Medium', 'High'])

# 按月份和波动率类别分组

monthly_summary = daily_stats.groupby([daily_stats.index.to_period('M'), 'volatility_category']).size().unstack(fill_value=0)

print(monthly_summary)

这个例子展示了如何对高频时间序列数据进行重采样,计算每日统计数据,然后创建波动率区间,最后按月份和波动率类别进行汇总。

9. 实际应用案例

让我们通过一个更复杂的实际应用案例来综合运用GroupBy和Bins的知识。

9.1 电商销售数据分析

假设我们有一个电商平台的销售数据,我们要对其进行全面的分析:

import pandas as pd

import numpy as np

# 创建模拟的电商销售数据

np.random.seed(0)

n = 10000

data = {

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='H')[:n],

'customer_id': np.random.randint(1, 1001, n),

'product_id': np.random.randint(1, 101, n),

'category': np.random.choice(['Electronics', 'Clothing', 'Books', 'Home', 'Sports'], n),

'price': np.random.uniform(10, 1000, n).round(2),

'quantity': np.random.randint(1, 11, n)

}

df = pd.DataFrame(data)

df['total_amount'] = df['price'] * df['quantity']

# 1. 按月份和产品类别分析销售趋势

monthly_sales = df.groupby([df['date'].dt.to_period('M'), 'category'])['total_amount'].sum().unstack()

print("Monthly sales by category:")

print(monthly_sales)

# 2. 客户消费行为分析

customer_behavior = df.groupby('customer_id').agg({

'total_amount': 'sum',

'date': lambda x: (x.max() - x.min()).days,

'product_id': 'nunique'

}).rename(columns={'date': 'active_days', 'product_id': 'unique_products'})

customer_behavior['avg_order_value'] = customer_behavior['total_amount'] / customer_behavior['unique_products']

# 创建客户分群

customer_behavior['total_amount_group'] = pd.qcut(customer_behavior['total_amount'], q=3, labels=['Low', 'Medium', 'High'])

customer_behavior['frequency_group'] = pd.qcut(customer_behavior['unique_products'], q=3, labels=['Low', 'Medium', 'High'])

print("\nCustomer behavior summary:")

print(customer_behavior.groupby(['total_amount_group', 'frequency_group']).agg({

'customer_id': 'count',

'total_amount': 'mean',

'active_days': 'mean',

'unique_products': 'mean',

'avg_order_value': 'mean'

}))

# 3. 产品表现分析

product_performance = df.groupby('product_id').agg({

'total_amount': 'sum',

'quantity': 'sum',

'customer_id': 'nunique'

}).rename(columns={'customer_id': 'unique_customers'})

product_performance['avg_price'] = product_performance['total_amount'] / product_performance['quantity']

# 创建产品分群

product_performance['sales_rank'] = pd.qcut(product_performance['total_amount'], q=5, labels=['Very Low', 'Low', 'Medium', 'High', 'Very High'])

print("\nProduct performance summary:")

print(product_performance.groupby('sales_rank').agg({

'product_id': 'count',

'total_amount': 'mean',

'quantity': 'mean',

'unique_customers': 'mean',

'avg_price': 'mean'

}))

# 4. 时间模式分析

df['hour'] = df['date'].dt.hour

df['weekday'] = df['date'].dt.weekday

hourly_sales = df.groupby('hour')['total_amount'].mean()

weekday_sales = df.groupby('weekday')['total_amount'].mean()

print("\nHourly sales pattern:")

print(hourly_sales)

print("\nWeekday sales pattern:")

print(weekday_sales)

这个综合案例展示了如何使用GroupBy和Bins对电商销售数据进行多维度分析,包括:

1. 按月份和产品类别分析销售趋势

2. 客户消费行为分析和分群

3. 产品表现分析和分群

4. 销售的时间模式分析

通过这种方式,我们可以全面了解销售情况,识别高价值客户和热销产品,并发现销售的时间规律,为业务决策提供数据支持。

10. 总结

Pandas的GroupBy和Bins功能为数据分析提供了强大的工具。通过本文的详细介绍和丰富的示例,我们深入探讨了这些功能的使用方法、应用场景以及注意事项。从基础操作到高级应用,从性能优化到实际案例,我们全面覆盖了GroupBy和Bins的各个方面。

掌握这些技能将使您能够更有效地处理和分析复杂的数据集,提取有价值的洞察,并为决策提供数据支持。无论是在商业分析、科学研究还是其他领域,这些工具都将成为您数据分析工具箱中不可或缺的一部分。

随着数据量的不断增长和分析需求的日益复杂,熟练运用GroupBy和Bins将使您在数据分析领域保持竞争力。继续探索和实践这些功能,您将发现更多创新的方式来解释数据,揭示隐藏的模式,并推动数据驱动的决策。

极客教程

极客教程