在本节中,我们将介绍一些深度学习体系结构,这些架构已被证明对研究社区具有影响力。

LeNet

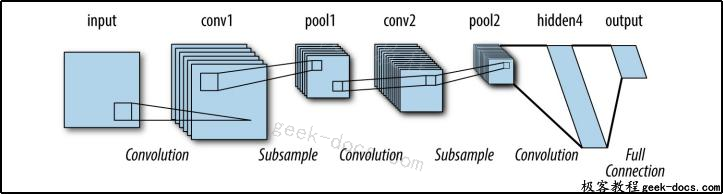

LeNet架构可以说是第一个突出的“深”卷积架构。自1988年引入以来,它被用于对文档进行光学字符重新编码(OCR)。尽管它出色地完成了它的任务,但是对于当时可用的计算机硬件来说,LeNet的计算成本是非常高的,所以在它创建之后的几十年里,它的设计一直处于(相对)默默无闻的状态。这种结构如图1所示。

图1。用于图像处理的LeNet体系结构。它于1988年推出,是第一种用于图像处理的深度卷积模型。

AlexNet

ImageNet大尺度视觉识别挑战(ILSVRC)于2010年首次被机构化,作为对视觉识别系统进展的测试。这些机构利用亚马逊土耳其机械公司(Amazon Mechanical Turk)的在线平台,将工人与请求者连接起来,将大量图片与图片中出现的相关物体列表进行分类。使用机械Turk可以收集比以前收集的数据大得多的数据。

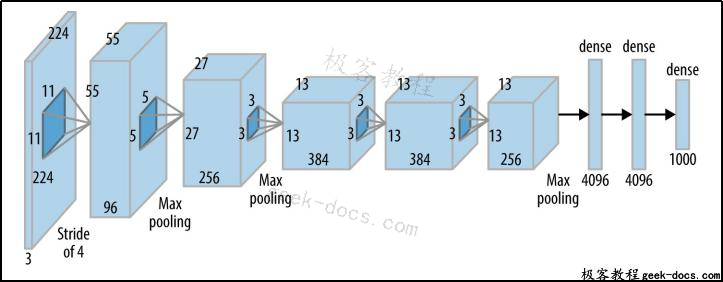

在最初的两年里,更传统的机器学习系统(依赖于HOG和SIFT等系统(手动调整的视觉特征提取方法))取得了胜利。在2012年,AlexNet架构,基于修改的LeNet运行在强大的图形处理单元(gpu),进入并主导了错误率只有最接近的竞争者的一半。这一戏剧性的胜利激发了计算机视觉领域的深度学习架构(已经初生的)趋势。AlexNet架构如图2所示。

图2。用于图像处理的AlexNet架构。该建筑是ILSVRC 2012年挑战赛的获奖作品,激发了人们对建筑体量的兴趣。

ResNet

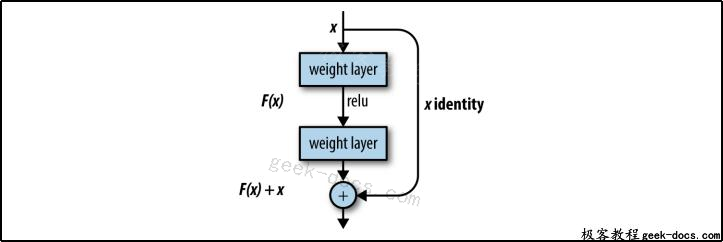

自2012年以来,卷积架构一直赢得ILSVRC挑战(以及许多其他计算机视觉挑战)。每一年的比赛,获胜的架构都在深度和复杂性上有所增加。2015年ILSVRC挑战赛冠军ResNet架构尤其引人注目;ResNet体系结构扩展到130层深,与8层AlexNet体系结构形成对比。

从历史上看,学习非常深刻的网络是很有挑战性的;当网络发展到如此之深时,就会遇到渐变消失的问题。当信号在网络中传播时就会减弱,导致学习能力下降。这种衰减可以用数学方法解释,但其影响是每增加一层都会成倍地降低信号强度,导致网络有效深度受到限制。

ResNet引入了一项控制这种衰减的创新:旁路连接。这些连接允许来自更深层次的部分信号不衰减地通过,使更深层的网络得到有效的训练。ResNet旁路连接如图3所示。

图3。ResNet细胞。右边的标识连接允许未经修改的输入版本通过单元格。这种修改允许对非常深的卷积架构进行有效的培训。

神经字幕模型

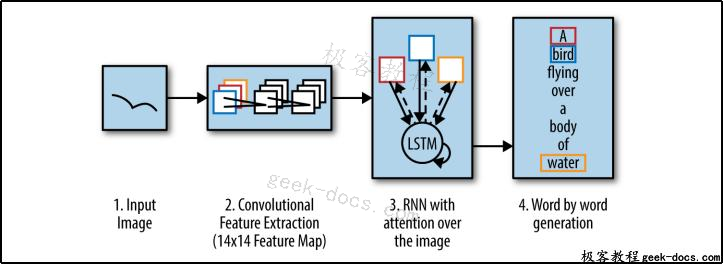

随着实践者越来越习惯使用深度学习基元,他们尝试混合和匹配基元模块来创建更高阶的系统,这些系统可以执行比基本对象检测更复杂的任务。神经字幕系统自动生成图像内容的字幕。它们通过将卷积网络(从图像中提取信息)与LSTM层(为图像生成描述性语句)相结合来实现这一目的。整个系统是端到端的训练。也就是说,卷积网络和LSTM网络一起训练,以达到为提供的图像生成描述性时态的预期目标。

这种端到端培训是现代深度学习系统的关键创新之一,因为它减少了对复杂输入预处理的需求。不使用深度学习的图像字幕模型将不得不使用复杂的图像特征化方法,比如SIFT,它不能与字幕生成器一起训练。

神经字幕模型如图4所示。

图4。神经字幕结构。利用卷积网络从输入图像中提取相关的输入特征。然后使用递归网络生成描述性句子。

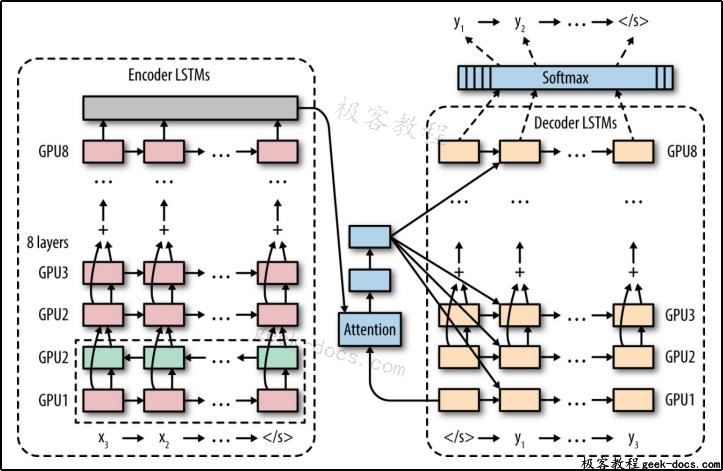

谷歌神经机器翻译

谷歌的神经机器翻译(Google- nmt)系统采用端到端训练的模式,构建了一个生产翻译系统,将原语言的句子直接翻译到目标语言。Google-NMT系统依赖于LSTM的基本构建块,它将LSTM堆叠十多次,并在一个非常大的翻译句子数据集中进行训练。最终的体系结构为机器翻译提供了突破性的进展,将人和机器翻译之间的差距减少了60%。谷歌- NMT体系结构如图5所示。

图5。谷歌神经机器翻译系统使用一个深层递归结构来处理输入句子,并使用第二个深层递归结构来生成翻译后的输出句子。

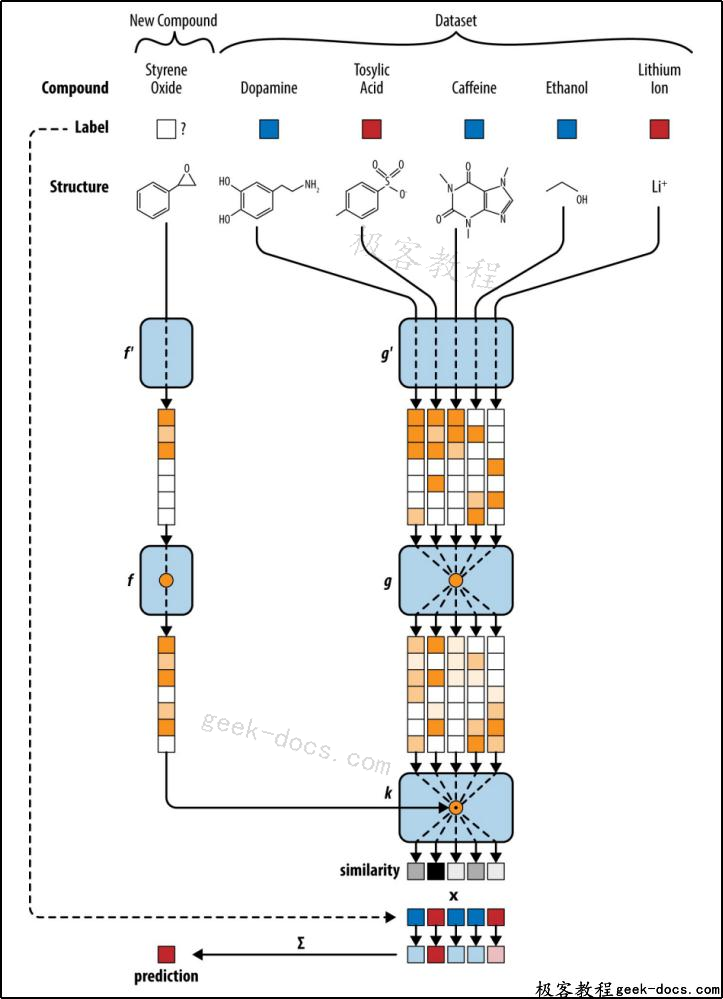

只有一次的模型

一次性学习可能是机器/深度学习中最有趣的新概念。大多数深度学习技术通常需要非常大量的数据来学习有意义的行为。例如,AlexNet体系结构利用大型ILSVRC数据集来学习可视化对象检测器。然而,认知科学的大量研究表明,人类可以从几个例子中学习复杂的概念。以婴儿第一次学习长颈鹿为例。在动物园里,一只长颈鹿被展示给一个婴儿看,从那时起,她可能就能学会识别她看到的所有长颈鹿了。

最近在深度学习方面的进展已经开始创造能够实现类似学习壮举的架构。只要给出一个概念的几个例子(但是给出了充足的侧信息来源),这样的系统就可以学习用很少的数据点做出有意义的预测。最近的一篇论文(由本书的一位作者撰写)使用了这一理念,证明了一次性架构甚至可以在婴儿无法学习的环境中学习,比如在医学药物发现中。图6显示了药物发现的一次性架构。

图6。这种一次性结构使用一种卷积网络将每个分子转换成矢量。将氧化苯乙烯的载体与实验数据集中的载体进行了比较。为查询保留最相似的数据点(tosylic acid)的标签。

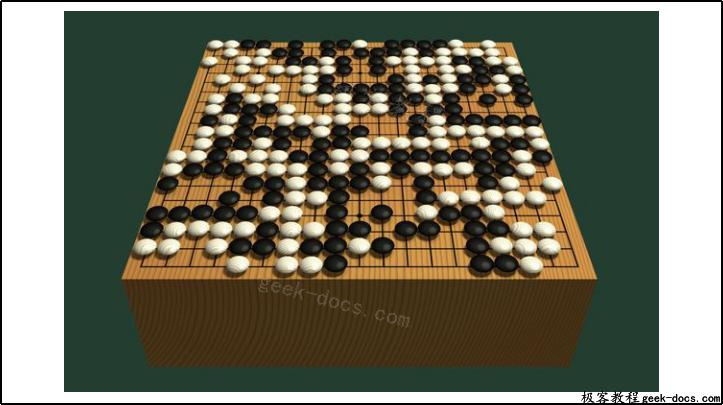

AlphaGo

围棋是一种古老的棋盘游戏,在亚洲有着广泛的影响。自20世纪60年代末以来,计算机围棋一直是计算机科学面临的一大挑战。1997年,电脑国际象棋系统“深蓝”(Deep Blue)击败国际象棋大师加里•卡斯帕罗夫(Garry Kasparov)的那些技术根本无法推广。部分原因在于,围棋的棋盘比国际象棋大得多;围棋棋盘的尺寸是19×19,而国际象棋棋盘的尺寸是8×8。由于每一步棋都有更多的走法,因此可能走法的游戏树扩展得更快,使得使用现代计算机硬件的蛮力搜索无法满足足够的走法游戏要求。图7展示了围棋棋盘。

图7。围棋板的插图。玩家交替放置黑白棋子在一个19×19的网格上。

Master level computer Go最终由AlphaGo从谷歌DeepMind实现。AlphaGo在一场五局的比赛中击败了世界最强的围棋冠军之一李世石(Lee Sedol)。AlphaGo的一些关键思想包括使用深度价值网络和深度策略网络。价值网络提供了董事会职位价值的评估。与国际象棋不同的是,从棋盘状态很难猜测出白棋或黑棋在围棋中获胜。价值网络通过学习从游戏结果中做出预测来解决这个问题。另一方面,政策网工作有助于评估在当前董事会状态下采取的最佳行动。这两种技术与蒙特卡罗树搜索(一种物理搜索方法)的结合帮助克服了围棋游戏中较大的分支因素。AlphaGo的基本架构如图8所示。

图1 – 8。A) AlphaGo架构描述。最初,选择移动的策略网络是在专家游戏的数据集上训练的。然后,这种策略通过自我游戏加以完善。“RL”表示强化学习,“SL”表示监督学习。B)策略网络和价值网络都是基于游戏板的表现来运作的。

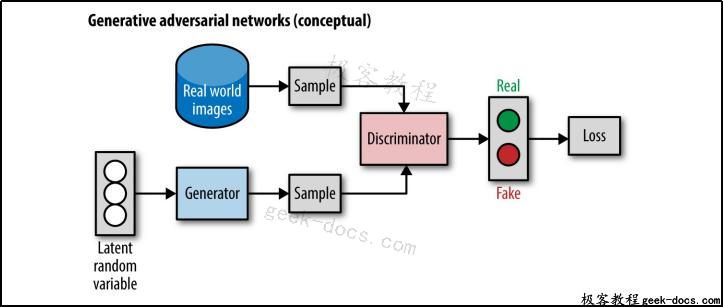

生成对抗网络

生成式对抗网络(GANs)是一种新型的深层网络,它使用两个相互竞争的神经网络,即生成器和对手(也称为dis – criminator),它们相互竞争。生成器尝试从训练分布中抽取样本(例如,尝试生成真实的鸟类图像)。鉴别器的工作是区分来自生成器的样本和真实数据样本。(一只特定的鸟是真实的图像还是生成器?)这种针对GANs的“adversa‐rial”训练似乎能够生成比其他技术保真度高得多的图像样本,并且可能对训练具有有限数据的有效描述器有用。GAN体系结构如图9所示。

图9。一个生成的敌对网络(GAN)的概念描述。

GANs已经被证明能够生成非常逼真的图像,并且很可能为下一代计算机图形工具提供动力。来自这类系统的样本现在正接近于光现实主义。然而,这些系统仍有许多理论和实践上的不足之处,还需要进行大量的研究。

神经图灵机

目前提出的大多数深度学习系统都学习了适用范围有限的复杂函数;例如,目标检测、图像字幕、机器翻译或围棋。但是,我们是否可能拥有能够学习一般算法概念(如排序、加法或乘法)的深层架构呢?

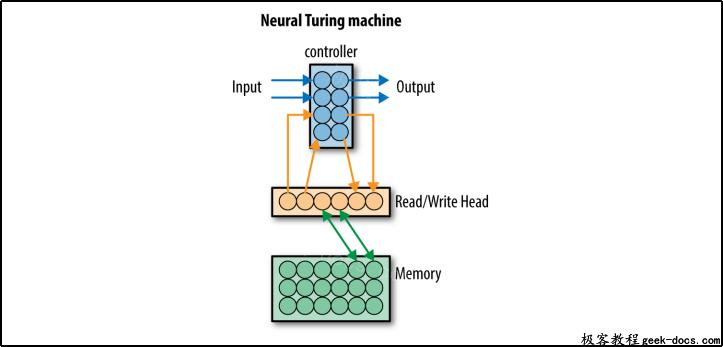

神经图灵机(NTM)是一种能够学习任意算法的深度学习结构的首次尝试。这种体系结构向类似于lstm的系统添加了一个外部内存库,以允许深层体系结构利用scratch空间来计算更复杂的函数。目前,类似于ntm的架构仍然非常有限,只能学习简单的算法。尽管如此,NTM方法仍然是一个活跃的研究领域,未来的进展可能会将这些早期的演示转化为实用的学习工具。NTM体系结构的概念如图10所示。

图10。神经图灵机的概念描述。它添加了一个外部内存库,用于深层架构的读写。

极客教程

极客教程