Spark Streaming 简介,Spark是一个批处理大数据计算引擎,主要针对大批量历史数据进行计算。同时Spark是一个快速计算的大数据引擎,它将原始数据分片后装载到集群中计算,对于数据量不是很大、过程不是很复杂的计算,可以在秒级甚至毫秒级完成处理。

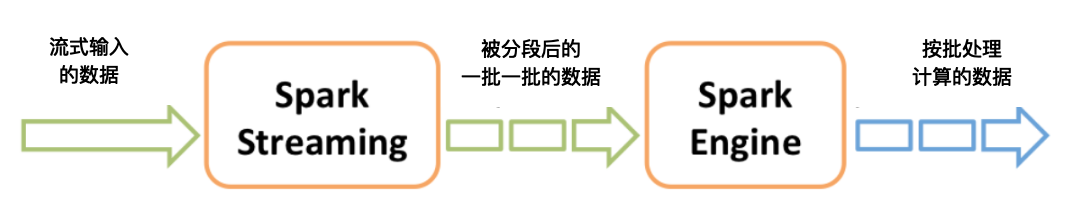

Spark Streaming巧妙地利用了Spark的分片和快速计算的特性,将实时传输进来的数据按照时间进行分段,把一段时间传输进来的数据合并在一起,当作一批数据,再去交给Spark去处理。下图这张图描述了Spark Streaming将数据分段、分批的过程。

如果时间段分得足够小,每一段的数据量就会比较小,再加上Spark引擎的处理速度又足够快,这样看起来好像数据是被实时处理的一样,这就是Spark Streaming实时流计算的奥妙。

这里要注意的是,在初始化Spark Streaming实例的时候,需要指定分段的时间间隔。下面代码示例中间隔是1秒。

val ssc = new StreamingContext(conf, Seconds(1))

当然你也可以指定更小的时间间隔,比如500ms,这样处理的速度就会更快。时间间隔的设定通常要考虑业务场景,比如你希望统计每分钟高速公路的车流量,那么时间间隔可以设为1分钟。

Spark Streaming主要负责将流数据转换成小的批数据,剩下的就可以交给Spark去做了。

极客教程

极客教程