HTML解析

HTML(HyperText Markup Language)是一种用于创建网页的标记语言,它由一系列标签组成,用于描述网页的结构和内容。在Web开发中,我们经常需要解析HTML文档,提取其中的信息或对其进行操作。本文将介绍如何使用不同的工具和技术来解析HTML文档,包括使用Python的Beautiful Soup库、JavaScript的DOM操作等。

使用Python解析HTML

Python是一种流行的编程语言,有许多库可以用来解析HTML文档。其中,Beautiful Soup是一个强大的库,可以帮助我们轻松地解析HTML文档并提取其中的信息。

示例1:解析HTML文档

from bs4 import BeautifulSoup

html_doc = """

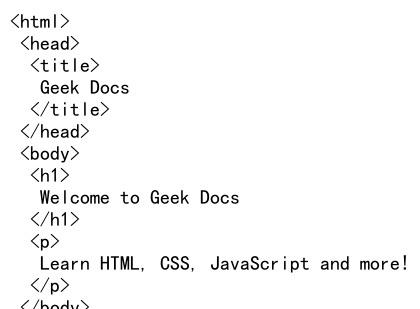

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

soup = BeautifulSoup(html_doc, 'html.parser')

print(soup.prettify())

Output:

示例2:提取标签内容

from bs4 import BeautifulSoup

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

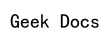

soup = BeautifulSoup(html_doc, 'html.parser')

title = soup.title

print(title.text)

Output:

示例3:查找所有标签

from bs4 import BeautifulSoup

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

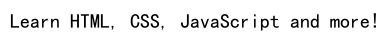

soup = BeautifulSoup(html_doc, 'html.parser')

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.text)

Output:

使用JavaScript解析HTML

除了Python外,JavaScript也是一种常用的语言,用于在网页上进行交互和操作。在前端开发中,我们经常需要使用DOM(Document Object Model)来解析HTML文档。

示例4:获取元素内容

var title = document.querySelector('h1');

console.log(title.textContent);

运行结果:

Welcome to Geek Docs

示例5:修改元素内容

var paragraph = document.querySelector('p');

paragraph.textContent = 'Learn HTML, CSS, JavaScript and more on Geek Docs';

运行结果:网页上的段落内容被修改为新的内容。

示例6:添加新元素

var newParagraph = document.createElement('p');

newParagraph.textContent = 'Join our community and start learning!';

document.body.appendChild(newParagraph);

运行结果:在网页上添加了一个新的段落元素。

使用XPath解析HTML

XPath是一种用于在XML文档中定位节点的语言,也可以用于解析HTML文档。在Python中,我们可以使用lxml库来解析HTML文档并使用XPath表达式来提取信息。

示例7:使用XPath提取元素内容

from lxml import html

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

tree = html.fromstring(html_doc)

title = tree.xpath('//title/text()')[0]

print(title)

示例8:使用XPath查找所有元素

from lxml import html

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

tree = html.fromstring(html_doc)

paragraphs = tree.xpath('//p/text()')

for p in paragraphs:

print(p)

运行结果:

Learn HTML, CSS, JavaScript and more!

使用正则表达式解析HTML

正则表达式是一种强大的模式匹配工具,也可以用来解析HTML文档。虽然不推荐在复杂的HTML文档中使用正则表达式,但在一些简单的情况下,它仍然是一种有效的解析工具。

示例9:使用正则表达式提取元素内容

import re

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

title_pattern = re.compile(r'<title>(.*?)</title>')

title = title_pattern.search(html_doc).group(1)

print(title)

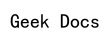

Output:

示例10:使用正则表达式查找所有元素

import re

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

paragraph_pattern = re.compile(r'<p>(.*?)</p>')

paragraphs = paragraph_pattern.findall(html_doc)

for p in paragraphs:

print(p)

Output:

运行结果:

Learn HTML, CSS, JavaScript and more!

使用API解析HTML

有些网站提供API接口,可以直接获取HTML文档的内容,而无需解析整个HTML文档。这种方式可以节省解析HTML文档的时间和资源。

示例11:使用API获取HTML内容

import requests

url = 'https://www.geek-docs.com'

response = requests.get(url)

html_doc = response.text

print(html_doc)

示例12:使用API提取特定信息

import requests

from bs4 import BeautifulSoup

url = 'https://www.geek-docs.com'

response = requests.get(url)

html_doc = response.text

soup = BeautifulSoup(html_doc, 'html.parser')

title = soup.title.text

print(title)

使用CSS选择器解析HTML

除了XPath外,我们还可以使用CSS选择器来解析HTML文档。在Python中,可以使用lxml库的cssselect模块来实现。

示例13:使用CSS选择器提取元素内容

from lxml import html

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

tree = html.fromstring(html_doc)

title = tree.cssselect('title')[0].text

print(title)

示例14:使用CSS选择器查找所有元素

from lxml import html

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

tree = html.fromstring(html_doc)

paragraphs = tree.cssselect('p')

for p in paragraphs:

print(p.text)

使用第三方库解析HTML

除了上述提到的库和技术外,还有许多第三方库可以用来解析HTML文档,如Scrapy、PyQuery等。这些库提供了更多的功能和选项,可以根据具体需求选择合适的库来解析HTML文档。

示例15:使用Scrapy解析HTML

Scrapy是一个强大的网络爬虫框架,可以用来解析HTML文档并提取信息。

import scrapy

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['https://www.geek-docs.com']

def parse(self, response):

title = response.css('title::text').get()

print(title)

运行结果:输出网站https://www.geek-docs.com 的标题。

示例16:使用PyQuery解析HTML### 示例16:使用PyQuery解析HTML

PyQuery是一个类似于jQuery的库,可以方便地解析HTML文档并进行操作。

from pyquery import PyQuery as pq

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

doc = pq(html_doc)

title = doc('title').text()

print(title)

示例17:使用PyQuery查找所有元素

from pyquery import PyQuery as pq

html_doc = """

<html>

<head>

<title>Geek Docs</title>

</head>

<body>

<h1>Welcome to Geek Docs</h1>

<p>Learn HTML, CSS, JavaScript and more!</p>

</body>

</html>

"""

doc = pq(html_doc)

paragraphs = doc('p')

for p in paragraphs.items():

print(p.text())

结语

本文介绍了如何使用不同的工具和技术来解析HTML文档,包括使用Python的Beautiful Soup库、JavaScript的DOM操作、XPath、正则表达式、API、CSS选择器以及一些第三方库。通过这些示例代码,读者可以更好地理解如何解析HTML文档并提取其中的信息,从而更好地进行Web开发和数据处理。

极客教程

极客教程